入選AAAI 2020,全新視頻語義分割和光流聯合學習算法問世

隔離疫情不隔離學習,讀論文也是很好的在家“充電”方式之一。

今日,第34屆人工智能頂級會議AAAI 2020正式開幕(2月7日-2月12日在美國紐約舉辦)。AAAI(Association for the Advance of Artificial Intelligence——美國人工智能協會)是人工智能領域的主要學術組織之一,其年會每年都吸引了大量來自學術界和產業界的研究員、開發者投稿,參會。

商湯科技研究團隊發表論文《Every Frame Counts: Joint Learning of Video Segmentation and Optical Flow》,創新性地將視頻語義分割和光流方法融合,極大提升了視頻分割的準確率和效率,該論文也被AAAI 2020錄用。這種方法在自動駕駛、機器人、人體姿態識別、AR特效等諸多場景均有廣泛應用前景。

那么這篇論文到底有哪些創新呢?下面一一解讀。

▎打破現有方法局限

現有的視頻語義分割方法,是利用前后幀的語義信息預測運動軌跡來分割,這種方法面臨兩大挑戰:

準確率低。視頻標注不如圖像標注那樣每一幀都會標注,一個視頻片段往往只標注一幀,現有方法難以利用全部的數據,導致分割的準確率較低。

效率低。由于對前后幀之間進行信息交互往往為模型引入額外的模塊,導致視頻分割效率低。

商湯在研究中改進了這些不足,提出了一個光流和語義分割聯合學習的框架。

圖1:現有方法和商湯算法比較

現有方法往往使用Feature aggregation將多幀信息融合到一起,然而這種方案僅僅利用了標注幀附近的少數幀(t, t-1, t+1)而且極大增加了網絡的計算時間。

本文的方法使用Temporal consistent constraint(時序一致性約束)為多幀的特征之間添加隱式約束,在不增加耗時的前提下利用更多數據學習到更魯棒的特征。

本文提出的聯合學習框架(如圖2),輸入圖片經過共享編碼器后分為兩個分支,上半部分是光流分支,下半部分是分割分支,以及時序一致性模塊(黃色)和遮擋估計模塊(灰色)。

圖2:光流和語義分割聯合學習框架

▎語義分割和光流相輔相成

本論文的語義分割和光流是相輔相成的,語義分割為光流和遮擋估計提供了更豐富的語義信息,而非遮擋的光流保證了語義分割的像素級別的時序一致性。

值得一提的是,通過光流施加的約束并沒有顯式的特征融合,而是隱式約束。在訓練網絡模型時需要分割和光流,但實際測試、應用的時候只需要分割。

這種方法可幫助利用數據集中的全部數據并學到更魯棒的分割特征以提高分割準確率,并且不會在測試階段增加額外的計算量。

但是,使用光流方法也會產生新的問題:遮擋。如下圖,行人過馬路時把后面的樹擋住。那么如何更準確預估遮擋部分背景呢?

本文使用無監督的方式學習遮擋區域,通過反向光流推測出可能無法對齊的像素位置O(即遮擋區域),模型根據此學習得到O_{est};兩幀的分割結果通過光流warp不一致的區域設為O_{seg},O_{seg}應包括遮擋區域和光流估計錯誤的區域,因此O_{error} = O_{seg}-O_{est}應為光流估計的重點區域。

在計算光流估計的損失函數時,作者不考慮遮擋區域(O_{est})的損失,而加大重點區域(O_{error})的權重。

▎多個數據集測試結果排名前列

這種方法的效果到底如何呢?

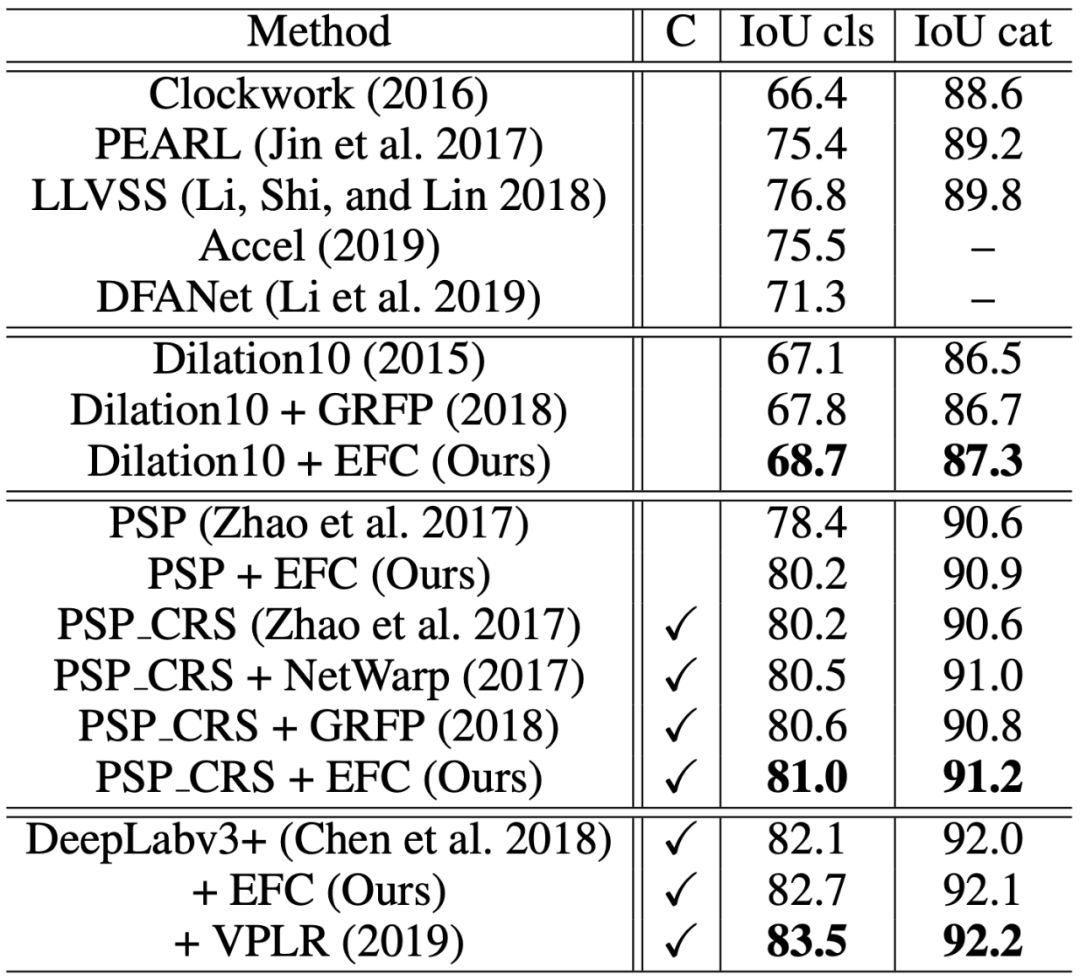

作者分別在Cityscapes、CamVid和KITTI數據集上進行了測試,均排名前列。在不使用額外數據集的情況下,均排名第一,具體如下表:

表1:Cityscapes數據集上的分割結果:本文算法排名第二,排名第一的方法VPLR生成了額外的數據

表2:CamVid數據集上的分割結果:本文算法排名第一

表3:KITTI數據集上的光流估計結果:本文算法排名第三,排名第一和第二均使用了額外數據集

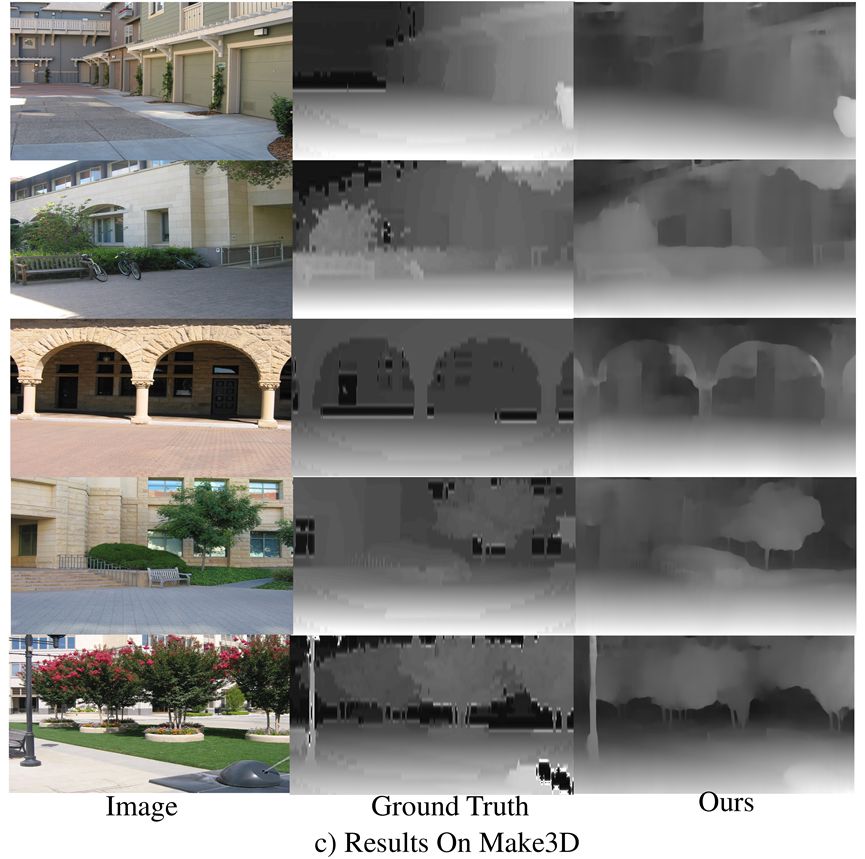

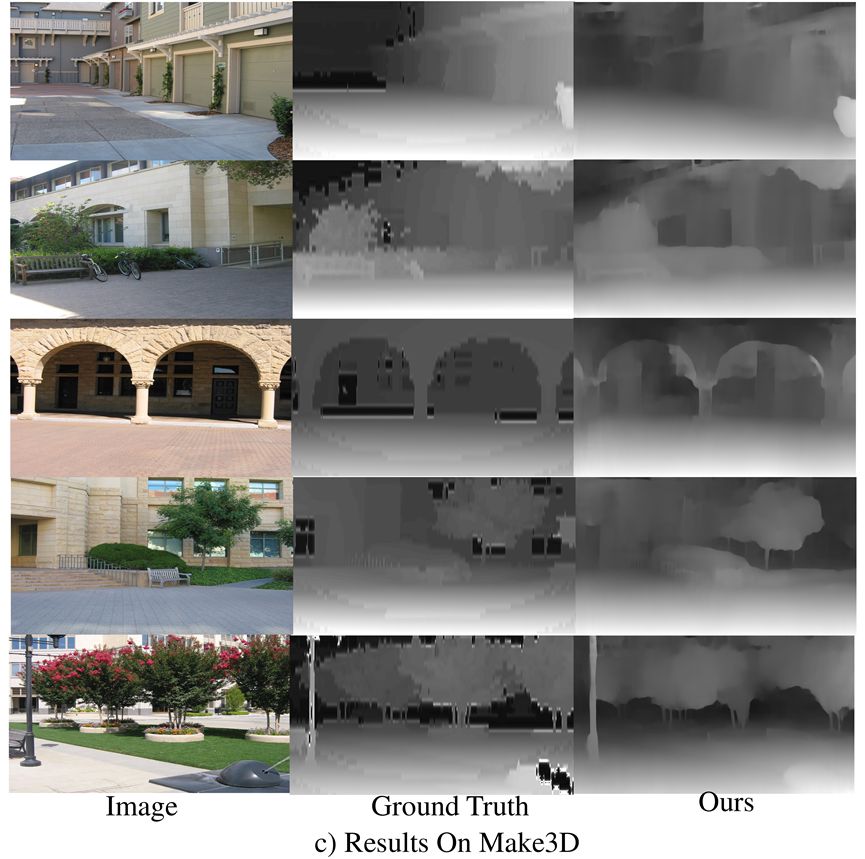

再來看下可視化效果對比。

圖4:CityScapes驗證集圖片可視化結果。從上至下分別為原圖,本文算法分割結果,PSPNet分割結果和GT(標準結果)

從圖4可以看出,本文算法對移動目標(汽車,自行車)和出現頻次較少目標(橫向卡車)分割效果較好。

以圖中第二列的卡車識別為例,本文算法能更完整的識別卡車形狀,且圖中顏色較少(一種顏色代表一種物體),基本能準確識別卡車。而PSPNet分割方法識別的卡車顏色較多,即識別成多種物體,對卡車的識別不夠準確。

而且,實驗結果的視頻中PSPNet分割方法對移動的卡車識別結果為多種顏色,即識別成了多種物體。相比之下,本文算法更穩定。

本文的光流估計效果也領先行業。圖五是KITTI數據集上光流估計結果,從上至下分別為原圖,本文算法估計結果,GeoNet估計結果和GT。可以看出本文算法對移動目標的邊緣估計更為準確。

圖5:KITTI 數據集光流估計可視化結果

GeoNet估計的實驗結果,在左一列識別汽車位置偏離標準結果,在左二、三列識別汽車較模糊,與標準結果相差較大。相比之下,本文算法更接近標準結果。

論文作者:Mingyu Ding, Zhe Wang, Bolei Zhou, Jianping Shi, Zhiwu Lu, Ping Luo

論文地址:https://arxiv.org/pdf/1911.12739.pdf

返回

返回

人工智能基礎設施

人工智能基礎設施 企業服務智能化

企業服務智能化 城市管理智能化

城市管理智能化 汽車出行智能化

汽車出行智能化 個人生活智能化

個人生活智能化