CVPR 2018 | 商湯科技Spotlight論文詳解:基于孿生區域推薦網絡的高性能單目標跟蹤

距離CVPR 2018大會越來越近,本文是商湯科技在目標檢測與跟蹤領域,發表的一篇CVPR 2018亮點報告論文:基于孿生區域推薦網絡的高性能單目標跟蹤。該論文由商湯科技見習研究員李搏在研究院副院長閆俊杰和研究員武偉共同指導下完成。

論文:基于孿生區域推薦網絡的高性能單目標跟蹤

作者:Bo Li, Junjie Yan, Wei Wu, Zheng Zhu, Xiaolin Hu

論文鏈接:http://openaccess.thecvf.com/content_cvpr_2018/CameraReady/2951.pdf

簡介

本論文提出一種端對端的單目標跟蹤算法,實現高性能的單目標視覺跟蹤。現有的單目標跟蹤算法通常很難兼顧跟蹤性能和速度,只能在某一項指標占優。本文利用孿生(Siamese)網絡和區域候選網絡(Region Proposal Network),構建了一種高速且高精度的單目標跟蹤算法。算法在整體框架上,可被分為孿生(Siamese)特征提取網絡和區域推薦網絡(Region ProposalNetwork)兩個子網絡,在一個統一的框架里實現端到端的訓練和測試。

訓練過程中,算法能夠同時利用密集標注(VID)和稀疏標注(YoutubeBB)的數據集進行訓練,相比于現有方法,稀疏標注的數據集大大增加了訓練數據來源,從而可以對深度神經網絡進行更充分的訓練;區域推薦網絡中的坐標回歸則可以讓跟蹤框更為準確,節省了傳統孿生跟蹤網絡中多尺度測試所需的額外計算。

實驗方面,本文跟蹤算法能在保持160fps的高幀率情況下,在VOT2015和VOT2016等數據集上取得匹敵目前先進水平的結果。

設計思想

單目標視覺跟蹤領域的主流方法是以SiameseFC為代表的孿生網絡結構,SiameseFC網絡結構簡單,通過同一網絡提取一對圖像的特征,通過相關(correlation)操作,可以實現目標模板與搜索圖像區域中的17x17個小圖像的快速比對,輸出的17x17的響應圖,描述每個圖像搜索位置與目標模板的相似度。但SiameseFC有以下缺陷:

首先,網絡無法預測目標尺度上的變化,因此只能通過多尺度測試來判斷目標尺度的變化,降低跟蹤速度。

其次,輸出的模板響應圖分辨率較低,為了得到更高精度的位置,SiameseFC需要采用插值的方法,將響應圖分辨率放大16倍,達到與輸入圖像尺寸相近的大小。

本文提出SiameseRPN算法,通過引入物體檢測領域中的區域推薦網絡(RPN),回歸目標框位置,避免SiameseFC中響應圖插值和多尺度測試等操作,既提升了速度又得到更為精準的目標框。在訓練過程中,算法能夠使用大規模帶稀疏標注的視頻數據集Youtube-BB進行訓練,相較于SiameseFC僅使用的VID數據集,Youtube-BB數據集能夠提供50倍數量的視頻,保證了深度神經網絡能夠被充分的訓練。

訓練框架

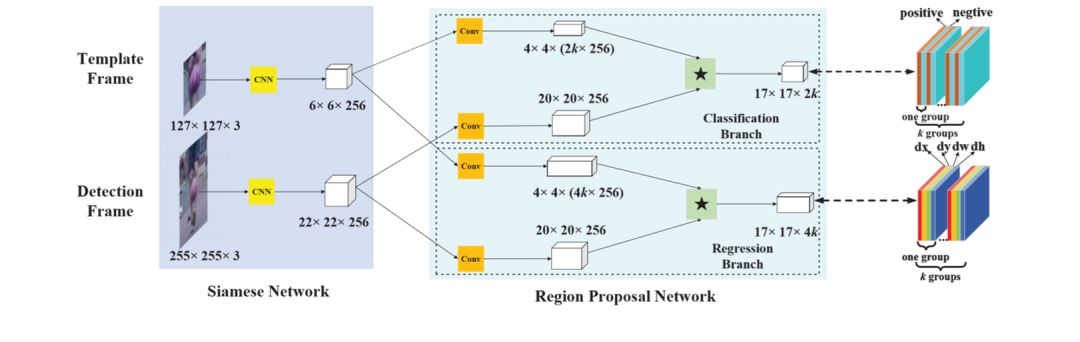

圖1展示了SiameseRPN的整體網絡框架:

左邊是用于提取特征的孿生(Siamese)網絡;中間是區域推薦網絡,包含了分類分支和回歸分支,通過輸入成對圖像并進行相關(correlation,圖1中“*”)等操作得到最后的輸出。

圖1:算法整體網絡結構

圖1右邊部分展示了各輸出通道的細節:在分類分支,輸出的前景置信圖包含2k個通道,分別表示響應圖每個位置k個錨點框的前景/背景的置信度;在回歸分支,輸出圖包含4k個通道,分別表示每個位置k個錨點框的坐標偏移量。

孿生網絡

孿生網絡用于提取輸入圖像的特征,分為模板分支和檢測分支,均采用全卷積網絡結構生成輸入圖像的視覺特征圖。模板分支的輸入為模板幀的目標圖像 (z),而檢測分支的輸入為當前幀的圖像 (x),φ(z)和φ(x)則分別代表兩支網絡輸出的目標特征圖和當前幀特征圖。兩支網絡只有輸入不同,而權重參數完全相同,因而可以隱式的編碼相同的圖像視覺變化,適用于跟蹤任務。

區域推薦網絡

區域推薦網絡負責基于目標特征圖φ(z)和當前幀特征圖φ(x),及相關操作的結果(即1*17*17的響應圖),預測目標的精準位置。若每個輸出位置有k個錨點框(anchor box),那么網絡需要為分類分支輸出通道數為2k的置信圖,為回歸分支輸出通道數為4k的偏移圖。

因此在進行相關操作之前,網絡使用卷積操作提升兩個分支中特征圖的通道數,將其分別提高為原來的2k倍和4k倍,圖1中間部分的卷積用于提升特征圖維度。提升維度后的特征圖進行相關操作,得到分類和回歸分支的輸出。兩支網絡利用與目標檢測中Faster R-CNN算法類似的損失函數,進行網絡訓練。

訓練數據的構成

在訓練階段,Siamese網絡所需要的訓練樣本對從VID和Youtube-BB數據集中以隨機間隔篩選生成。目標模板和檢測幀圖像來自于同一個視頻中同一個物體的不同兩幀。兩幀之間通常有一定間隔,但過遠的間隔可能使得目標外觀的變化過大,使得網絡難以訓練。因此,在實際訓練過程中均采用小于100幀間隔的圖像對作為訓練樣本對。

雖然在視頻數量上Youtube-BB數據集遠大于VID數據集,但VID數據集包含Youtube-BB數據集所不具備的高幀率標注。本文觀察到,一個好的跟蹤網絡既需要能夠捕捉目標細粒度的變換(由VID數據集得到),又需要從更大數量級的視頻中學習更加通用的目標特征和變化(通過Youtube-BB數據集學習),因此兩個數據集的合并使用十分重要,且需要調整好訓練數據的比例。本文實驗中,VID和Youtube-BB的數據占比設為1:5。

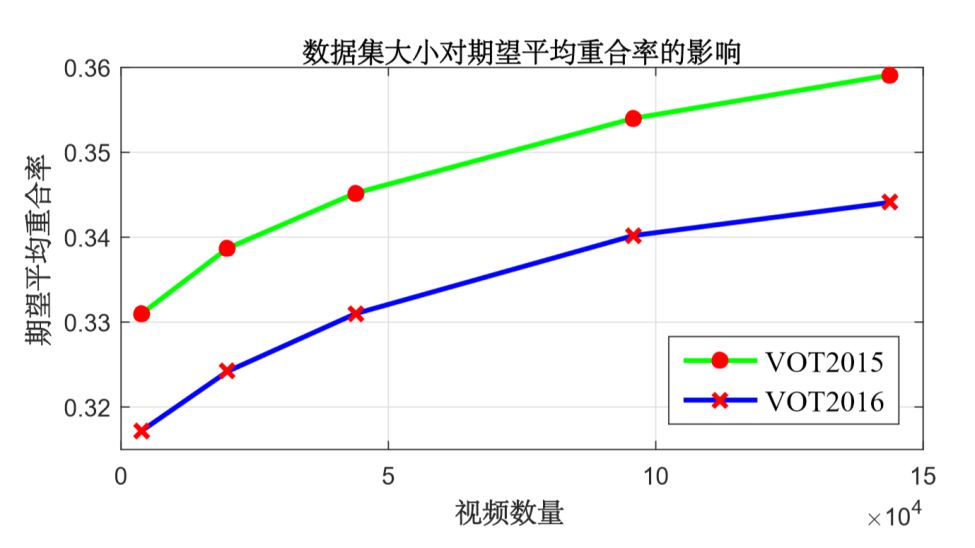

圖2:不同量級訓練數據對應的

最終模型跟蹤性能

本文在不同數量視頻的訓練集下訓練SiameseRPN。如圖2所示,最左邊的跟蹤精度代表只用VID作為訓練集的情況,可以看出,隨著數據不斷的增加,在VOT2015和VOT2016測試集上跟蹤性能均不斷提升,Youtube-BB數據集的引入讓算法在VOT2016上的EAO從0.317提升至0.344,超過VOT2016的冠軍方法CCOT,并且從曲線趨勢上來看,跟蹤性能還沒有趨于飽和。這表明如果能夠有更大量級的數據集,模型的跟蹤精度能夠進一步提升。這也就體現了數據驅動算法的優勢。當目標跟蹤與其它計算機視覺領域一樣,出現了大量的跟蹤數據集時,深度學習算法可以通過增加數據獲得更好的性能,而傳統的濾波方法不能采用離線訓練,也無法有效的利用大數量級的跟蹤數據。

算法測試流程

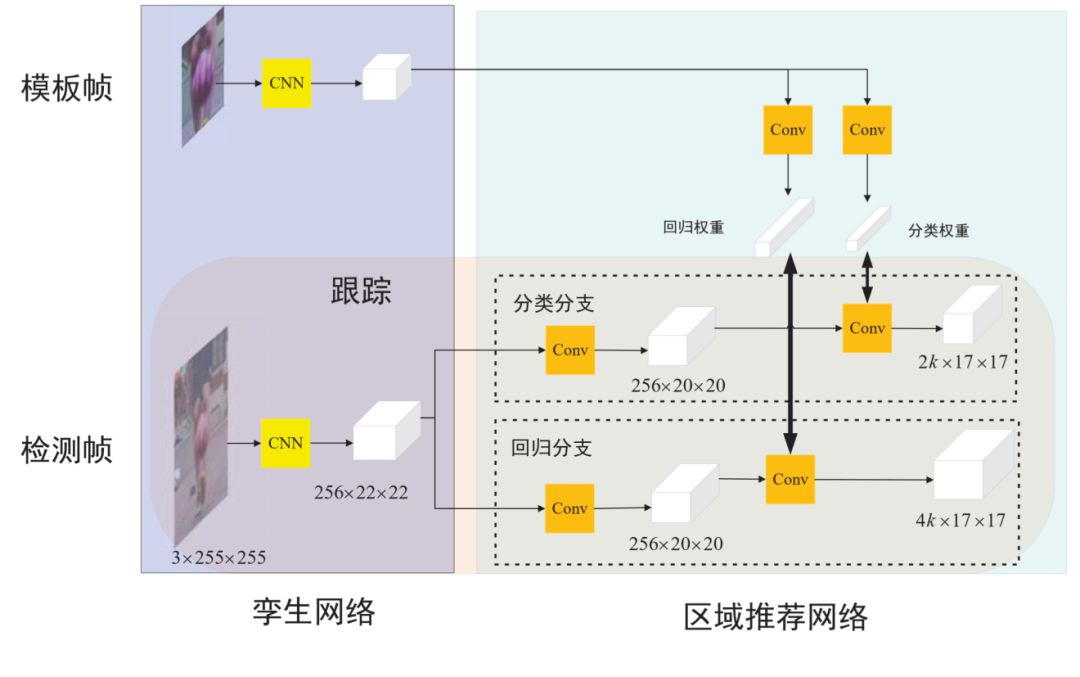

與訓練過程不同,孿生網絡的兩支在測試過程中被分離開(如圖3所示),模板支只在目標初始幀前向傳播一次,將用于前景置信度和偏移預測的特征圖計算好以后保留至內存。而檢測分支則在視頻每一幀進行前向傳播,得到對應的用于前景置信度和偏移預測的特征圖,將其與模板對應的特征圖進行相關操作以后,得到最終的前景/背景分類結果和目標框偏移回歸結果。根據這兩個結果圖,可以得到每個預測框的目標置信度,經過高斯窗口抑制和形狀抑制,得到加權后的目標置信度。算法選出置信度最高的對應框,作為網絡預測的最終目標位置。

圖3:SiameseRPN算法測試流程

實驗結果

VOT2015結果

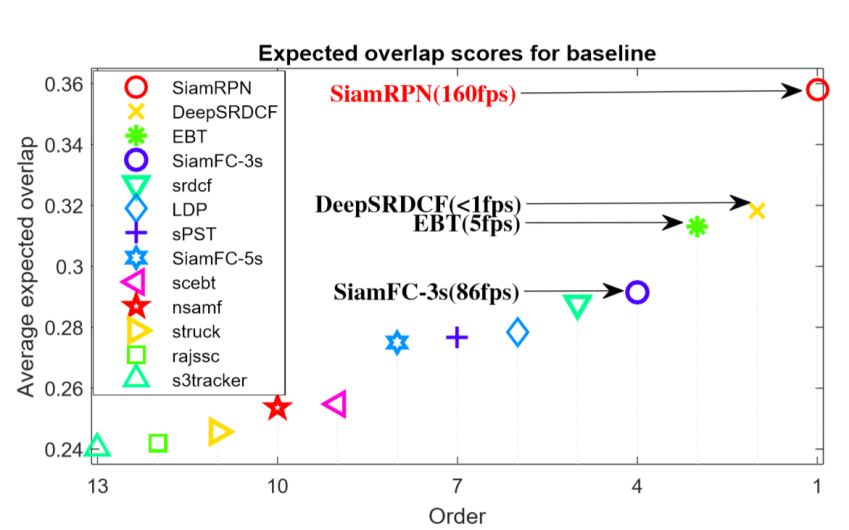

VOT2015數據集中包含60段視頻。在測試過程中,當VOT工具包發現跟蹤結果與實際目標位置重合度為0時會重啟跟蹤器,因此跟蹤算法的性能由精度和魯棒性兩方面來評估。精度度量跟蹤過程中平均的目標框重合度,而魯棒性則衡量跟蹤算法在測試視頻上的丟失次數,VOT提出了EAO來綜合這兩項指標,作為排名依據。不同算法的跟蹤精度如圖4所示,本文提出的SiameseRPN算法可以在速度極高的情況下依然保證跟蹤性能的領先,在速度和精度上均領先于第二名。

圖4:不同跟蹤算法

在VOT2015測試集的性能

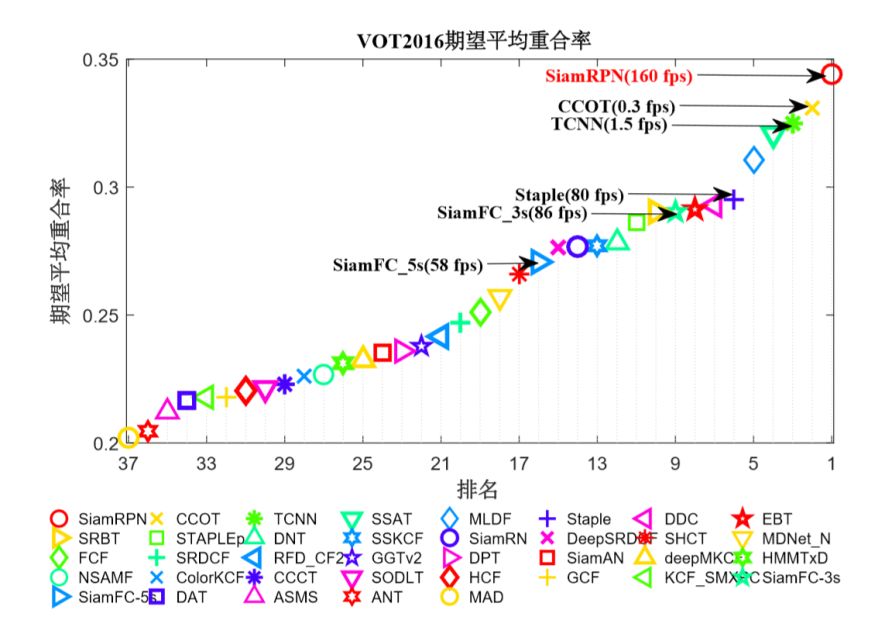

VOT2016 結果

VOT2016測試數據集與VOT2015數據集相同,但是使用了更為更緊致的目標框,因此跟蹤算法更容易丟失目標,造成跟蹤重啟。不同算法在VOT2016數據集的性能如圖5所示,本文提出的算法與榜單上的前25名的算法進行了對比,SiameseRPN算法仍然能夠在該數據集奪得第一名,其速度(160fps)是VOT2016冠軍算法的500倍。

圖5:不同跟蹤算法

在VOT2016測試集的性能

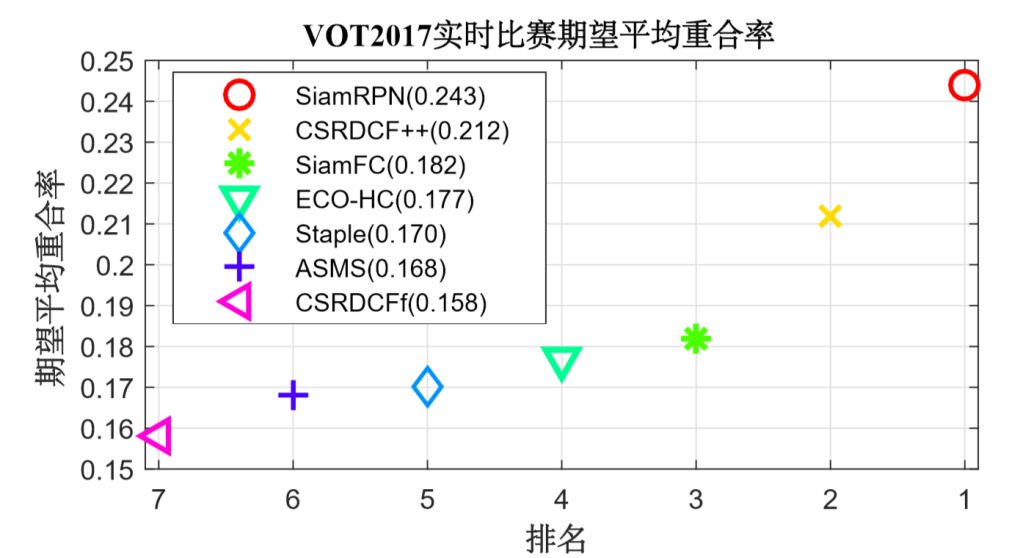

VOT2017 數據集實時跟蹤結果

在VOT2017數據集中,VOT中10段最簡單的視頻被替換為了十段較難的視頻。同時實驗新增了實時比賽,要求跟蹤算法必須能夠在每秒處理20幀圖像。若算法不能在50ms內完成處理當前幀,則使用上一幀結果代替。該規定導致速度較慢的跟蹤算法會丟失多幀跟蹤結果,無法有效跟蹤目標。

圖6:不同跟蹤算法

在VOT2017測試集的實時跟蹤性能

如圖6所示,本文算法在實時跟蹤榜單同樣排名第一,0.24平均重合率的成績較第二名CSRDCF++平均重合率提高3個點,同時相較于SiameseFC算法(實時榜單的冠軍),平均重合率提高6個點。實驗結果非常有力地證明了本文算法能夠在高幀率的同時保證精準的跟蹤精度。

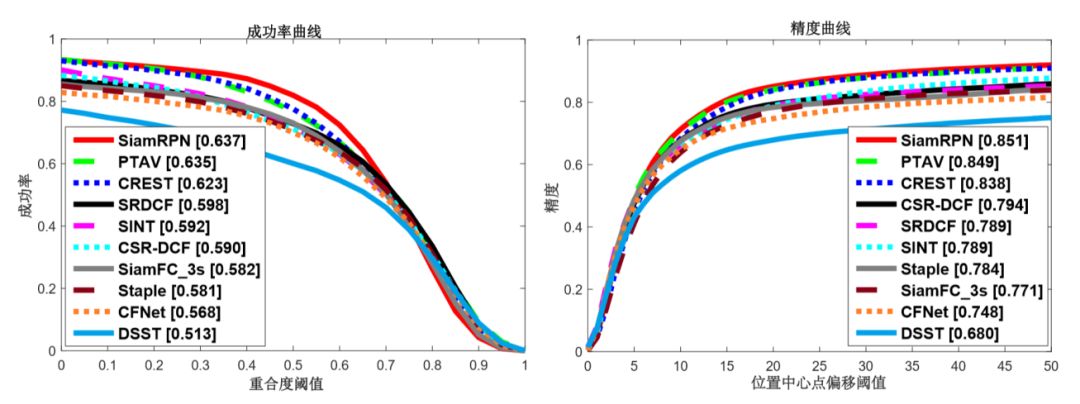

OTB2015數據集結果

OTB數據集由跟蹤社區經常使用的視頻中挑選出的100段視頻組成,主要評測指標包含成功和精度的曲線。精度曲線度量預測框與標注中心點小于某像素的幀的占比;成功率曲線則度量預測框與標注框的重合度超過某一閾值的幀的占比。本文將孿生區域推薦網絡和幾個比較有代表性的算法進行了對比,包含PTAV、CREST、SINT、CSR-DCF、SiameseFC、Stape、CFNet、DSST。結果如圖7所示,本文提出的算法可以在OTB2015的兩個指標上均取得第一。由于引入了區域推薦網絡,新算法可以比基礎算法SiameseFC提高5個點。

圖7:不同跟蹤算法在OTB2015數據集上的

成功率曲線和精度曲線

結論

本文利用孿生網絡和區域推薦網絡,構建了一種高速且高性能的單目標跟蹤算法。算法中設計的坐標回歸可以讓跟蹤框更加準確,并且省去多尺度測試耗費的時間。在實驗中,本文跟蹤算法能在保持高速的情況下(160fps),在VOT2015和VOT2016數據集上均達到領先的單目標跟蹤水平。

返回

返回

人工智能基礎設施

人工智能基礎設施 企業服務智能化

企業服務智能化 城市管理智能化

城市管理智能化 汽車出行智能化

汽車出行智能化 個人生活智能化

個人生活智能化