CVPR 2017 | 商湯科技及香港中大-商湯科技聯合實驗室精選論文解讀(二)

在今年的CVPR學術會議上商湯科技與香港中大-商湯科技聯合實驗室共同發表的論文多達23篇,香港中大林達華教授親自精選五篇論文與大家分享。這五篇論文的研究成果在各個專業數據集、競賽如ImageNet、Visual Genome、DAVIS Challenge、MPII中,取得第一名的成績。

國際計算機視覺與模式識別大會 (CVPR) 是人工智能尤其是計算機視覺領域的頂級學術會議。今年CVPR的文章錄取率大約29%。在CVPR上發表的論文被公認為代表了該領域科技發展的最高水平。從今年7月21日開始這個一年一度的盛會就在美麗的夏威夷火奴魯魯召開。本屆CVPR大會商湯科技與香港中大-商湯科技聯合實驗室共發表了23篇論文,超過了以人工智能技術著稱的科技巨頭Google (21篇)和Facebook AI Research (7篇)。這23篇論文涵蓋了計算機視覺的多個領域,不僅提出了很多新型的應用,也在核心技術的研發上取得了多項國際領先的成果。在本文中我們將以其中5篇論文為代表一窺商湯這個AI獨角獸背后的核心技術創新之路。

PolyNet:深度網絡設計的里程碑 多項比賽奪冠

深度學習在這幾年取得了令世人矚目的成就。這些成就背后的最主要的技術因素就是深度網絡設計技術的不斷突破。深度網絡的進步首先反映在ImageNet1000類圖像分類的準確率上它是業界公認的衡量深度網絡性能的一個重要指標。從AlexNet、GoogLeNet到ResNet網絡越來越深準確率也在不斷提升。在過去五年ImageNet分類準確率從84%提高到了97%。可是隨著網絡深度持續增加性能的進一步提升開始遇到了瓶頸。比如ResNet從一百多層增加到一千層性能也沒有顯著的提高。

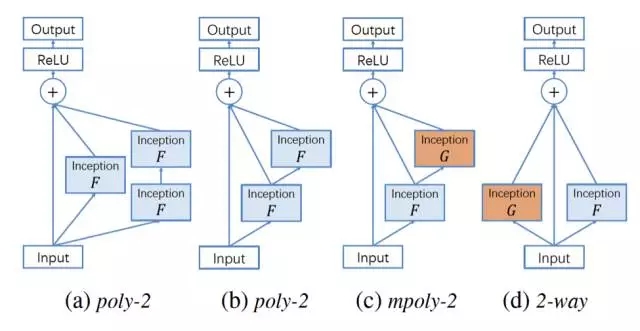

面對這樣的困難此論文提出了一種新的破局思路增強網絡的結構多樣性(Structural diversity)。這個思路源自于我們在實踐中的一個重要觀察多個不同結構的超深網絡的簡單結合往往能帶來性能的進一步顯著提升。沿著這個思路我們設計了PolyNet。它由多個不同形態的稱為PolyInception的基本元組疊合在一起構成。因為每種元組都可以通過一個數學多項式表達出它的結構所以稱為Polynomial Inception簡稱PolyInception。如上圖所示每個PolyInception是內部合成了多個不同深度的并行通路。這個設計把結構多樣性的思想往前推進了重要一步把它融入到每個單元的設計之中。

此論文的作者透過系統性的對照實驗對PolyNet的設計進行測試發現它相比于主流的設計包括ResNet以及由Google提出的InceptionResNet v2有更高的效率即在相同的計算量下能獲得明顯更高的性能。文中描述的Very Deep PolyNet在ImageNet大規模圖像分類測試集上獲得了single-crop錯誤率4.25%和multi-crop錯誤率3.45%的性能顯著超過了Google提出的InceptionResNet v2和Facebook在同一時間發表的ResNeXt成為已發表的性能最高的網絡也是深度網絡設計領域的新標桿。

在ImageNet2016的比賽中商湯科技與香港中大-商湯科技聯合實驗室在多項比賽中選用了這種網絡結構并取得了三個單項第一的優異成績。這一成績反映了一個高效的深度網絡架構對于提升應用性能的重要作用。PolyNet的模型結構已在Github公開

https://github.com/CUHK-MMLAB/polynet

論文標題:PolyNet:A Pursuit of Structural Diversity in Very Deep Networks

論文作者:Xingcheng Zhang, Zhizhong Li, ChenChange Loy, Dahua Lin

Relational Net:Visual Genome上把關系識別準確率從48%大幅度提高到82%

物體檢測與識別一直是計算機視覺研究的重要方向。近年來隨著Faster RCNN等基于深度學習的檢測框架的發展物體檢測的性能有了長足的進步但這對于圖像理解仍然是不足夠的。出現了同類型物體的圖片它們背后傳遞的含義可能是截然不同的。要理解這樣的圖片我們不僅需要判斷圖中出現的物體的類型而且需要理解物體之間的關系。

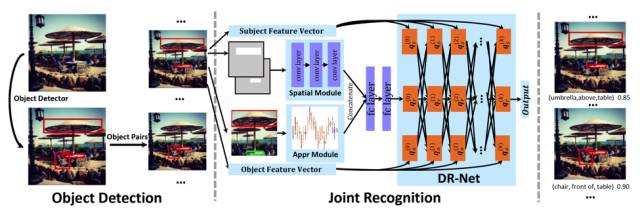

最近一段時間關系識別逐步進入計算機視覺研究的視野。在這個問題上的一個有代表性的工作是斯坦福大學李飛飛團隊在2016年10月發表在ECCV上的論文。該工作把語言先驗用于關系識別相比于之前的方法取得了不錯的進展關系識別的準確率提高到了48%。然而這樣的準確率顯然離滿足實用需求仍有較大的距離同時它也反映的問題的難度。這個問題的主要挑戰在于關系與物體有著顯著不同的性質。某種類型的物體它的外觀表現往往比較一致而同一種關系的外觀表現往往千差萬別。

此論文提出了一種新的建模方法把統計學習和深度網絡有機地結合起來。此方法把一個基于條件隨機場(Conditional Random Field)的迭代推斷方法解開從而把它表達為一個前向計算網絡。這個前向網絡和CRF一樣具有統計推斷的能力但是它可以被嵌入到一個更大的深度學習系統中和其它模塊一起進行端對端的學習。基于這種方法此論文提出了一個稱為Deep Relational Net的關系理解框架把特征學習以及跨領域關系學習結合成一個統一網絡。這個框架在關系理解領域的主要數據集Visual Genome上把關系識別準確率從48%大幅度提高到82%從而為這個問題設立了新的性能標桿。這篇論文在CVPR 2017被接收為Oral presentation。該論文相關代碼與模型結構已經在Github公開

https://github.com/doubledaibo/drnet

論文標題:Detecting Visual Relationships with Deep Relational Networks

論文作者:Bo Dai, Yuqi Zhang, Dahua Lin

Deep Layer Cascade:斬獲第一屆DAVIS Challenge 視頻語義分割比賽冠軍

圖像語義分割是圖像理解的基石性技術在自動駕駛系統等牽涉街景或場景識別應用中扮演舉足輕重的角色。基于深度學習的語義分割技術雖然可以取得遠超傳統方法的性能但是往往依賴于極深的網絡或者復雜的后處理技術提高模型的預測精度。因而處理過程通常需要耗費大量的計算資源而且速度不高。

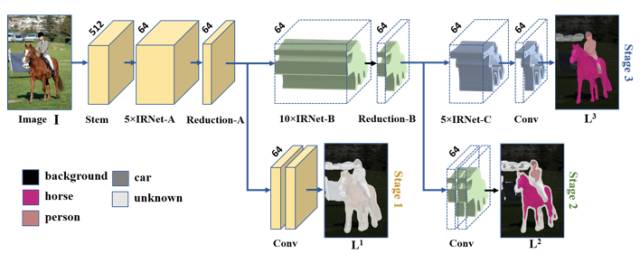

此論文提出了一個很具啟發性的創新點對難度不同的區域區別對待 — 讓簡單的歸于簡單把寶貴的計算資源投放在困難的部分。具體而言大塊平滑的區域分割是較為容易的而物體邊界或者有復雜紋理的區域的分割則較為困難。基于這一觀察此文提出了一個新型的語義分割模型Deep Layer Cascade (LC)。它將圖像中的像素分為簡單、中等、困難三個部分分別由網絡中的淺層、中層、高層來針對性完成分割。

此文還提出了Region Convolution來只處理每個階段感興趣的區域而忽視其他區域。對于簡單區域的低層處理結果通過skip connection直接傳送到輸出端并與復雜區域處理的結果相融合因此三個層次的處理無縫銜接構成了一個可以端對端訓練的統一網絡。Deep Layer Cascade不僅提高計算速度而且因為每個階段只專注處理某類難度的像素精度也會相對地提高。LC可以靈活地與不同的深度網絡架構結合運用。Inception-ResNet-v2應用LC后速度提高了42.8% 精度提高了1.7%。經測試LC在多個測試集上大幅度提高速度并達到甚至超越state-of-the-art的精度水平LC在VOC12測試集上mIoU可達到80.3在COCO上預訓練可達到82.7在Cityscapes測試集上可達到71.1。

除了上述論文值得一提的是商湯科技與香港中大-商湯科技聯合實驗室在這次的CVPR斬獲了由VideoNet(http://videonet.team/)主辦的第一屆DAVIS Challenge 視頻語義分割比賽冠軍 http://davischallenge.org/ 。參賽者需要提出算法準確地把視頻里指定的物體進行語義實例分割。因為物體快速移動造成的模糊狀態和多物體之間的遮擋問題比賽的挑戰難度特別高。商湯科技與香港中大-商湯科技聯合實驗室合作提出的Video Object Segmentation with Re-identificationVS-ReID算法讓他們在全球共 22支隊伍里脫穎而出獲得冠軍。

論文標題:Not All Pixels Are Equal: Difficulty-Aware Semantic Segmentation via Deep Layer Cascade

論文作者:Xiaoxiao Li, Ziwei Liu, Ping Luo, ChenChange Loy, Xiaoou Tang

此外,商湯科技與香港中大-商湯聯合實驗室參加DAVIS Challenge比賽的技術方案也在DAVIS Challenge workshop整理發表:

論文標題:Video Object Segmentation with Re-identification

論文作者:XiaoxiaoLi, Yuankai Qi, Zhe Wang, Kai Chen, Ziwei Liu, Jianping Shi, Ping Luo, ChenChange Loy, Xiaoou Tang

Tubelet Proposal Network:ImageNet冠軍檢測技術到視頻的躍遷

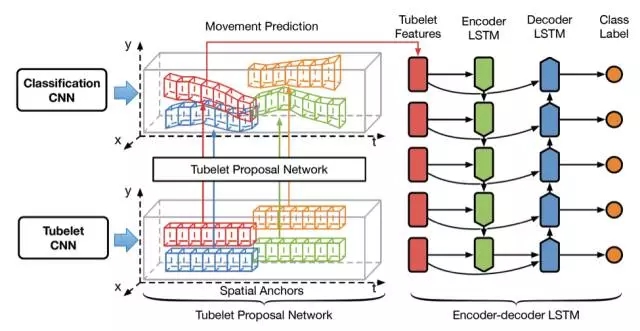

視頻中的物體檢測問題由于其在高級AI系統如自動駕駛、家居機器人中的潛在用途近年來獲得了廣泛的關注。相較于傳統靜止圖片的物體檢測問題現有的視頻物體檢測方法通常基于時空「管道」(tubelets)即跨時間連接的檢測框來有效的應用視頻中的時域信息。但是現有方法中時空管道生成的質量和效率往往差強人意基于運動信息的生成方法只能生成較短的時空管道而基于圖像信息的生成方法需要花費大量的計算量也不能保證對于物體較高的召回率。

該論文將傳統針對靜止圖像的FasterRCNN框架進行了擴展將視頻物體檢測框架擴展為「候選時空管道生成」和「候選時空管道識別」兩個模塊提出了一種高效率的候選時空管道生成方法能夠在保證時空管道較長長度的同時盡可能的保留不同時空管道的多樣性從而提高物體的召回率。基于這些高質量的候選時空管道應用編碼-解碼LSTM網絡進行時空管道的識別能夠有效的提升檢測整體的正確率。作者還對Tubelet Proposal Network初始化和不同設置進行了詳盡分析基于TPN的物體檢測平均正確率相較于靜止圖像檢測框架有>5%的提升。

該論文作者在2015和2016連續兩年取得ImageNet視頻物體檢測項目第一。該論文是他們在2016年ImageNet競賽第一工作上進行擴展后提出的全新視頻物體檢測框架相較于現有算法對視頻中物體檢測的效率和準確率進一步提升。

論文標題:Object Detection in Videos with Tubelet Proposal Networks

論文作者:Kai Kang, Hongsheng Li, Tong Xiao, Wanli Ouyang, Junjie Yan, XihuiLiu, Xiaogang Wang

Multi-Context Attention:單人體姿態識別數據集MPII準確率第一

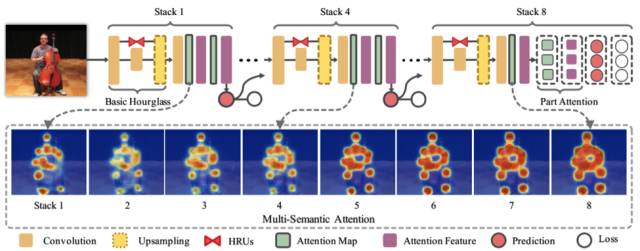

人體姿態估計旨在檢測出圖像或視頻中人體各關鍵點的位置具有很大的應用價值如體感游戲人機交互機器人虛擬現實設備動作捕捉機器視覺等。然而因為人體姿態非常豐富圖像視頻背景冗雜人體遮擋等情況常有發生所以人體姿態估計問題極具挑戰性。要解決上述問題需要充分理解圖像的上下文信息傳統方法通常使用多個不同尺度的圖像塊來對多尺度信息建模這樣獲得的多尺度信息往往缺少靈活性和多樣性。 人腦視覺注意力機制是人腦高效理解自然場景的有效機制。通過將注意力集中到核心區域人腦能有效排除與任務無關的其他干擾區域并著重分析與任務相關的關鍵區域。

此論文提出的多情境注意力機制網絡multi-context attention network首次將注意力機制模型與人體姿態估計任務有效結合通過設計三種不同的注意力機制模型——多尺度注意力機制multi-resolution attention多語義注意力機制multi-semantics attention人體全局-局部注意力機制hierarchical global-part attention——來學習圖像上下文信息能夠有效去除人體姿態估計任務里的冗余背景提高對易混淆人體部位分辨能力從而人體關鍵部位的檢測精度。在最廣泛使用的單人體姿態識別數據集MPII上該方法準確度在已發表的工作中最高。該方法目前已經開源代碼可在如下網站獲得

https://github.com/bearpaw/pose-attention

論文標題:Multi-Context Attention for Human Pose Estimation

附錄

商湯科技及香港中大-商湯科技聯合實驗室共有23篇論文被接收,附上CVPR2017上Session時間

Multi-Context Attention for Human Pose Estimation - Saturday, July 22, 2017, 09:00–10:30

Multi-Scale Continuous CRFs as Sequential Deep Networksfor Monocular Depth Estimation - Saturday, July 22, 2017, 09:00–10:30

Accurate Single Stage Detector Using Recurrent Rolling Convolution - Saturday, July 22, 2017, 10:30–12:30

Mimicking Very Efficient Network for Object Detection - Saturday, July 22, 2017, 10:30–12:30

Object Detection in Videos with Tubelet Proposal Networks - Saturday, July 22, 2017, 10:30–12:30

Spindle Net: Person Re-identification with Human Body Region Guided Feature Decomposition and Fusion - Saturday, July 22, 2017, 10:30–12:30

Discover and Learn New Objects from Documentaries - Saturday, July 22, 2017, 13:30–15:00

Learning object interactions and descriptions for Semantic Image Segmentation - Saturday, July 22, 2017, 13:30–15:00

Learning Spatial Regularization with Image-level Supervisions for Multi-label Image Classification Saturday, July 22, 2017, 15:00–17:00

Scale-Aware Face Detection - Saturday, July 22, 2017, 15:00–17:00

Interpretable Structure-Evolving LSTM - Sunday, July 23, 2017, 08:30–10:00

Detecting Visual Relationships with Deep Relational Networks - Sunday, July 23, 2017, 13:00–14:30

Joint Detection and Identification Feature Learning for Person Search - Sunday, July 23, 2017, 13:00–14:30

Learning Cross-Modal Deep Representations for Robust Pedestrian Detection - Sunday, July 23, 2017, 14:30–16:30

PolyNet: A Pursuit of Structural Diversity in Very Deep Networks - Sunday, July 23, 2017, 14:30–16:30

Pyramid Scene Parsing Network - Sunday, July 23, 2017, 14:30–16:30

Person Search with Natural Language Description - Monday, July 24, 2017, 10:00–12:00

Quality Aware Network for Set to Set Recognition - Monday, July 24, 10:00–12:00

Untrimmed Nets for Weakly Supervised Action Recognitionand Detection - Tuesday, July 25, 2017, 10:00–12:00

Not All Pixels Are Equal: Difficulty-Aware Semantic Segmentation via Deep Layer Cascade - Tuesday, July 25, 2017, 13:00–14:30

Residual Attention Network for Image Classification- Tuesday, July 25, 13:00–14:30

ViP-CNN: A Visual Phrase Reasoning Convolutional Neural Network for Visual Relationship Detection - Tuesday, July 25, 2017, 14:30–16:30

Look into Person: Self-supervised Structure-sensitive Learning and A New Benchmark for Human Parsing - Tuesday, July 25, 2017, 14:30–16:30

返回

返回

人工智能基礎設施

人工智能基礎設施 企業服務智能化

企業服務智能化 城市管理智能化

城市管理智能化 汽車出行智能化

汽車出行智能化 個人生活智能化

個人生活智能化