CVPR 2021|有的放矢,用圖像分割與像素投票找到預定義的地標點

視覺定位這一任務的目標是根據圖像計算出相機的六自由度位姿,即三自由度的位置和三自由度的旋轉。目前主流的視覺定位方法有兩種,即基于 SfM 的視覺定位方法和基于場景坐標回歸的方法。

雖然基于場景坐標回歸的方法在小型靜態場景中的視覺定位方面已經表現出良好的性能,但它仍然會回歸出許多較差質量的場景坐標,這會給準確的相機位姿估計帶來影響。為了解決這個問題,我們提出了一種新穎的視覺定位框架 VS-Net,并在多個公共數據集上進行了測試,性能優于之前的場景坐標回歸方法和一些代表性的基于 SfM 的視覺定位方法。

VS-Net: Voting and Segmentation for Visual Localization

Zhaoyang Huang1,2* Han Zhou1* Yijin Li1 Bangbang Yang1 Yan Xu2 Xiaowei Zhou1 Hujun Bao1 Guofeng Zhang1? Hongsheng Li2,3

1State Key Lab of CAD&CG, Zhejiang University? 2CUHK-SenseTime Joint Laboratory, The Chinese University of Hong Kong 3School of CTS, Xidian University

Part 1 論文簡介

雖然基于場景坐標回歸的方法在小型靜態場景中的視覺定位方面已經表現出良好的性能,但它仍然會回歸出許多較差質量的場景坐標,這會給準確的相機位姿估計帶來影響。為了解決這個問題,我們提出了一種新穎的視覺定位框架,該框架根據場景制定一系列可學習的特定場景地標,并通過這些地標在查詢圖像和 3D 地圖之間建立 2D 到 3D 的對應關系。在地標生成階段,目標場景的 3D 表面被均勻分割成小塊,并將每個小塊的中心視為場景特定的地標。為了魯棒而準確地恢復特定場景的地標,我們提出了一種同時預測分割與像素投票的網絡 VS-Net,通過使用該網絡的分割分支將二維圖像中的像素分割為不同的地標塊,并使用像素投票分支估計每個塊在二維圖像內的地標位置。由于場景中的地標數量可能多達5千甚至更多,使用常用的交叉熵損失訓練具有如此多類別的分割網絡而言計算與顯存成本過高。為此,我們進一步提出了一種新的基于原型的三元組損失函數與在線負樣本挖掘策略,能夠有效地監督訓練具有大量標簽的語義分割網絡。總的來說,該工作的主要貢獻如下:

提出通過場景定制化地標來進行視覺定位,并提出通過投票與分割(voting-by-segmentation)來定位圖像中的場景地標,從而使得相機位姿估計能更精準魯棒。

由于場景地標數目過大(即圖像分割是標簽數目過大),我們提出了基于原型的三元組損失(prototype-based triplet loss)來解決標簽數量很大情況下的圖像分割問題。據我們所知,我們是第一個解決標簽數目很大情況下的圖像分割問題。在640x480分辨率,5千個標簽類別設置下的圖像分割任務中,我們提出的損失只需要傳統的交叉熵損失算力和顯存消耗的約0.1%(26.7MFLOPS v.s. 36.9GFLOPS;3.08MB v.s. 5.7GB)。

Part 2 相關工作

1. 基于SfM(Structure-from-Motion)的視覺定位方法

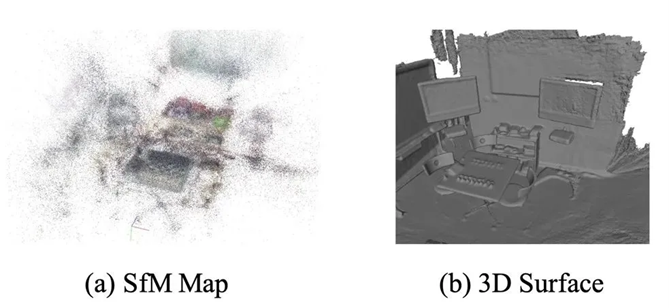

傳統的視覺定位框架通過 SfM 技術構建地圖,使用通用特征檢測器和描述符。給定一個查詢圖像,他們提取相同的 2D 特征并通過描述符將它們匹配到地圖中的 3D 特征。特征檢測器和特征描述符的關系在這個框架中非常重要,因為它同時影響了地圖質量和查詢圖像中 2D-3D 對應關系的匹配程度,這決定了定位的準確性。在基于 SfM 的視覺定位系統中,地圖中的 3D 特征點是根據多個相對應的2D點通過三角測量法重建。這些地圖中的 3D 特征點會非常凌亂(如圖1(a)所示),因為一個實際場景中的 3D 點往往會被多個不同的3D 特征點來表達,這是由于建圖時圖像的視角變化較大而使得 2D 特征未能匹配成功,這種質量不高的地圖會影響視覺定位效果。

圖1 SfM構建地圖與深度傳感器構建地圖比較

2. 基于場景坐標回歸(Scene Coordinate Regression)的視覺定位方法

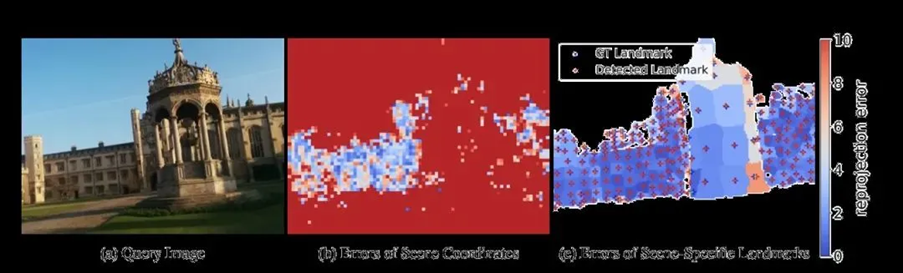

隨著深度學習的發展,訓練特定場景的神經網絡對地圖進行編碼并使用它對該場景的圖像進行定位定位成為另一種視覺定位方案。場景坐標回歸的視覺定位方法通過訓練一個神經網絡來預測圖像每個像素的場景坐標來構建 2D-3D 對應關系,然后使用經典的 RANSAC-PnP 方法來計算相機位姿。該方案能夠使用沒有特征數據庫但是更加準確的三維地圖(如圖1(b)是一個使用深度傳感器重建的稠密地圖),并在中小型場景中取得了優異效果。然而通過該方法構建的 2D-3D 對應關系仍然不夠準確且外點比例較高(如圖2(b)所示)。與之相比,我們提出的 VS-Net 會得到稀疏但是更準確魯棒的 2D-3D 對應(如圖2(c)所示),這同時增加了定位的精度和魯棒性。

圖 2 2D-3D 對應關系的重投影誤差比較

Part 3 方法描述

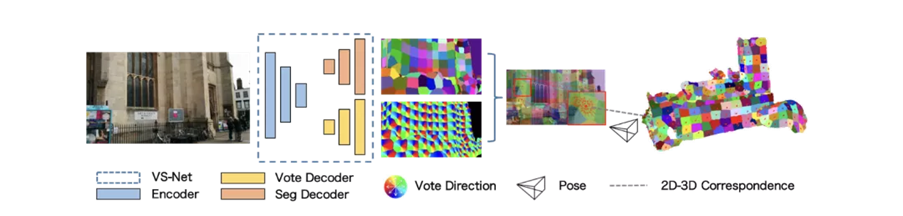

圖 3 VS-Ne視覺定位框架

場景坐標回歸方法比較適合小規模場景的視覺定位任務,一般為每個像素都建立輸入查詢圖像和場景的 3D 表面點的 2D-3D 對應關系(即場景坐標)。然而,很大一部分像素預測的對應三維場景坐標有很高的重投影誤差,這增加了定位失敗的可能性并降低后續 RANSAC-PnP 算法的定位精度。針對這些問題,我們提出使用 VS-Net 來識別一系列場景定制化的地標(圖 3)并建立它們與 3D 地圖的對應關系以實現精確定位。場景定制化的地標是從場景的 3D 表面直接定義的一組稀疏的三維點。我們對場景的 3D 表面進行均勻分割,得到一組面片(patches),并挑選每個面片的幾何中心作為場景定制化地標。給定不同視角的訓練圖像,我們可以投影這些生成的場景地標及其面片到圖像平面以識別它們在圖像中的對應像素。通過這種方式,我們可以為所有訓練圖像生成對應的地標信息。

在訓練階段,我們使用類似語義分割的像素級分割來預測屬于每個在推理階段,給定一個新的輸入圖像,我們從 VS-Net 獲得地標分割圖和地標位置投票圖。然后可以基于地標分割和位置投票圖建立 2D 到 3D 地標對應關系。與只能通過篩選場景坐標回歸方法中 2D 到 3D 對應異常值的 RANSAC-PnP 算法不同,我們提出的方法中的地標如果沒有足夠高的投票置信度,就會被直接放棄,這就避免了從定位不準確的地標中估計相機的位置(圖2)。此外,建立在場景坐標方法上的對應關系很容易受到不穩定預測的影響,而在我們的方法中,受輕微干擾的投票不會影響投票地標位置的準確性,因為它們會被面片內 RANSAC 計算交點算法過濾掉。像素對應的三維地標 ID。同時我們增加地標二維位置定位分支,通過輸出指向地標二維投影的方向向量,使每個像素負責估計其相應地標的二維位置。

場景唯一地標生成:

n} ∈R3 被選為場景唯一地標進行定位。由于 Supervoxel 產生大小相似的塊,生成的地標大多均勻地散布在三維表面上,這可以從不同的角度提供足夠的地標,因此有利于定位魯棒性。

給定訓練圖像和場景的相機姿勢,三維場景特定的地標 {q1, . . . ,qn},以及它們相關的三維塊可以被投影到二維圖像上。對于每幅圖像,我們可以生成一個地標分割圖 S∈ZH×W 和一個地標位置投票圖 d∈RH×W×2。對于基于塊的地標分割,坐標 pi= (ui, vi)的像素被分配到由三維塊的投影決定的地標標簽(ID)。如果一個像素對應的區域沒有被投影面覆蓋,如天空或遠處的物體,則給它分配一個背景標簽0,表示這個像素對視覺定位無效。

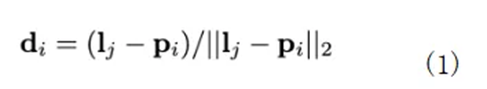

對于地標位置投票,我們首先通過根據相機內在矩陣 K 和相機姿態參數 C 投影三維地標來計算地標 qj 的投影二維位置 lj=P(qj, K, C)∈R2。屬于地標 j 的的每個像素負責預測指向 j 的二維投影的二維方向向量 di∈R2,即

其中 di 是一個歸一化的二維向量,表示地標 j 的方向。

在定義了真實地標分割圖和真實方向投票圖后,我們可以監督所提出的 VS-Net 預測這兩個圖。經過訓練,VS-Net 可以預測查詢圖像的分割圖和投票圖,我們可以據此建立精確的二維到三維的對應關系,以實現穩健的視覺定位。

基于原型的在線學習三元監督投票分割網絡:

傳統的語義分割任務一般采用交叉熵損失來監督所有預測像素的完整分類

傳統的語義分割任務一般采用交叉熵損失來監督所有預測像素的完整分類 One-Hot 向量。然而,我們的地標分割需要輸出具有大量類別(地標)的分割圖,以有效地識別每個場景唯一地標。常規語義分割中的逐像素交叉熵損失和常規的三元組損失在此時都不可用。

為了解決這個問題,我們提出了一種新的基于原型的三元組分割損失函數和在線負采樣策略來監督有大量類的語義分割。它維護和更新一組可學習的類原型嵌入,每一個嵌入都代表一個語義類,即 Pj 表示第 j 個類的嵌入。直觀地說,第 j 類的嵌入應該接近 Pj,并遠離其他類的原型。我們提出的損失是基于具有在線負采樣策略的三元組損失設計的。

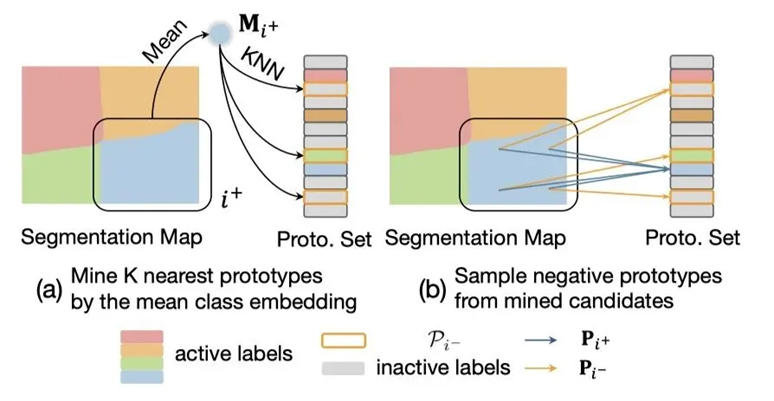

圖 4 在線負采樣策略

給定 VS-Net 的圖像分割分支輸出的逐像素特征圖E和類的原型集 P,首先我們對各個特征和原型進行 L2 規范化,然后使用基于特征原型的三元組損失對其進行優化,以使每個像素的特征更接近它對應的類的特征原型而遠離其他類的特征原型。對于正負采樣,我們設計了兩種采樣策略,一種是把當前預測的特征圖中所有具有相同 landmark id 的 embedding 每一維取均值作為我們的 anchor 特征向量,然后從 prototype set 中選擇正負樣本監督網絡訓練,也就是圖4(a) 的采樣方式。但這樣選擇的負樣本可能不夠充分,為了在不顯著增加計算量的同時保證負樣本的多樣性,我們對每個像素計算k個最相近的負樣本,也就是圖4(b) 所繪制的采樣方式。

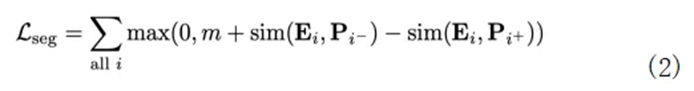

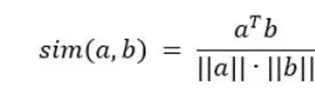

其中的:

表示像素向量和類原型向量之間的余弦相似度,m 代表三元組損失的邊際,P_(i+) 表示與像素 i 相對應的 ground-truth(正)類原型向量,P_(i-) 表示非對應的(負)類原型向量的采樣。

對于每個像素,如何在上述基于原型的三元組損失中確定其負類原型向量 Pi- 對最終性能有至關重要的影響,隨機抽樣負類會使訓練過于簡單。給定輸入圖像,我們觀察到活動地標的數量(即圖像中屬于地標的至少一個像素)是有限的。此外,屬于同一地標塊的像素在特征空間上彼此接近,并且會共享相似的負原型,因為它們具有相似的向量。因此,我們建議為每個活動地標挖掘代表性負類,每個像素隨機采樣來自挖掘類集的負類以形成代表三元組。

具體來說,給定一個有地標索引(類別)i+ 的像素 i,我們首先檢索輸入圖像中與地標 i+ 相關的所有像素向量,并取其平均值以獲得當圖像中地標的平均類向量值 Mi+。然后使用平均類向量從原型嵌入集中檢索 k 個最近鄰負原型 Pi。可以將這樣的 kNN 負原型認為是硬負樣本。三元組損失使用像素 i 的從 kNN 負向原型集中均勻采樣的單一負原型向量 Pi-(公式 (2) )。

基于方向向量的投票網絡:

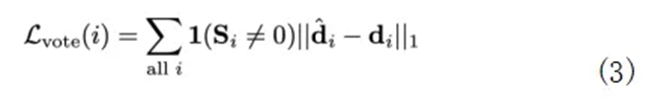

給定從上面介紹的分割解碼器生成的分割圖,輸入圖像中的每個像素要么被分配一個地標標簽,要么是一個無效的標簽,用于表示太遠的物體或區域(例如:天空)。我們使用了另一個投票解碼器,用于確定給定圖像中地標的投影 2D 位置。解碼器每個像素輸出一個 2D 方向向量,指向其相應地標的 2D 位置。投票解碼器使用以下損失監督,

其中1表示 L1 范數,其中的 和 分別表示像素 i 的 ground-truth 的投票方向和預測的投票方向。

訓練與定位:

整體損失 Loverall 是地標分割損失和地標方向投票損失的組合,

其中 λ 對損失項的貢獻進行加權。

在定位階段,我們將地標分割圖中預測具有相同地標標簽的像素組合在一起,我們通過計算預測投票圖中地標方向投票的交集來估計其對應的地標位置,稱為投票-分割算法。

具體的,給定分割圖,我們首先過濾掉像素隔宿小于閾值 Ts 的地標塊,因為太小的地標其指向的 2D 地標位置通常也是不穩定的。使用向量求交模型從 RANSAC 計算出地標的 2D 位置的初始估計,該模型通過計算兩個隨機采樣的定向投票的交叉并選擇具有最多的假設來生成多個地標位置假設內部投票。然后,位置通過迭代 EM 算法進一步細化。在 E 步驟中,我們從當前周圍圓形區域中收集地標 j 的內部投票向量。在 M 步中,我們采用了 Antonio 等人介紹的最小二乘法。根據圓形區域中的投票計算更新的地標位置。在迭代過程中,一個沒有得到足夠定向投票支持的投票地標,表明投票一致性低,將被舍棄。

Part 4 試驗結果

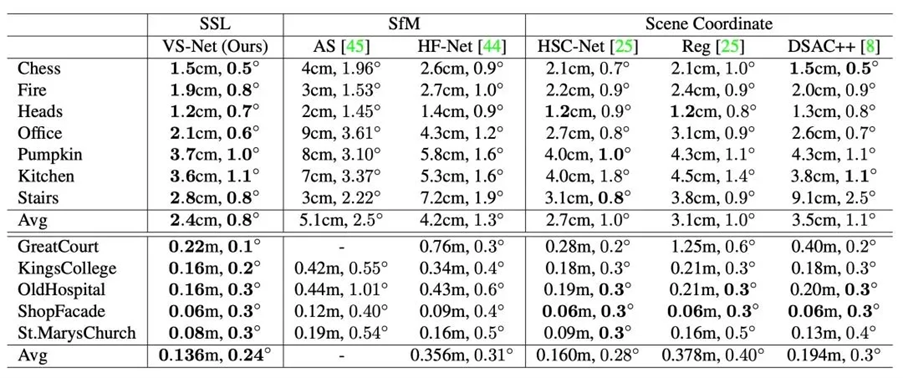

我們在 Microsoft 7-Scenes 和 Cambridge Landmarks 兩個數據集上與基于 SfM 和基于場景坐標回歸的視覺定位方法進行了比較。如表1所示,我們提出的基于定制化地標的視覺定位方案在所有場景中都取得了最好的精度,并在一些場景中(比如 GreatCourt 與 Office)顯著優于其他方法。

表 1 視覺定位精度比較。我們通過相機平移誤差與相機旋轉誤差的中位數來比較定位精度

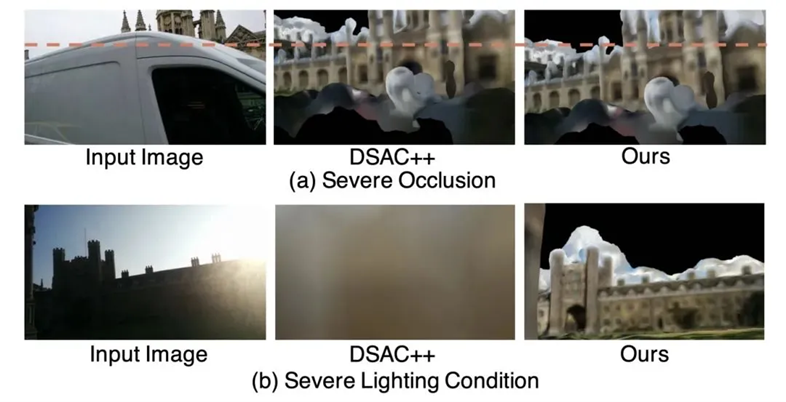

我們也對一些比較有挑戰的查詢圖像進行了視覺定位結果的比較。對給定的查詢圖像,我們用定位系統計算出相機位姿之后,將重建的 3D 模型投影到對應的相機位姿中。通過對比查詢圖像與重投影生成的圖像我們可以定性的比較視覺定位的結果。如圖5所示,盡管有比較極端的動態物體遮擋 圖5(a) 和惡劣的光照條件圖5(b),我們仍然能比較好地估計相機位姿。

圖 5對有挑戰性圖像的視覺定位

Reference:

[1]Sameer Agarwal, Yasutaka Furukawa, Noah Snavely, Ian Simon, Brian Curless, Steven M Seitz, and Richard Szeliski. Building rome in a day. Communications of the ACM, 54(10):105–112, 2011.

[2]Franklin Antonio. Faster line segment intersection. In Graphics Gems III (IBM Version), pages 199–202. Elsevier, 1992.

[3]Relja Arandjelovic, Petr Gronat, Akihiko Torii, Tomas Pajdla, and Josef Sivic. Netvlad: Cnn architecture for weakly supervised place recognition. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 5297–5307, 2016.

[4]Clemens Arth, Daniel Wagner, Manfred Klopschitz, Arnold Irschara, and Dieter Schmalstieg. Wide area localization on mobile phones. In 2009 8th ieee international symposium on mixed and augmented reality, pages 73–82. IEEE, 2009.

[5]Nicolas Aziere and Sinisa Todorovic. Ensemble deep manifold similarity learning using hard proxies. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 7299–7307, 2019.

[6]Herbert Bay, Tinne Tuytelaars, and Luc Van Gool. SURF: Speeded up robust features. In Proceedings of the European conference on computer vision, pages 404–417. Springer, 2006.

[7]Eric Brachmann, Alexander Krull, Sebastian Nowozin, Jamie Shotton, Frank Michel, Stefan Gumhold, and Carsten Rother. Dsac-differentiable ransac for camera localization. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 6684–6692, 2017.

[8]Eric Brachmann and Carsten Rother. Learning less is more6d camera localization via 3d surface regression. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 4654–4662, 2018.

[9]Eric Brachmann and Carsten Rother. Expert sample consensus applied to camera re-localization. In Proceedings of the IEEE International Conference on Computer Vision, pages 7525–7534, 2019.

[10]Samarth Brahmbhatt, Jinwei Gu, Kihwan Kim, James Hays, and Jan Kautz. Geometry-aware learning of maps for camera localization. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 2616– 2625, 2018.

[11]Ignas Budvytis, Marvin Teichmann, Tomas Vojir, and Roberto Cipolla. Large scale joint semantic re-localisation and scene understanding via globally unique instance coordinate regression. arXiv preprint arXiv:1909.10239, 2019.

[12]Federico Camposeco, Andrea Cohen, Marc Pollefeys, and Torsten Sattler. Hybrid scene compression for visual localization. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 7653–7662, 2019.

[13]Liang-Chieh Chen, George Papandreou, Florian Schroff, and Hartwig Adam. Rethinking atrous convolution for semantic image segmentation. CoRR, abs/1706.05587, 2017.

[14]Liang-Chieh Chen, George Papandreou, Iasonas Kokkinos, Kevin Murphy, and Alan L Yuille. Deeplab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected crfs. IEEE transactions on pattern analysis and machine intelligence, 40(4):834–848, 2017.

[15]Daniel DeTone, Tomasz Malisiewicz, and Andrew Rabinovich. Superpoint: Self-supervised interest point detection and description. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops, pages 224–236, 2018.

[16]Michael Donoser and Dieter Schmalstieg. Discriminative feature-to-point matching in image-based localization. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 516–523, 2014.

[17]Mihai Dusmanu, Ignacio Rocco, Tomas Pajdla, Marc Polle- ′ feys, Josef Sivic, Akihiko Torii, and Torsten Sattler. D2-net: A trainable CNN for joint description and detection of local features. In IEEE Conference on Computer Vision and Pattern Recognition, CVPR 2019, Long Beach, CA, USA, June 16-20, 2019, pages 8092–8101, 2019.

[18]Martin A Fischler and Robert C Bolles. Random sample consensus: a paradigm for model fitting with applications to image analysis and automated cartography. Communications of the ACM, 24(6):381–395, 1981.

[19]Yixiao Ge, Haibo Wang, Feng Zhu, Rui Zhao, and Hongsheng Li. Self-supervising fine-grained region similarities for large-scale image localization. arXiv preprint arXiv:2006.03926, 2020.

[20]Yisheng He, Wei Sun, Haibin Huang, Jianran Liu, Haoqiang Fan, and Jian Sun. Pvn3d: A deep point-wise 3d keypoints voting network for 6dof pose estimation. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 11632–11641, 2020.

[21]Zhaoyang Huang, Yan Xu, Jianping Shi, Xiaowei Zhou, Hujun Bao, and Guofeng Zhang. Prior guided dropout for robust visual localization in dynamic environments. In Proceedings of the IEEE International Conference on Computer Vision, pages 2791–2800, 2019.

[22]Marco Imperoli and Alberto Pretto. Active detection and localization of textureless objects in cluttered environments. arXiv preprint arXiv:1603.07022, 2016.

[23]Alex Kendall and Roberto Cipolla. Geometric loss functions for camera pose regression with deep learning. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 5974–5983, 2017.

[24]Alex Kendall, Matthew Grimes, and Roberto Cipolla. Posenet: A convolutional network for real-time 6-dof camera relocalization. In Proceedings of the IEEE international conference on computer vision, pages 2938–2946, 2015.

[25]Xiaotian Li, Shuzhe Wang, Yi Zhao, Jakob Verbeek, and Juho Kannala. Hierarchical scene coordinate classification and regression for visual localization. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 11983–11992, 2020.

[26]Yunpeng Li, Noah Snavely, and Daniel P Huttenlocher. Location recognition using prioritized feature matching. In European conference on computer vision, pages 791–804. Springer, 2010.

[27]Yutian Lin, Lingxi Xie, Yu Wu, Chenggang Yan, and Qi Tian. Unsupervised person re-identification via softened 6109 similarity learning. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 3390–3399, 2020.

[28]Yuan Liu, Zehong Shen, Zhixuan Lin, Sida Peng, Hujun Bao, and Xiaowei Zhou. Gift: Learning transformation-invariant dense visual descriptors via group cnns. In Advances in Neural Information Processing Systems, pages 6990–7001, 2019.

[29]Jonathan Long, Evan Shelhamer, and Trevor Darrell. Fully convolutional networks for semantic segmentation. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 3431–3440, 2015.

[30]David G Lowe. Distinctive image features from scaleinvariant keypoints. International journal of computer vision, 60(2):91–110, 2004.

[31]Jean-Michel Morel and Guoshen Yu. Asift: A new framework for fully affine invariant image comparison. SIAM journal on imaging sciences, 2(2):438–469, 2009.

[32]Yair Movshovitz-Attias, Alexander Toshev, Thomas K Leung, Sergey Ioffe, and Saurabh Singh. No fuss distance metric learning using proxies. In Proceedings of the IEEE International Conference on Computer Vision, pages 360–368, 2017.

[33]Richard A Newcombe, Shahram Izadi, Otmar Hilliges, David Molyneaux, David Kim, Andrew J Davison, Pushmeet Kohli, Jamie Shotton, Steve Hodges, and Andrew W Fitzgibbon. Kinectfusion: Real-time dense surface mapping and tracking. In ISMAR, volume 11, pages 127–136, 2011.

[34]Markus Oberweger, Mahdi Rad, and Vincent Lepetit. Making deep heatmaps robust to partial occlusions for 3d object pose estimation. In Proceedings of the European Conference on Computer Vision (ECCV), pages 119–134, 2018.

[35]Yuki Ono, Eduard Trulls, Pascal Fua, and Kwang Moo Yi. Lf-net: learning local features from images. In Advances in neural information processing systems, pages 6234–6244, 2018.

[36]Jeremie Papon, Alexey Abramov, Markus Schoeler, and Florentin Worg ¨ otter. Voxel cloud connectivity segmentation - ¨ supervoxels for point clouds. In Computer Vision and Pattern Recognition (CVPR), 2013 IEEE Conference on, Portland, Oregon, June 22-27 2013.

[37]Georgios Pavlakos, Xiaowei Zhou, Aaron Chan, Konstantinos G Derpanis, and Kostas Daniilidis. 6-dof object pose from semantic keypoints. In 2017 IEEE international conference on robotics and automation (ICRA), pages 2011–2018. IEEE, 2017.

[38]Sida Peng, Yuan Liu, Qixing Huang, Xiaowei Zhou, and Hujun Bao. Pvnet: Pixel-wise voting network for 6dof pose estimation. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 4561–4570, 2019.

[39]Qi Qian, Lei Shang, Baigui Sun, Juhua Hu, Hao Li, and Rong Jin. Softtriple loss: Deep metric learning without triplet sampling. In Proceedings of the IEEE International Conference on Computer Vision, pages 6450–6458, 2019.

[40]Tong Qin, Peiliang Li, and Shaojie Shen. Vins-mono: A robust and versatile monocular visual-inertial state estimator. IEEE Transactions on Robotics, 34(4):1004–1020, 2018.

[41]Jerome Revaud, Cesar De Souza, Martin Humenberger, and Philippe Weinzaepfel. R2d2: Reliable and repeatable detector and descriptor. In Advances in Neural Information Processing Systems, pages 12405–12415, 2019.

[42]Olaf Ronneberger, Philipp Fischer, and Thomas Brox. Unet: Convolutional networks for biomedical image segmentation. In International Conference on Medical image computing and computer-assisted intervention, pages 234–241. Springer, 2015.

[43]Ethan Rublee, Vincent Rabaud, Kurt Konolige, and Gary Bradski. ORB: An efficient alternative to SIFT or SURF. In Proceedings of the IEEE international conference on Computer Vision (ICCV), pages 2564–2571. IEEE, 2011.

[44]Paul-Edouard Sarlin, Cesar Cadena, Roland Siegwart, and Marcin Dymczyk. From coarse to fine: Robust hierarchical localization at large scale. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 12716–12725, 2019.

[45]Torsten Sattler, Bastian Leibe, and Leif Kobbelt. Improving image-based localization by active correspondence search. In European conference on computer vision, pages 752–765. Springer, 2012.

[46]Johannes L Schonberger and Jan-Michael Frahm. Structurefrom-motion revisited. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 4104–4113, 2016.

[47]Johannes Lutz Schonberger, Enliang Zheng, Marc Pollefeys, ¨ and Jan-Michael Frahm. Pixelwise view selection for unstructured multi-view stereo. In European Conference on Computer Vision (ECCV), 2016.

[48]Florian Schroff, Dmitry Kalenichenko, and James Philbin. Facenet: A unified embedding for face recognition and clustering. In Proceedings of the IEEE conference on computer vision and pattern recognition, pages 815–823, 2015.

[49]Jamie Shotton, Ben Glocker, Christopher Zach, Shahram Izadi, Antonio Criminisi, and Andrew Fitzgibbon. Scene coordinate regression forests for camera relocalization in rgb-d images. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 2930–2937, 2013.

[50]Chen Song, Jiaru Song, and Qixing Huang. Hybridpose: 6d object pose estimation under hybrid representations. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 431–440, 2020.

[51]Julien Valentin, Matthias Nie?ner, Jamie Shotton, Andrew Fitzgibbon, Shahram Izadi, and Philip HS Torr. Exploiting uncertainty in regression forests for accurate camera relocalization. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 4400–4408, 2015.

[52]Bing Wang, Changhao Chen, Chris Xiaoxuan Lu, Peijun Zhao, Niki Trigoni, and Andrew Markham. Atloc: Attention guided camera localization. In Proceedings of the AAAI Conference on Artificial Intelligence, volume 34, pages 10393– 10401, 2020.

[53]Qianqian Wang, Xiaowei Zhou, Bharath Hariharan, and Noah Snavely. Learning feature descriptors using camera pose supervision. arXiv preprint arXiv:2004.13324, 2020.

[54]Philippe Weinzaepfel, Gabriela Csurka, Yohann Cabon, and Martin Humenberger. Visual localization by learning objects-of-interest dense match regression. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 5634–5643, 2019.

[55]Changchang Wu et al. Visualsfm: A visual structure from motion system. 2011.

[56]Chao-Yuan Wu, R Manmatha, Alexander J Smola, and Philipp Krahenbuhl. Sampling matters in deep embedding learning. In Proceedings of the IEEE International Conference on Computer Vision, pages 2840–2848, 2017.

[57]Tong Xiao, Shuang Li, Bochao Wang, Liang Lin, and Xiaogang Wang. Joint detection and identification feature learning for person search. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, pages 3415–3424, 2017.

[58]Yan Xu, Zhaoyang Huang, Kwan-Yee Lin, Xinge Zhu, Jianping Shi, Hujun Bao, Guofeng Zhang, and Hongsheng Li. Selfvoxelo: Self-supervised lidar odometry with voxel-based deep neural networks. Conference on Robot Learning, 2020.

[59]Fei Xue, Xin Wu, Shaojun Cai, and Junqiu Wang. Learning multi-view camera relocalization with graph neural networks. In 2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), pages 11372–11381. IEEE, 2020.

[60]Fisher Yu and Vladlen Koltun. Multi-scale context aggregation by dilated convolutions. In 4th International Conference on Learning Representations, ICLR 2016, San Juan, Puerto Rico, May 2-4, 2016, Conference Track Proceedings, 2016.

[61]Bernhard Zeisl, Torsten Sattler, and Marc Pollefeys. Camera pose voting for large-scale image-based localization. In Proceedings of the IEEE International Conference on Computer Vision, pages 2704–2712, 2015.

[62]Guofeng Zhang, Zilong Dong, Jiaya Jia, Tien-Tsin Wong, and Hujun Bao. Efficient non-consecutive feature tracking for structure-from-motion. In European Conference on Computer Vision, pages 422–435. Springer, 2010.

[63]Liang Zheng, Yujia Huang, Huchuan Lu, and Yi Yang. Poseinvariant embedding for deep person re-identification. IEEE Transactions on Image Processing, 28(9):4500–4509, 2019.

[64]Zilong Zhong, Zhong Qiu Lin, Rene Bidart, Xiaodan Hu, Ibrahim Ben Daya, Zhifeng Li, Wei-Shi Zheng, Jonathan Li, and Alexander Wong. Squeeze-and-attention networks for semantic segmentation. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 13065–13074, 2020.

[65]Zhun Zhong, Liang Zheng, Zhiming Luo, Shaozi Li, and Yi Yang. Learning to adapt invariance in memory for person reidentification. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020.

[66]Lei Zhou, Zixin Luo, Tianwei Shen, Jiahui Zhang, Mingmin Zhen, Yao Yao, Tian Fang, and Long Quan. Kfnet: Learning temporal camera relocalization using kalman filtering. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pages 4919–4928, 2020.

[67] Siyu Zhu, Tianwei Shen, Lei Zhou, Runze Zhang, Jinglu Wang, Tian Fang, and Long Quan. Parallel structure from motion from local increment to global averaging. arXiv preprint arXiv:1702.08601, 2017.

返回

返回

人工智能基礎設施

人工智能基礎設施 企業服務智能化

企業服務智能化 城市管理智能化

城市管理智能化 汽車出行智能化

汽車出行智能化 個人生活智能化

個人生活智能化