ISMAR 2021|商湯和浙江大學聯合提出移動端高質量在線三維掃描儀Mobile3DScanner

Mobile3DScanner: An Online 3D Scanner for High-quality Object Reconstruction with a Mobile Device

Part 1 相關工作

目前主要的靜態物體重建方法可以分為兩類:基于RGBD相機的三維掃描重建與基于圖像的多視圖重建。

1.1 基于RGBD相機的三維掃描重建

此類方法以KinectFusion[3]為代表,對輸入的深度圖利用ICP求解相機位姿,并將深度圖融合成一個全局的TSDF模型,類似的工作還有InfiniTAM[2]以及BundleFusion[1],但由于計算復雜度以及內存占用的原因,它們只能在PC端運行。此外,還有[8][9][10]等結合用戶手操作的交互式掃描重建方法以及基于非剛性注冊的物體掃描重建[11],這類方法大多適用于小物體重建。

1.2 基于圖像的多視圖重建

此類方法致力于在移動設備上實現基于單目RGB視頻的物體掃描重建,他們利用多視圖立體匹配的方法恢復出單幀的深度并將深度融合成TSDF模型[12][13]或者Surfel模型[14][15]。總體而言,這類方法重建出的模型在模型精度以及完整度上與基于RGBD相機的重建方法相比還有一定差距。

Part 2 方法描述

2.1 系統概述

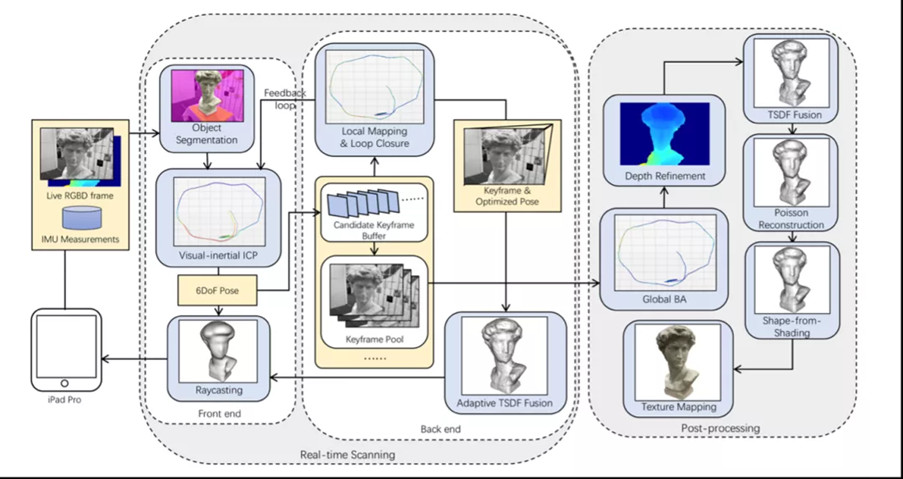

如圖1所示,我們的重建系統要求用戶配備一個帶有RGBD攝像頭的移動計算設備,并將待掃描的物體放置在一個水平面上。用戶開始掃描后,系統將自動分割出物體區域并實時求解相機位姿,深度傳感器獲取到的深度數據將被融合成TSDF模型并渲染供用戶作實時預覽。掃描結束后,系統將對所有的關鍵幀進行全局BA并結合多視圖立體匹配方法來優化關鍵幀的深度,最終融合出的TSDF模型經由泊松重建[16]、Shape-from-Shading以及紋理貼圖后,得到最終帶紋理的重建模型。

我們用 Semantic Field 來實現對人臉特征連續且高細粒度可控的編輯。對話功能則由 Language Encoder和Talk模塊來實現。接下來我們解釋各個模塊的工作原理和效果。

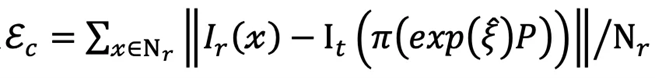

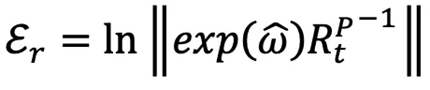

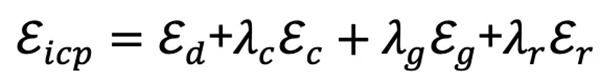

2.2 ICP與IMU松耦合

移動平臺算力有限,我們提出將ICP與IMU進行松耦合來提升相機位姿求解的魯棒性與精度。我們首先利用初始兩幀的ICP結果對IMU模塊進行初始化,IMU初始化完成后即可依據輸入的IMU數據為當前幀提供位姿預測,我們再將IMU的預測值加入ICP能量項來求解當前幀的相機位姿,當前幀位姿求解完成后,其結果將作為約束來進一步優化IMU的狀態量[17]。原本的ICP能量項[4]考慮了兩幀之間的顏色差和深度差:

![]()

在此基礎上我們加入了IMU的旋轉約束以及重力約束:

![]()

構建最終的能量方程

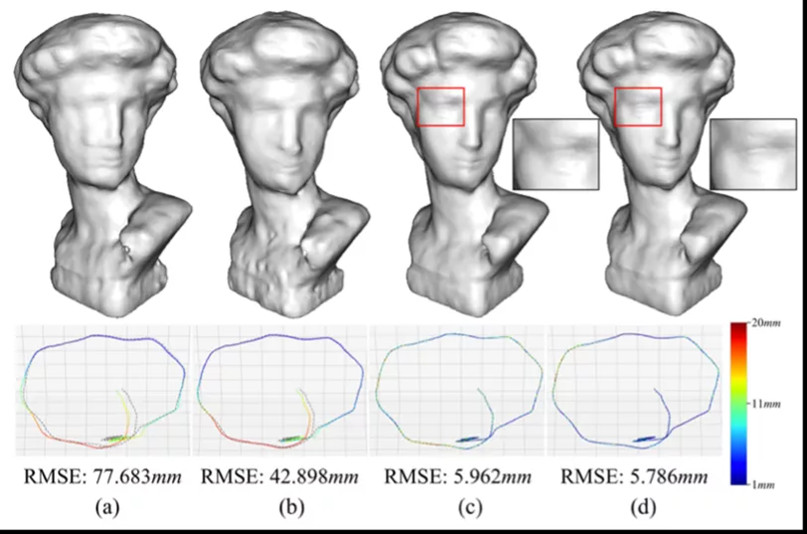

圖2展示了我們方法的有效性。

圖2.(a)Open3D[4] ICP. (b)引入IMU. (c)(d)加入LBA以及Loop Closure.

2.3 自適應調節體素的TSDF

移動平臺上內存有限,必須約束TSDF模型的大小,我們提出一種自適應調節體素的TSDF方法,當其內存占用量達到閾值時,系統將自動創建一個新的TSDF,其體素大小為舊體素的1.5倍,新體素的符號距離以及權重無需重新計算,可通過舊體素三線性插值高效獲取。這個策略可保證TSDF模型的內存占用不會超過用戶設定的閾值,從而在移動設備上能支持大物體的掃描重建。

2.4 結合深度先驗的多視圖立體匹配

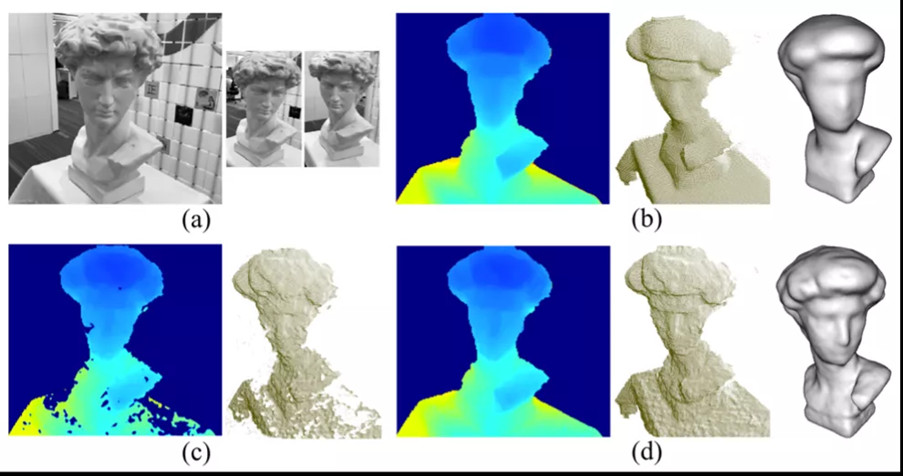

消費級的深度傳感器例如dToF,其獲取的深度存在不同程度的錯誤以及過平滑問題,我們提出一種結合深度先驗的SGM方法,利用視覺信息來提升深度圖的精度,其效果如圖3所示。

圖3.(a)關鍵幀. (b)dToF單幀深度以及融合后的模型. (c)SGM[6]單幀深度. (d)結合深度先驗的SGM及其模型.

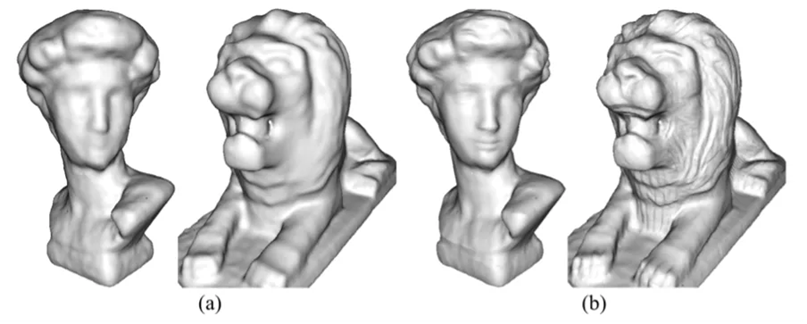

2.5 高效的Shape-from-Shading

Shape-from-Shading可以提升重建模型的幾何細節,但目前已有的實現方案無論是計算復雜度還是內存占用都遠無法在移動平臺上實施。不同于現有方案,我們直接在重建好的模型上優化三角面片的法向量,再結合方法[5]更新模型頂點。以圖4中的“David”為例,我們的方法在iPad Pro2020 CPU上耗時3.24秒,優化后模型精度RMSE/MAE為3.12mm/2.473mm。而Intrinsic3D[7]在PC端Intel Core i7 7700K CPU上耗時81分鐘得到略優的結果,RMSE/MAE為2.89mm與2.16mm。

圖4.(a)初始模型. (b)SFS優化后的模型

Part 3 實驗結果

3.1 模型精度對比

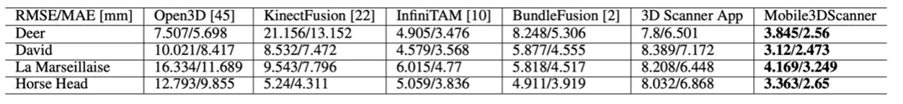

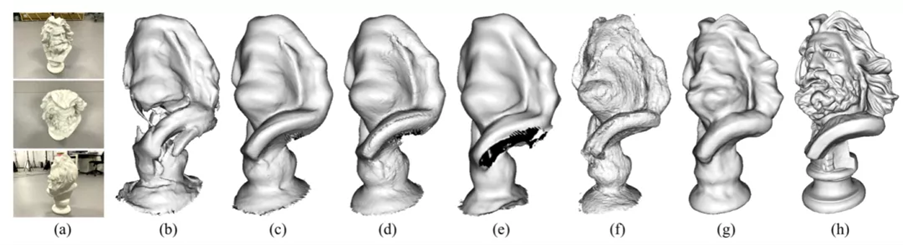

我們用iPad Pro2020錄制了四組測試數據來對比我們的方案與現有的方案在模型精度上的差異,ground truth由商業掃描儀獲取。表格1以及圖5顯示我們的方法在模型精度以及完整度上都取得了最優結果。

表格1.模型精度對比(RMSE/MAE)

圖5.與現有SOTA方法的模型對比.

(b)Open3D[4].(c)KinectFusion[3].(d)InfiniTAM[2].(e)BundleFusion[1].(f)3D Scanner App.(g)我們的方法.(h)GT.

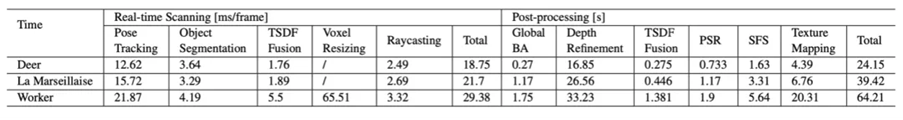

3.2 耗時統計

表格2統計了算法各個步驟在iPad Pro2020上的耗時,我們的方法在大物體“worker”上也達到了實時。

表格2:算法模塊耗時統計

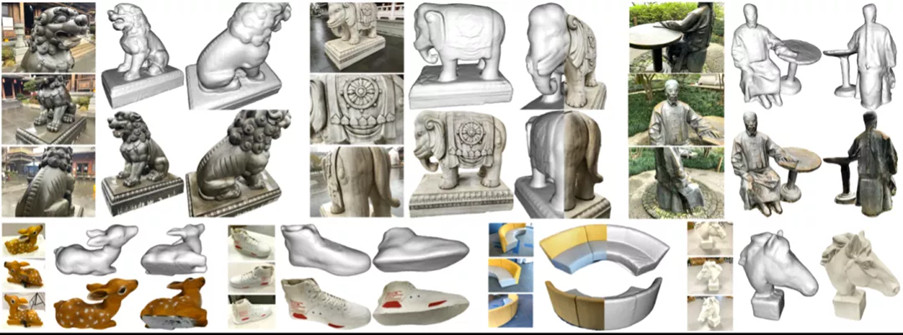

3.3 更多結果

Reference:

[1] Dai, M. Nie?ner, M. Zollho ?fer, S. Izadi, and C. Theobalt. BundleFusion: Real-time globally consistent 3D reconstruction using on-the-fly surface re-integration. ACM Transactions on Graphics, 36(4):1, 2017.

[2] O. Kahler, V. Prisacariu, C. Ren, X. Sun, P. Torr, and D. Murray. Very high frame rate volumetric integration of depth images on mobile devices. IEEE Transactions on Visualization and Computer Graphics, 21(11):1–1, 2015.

[3] R. A. Newcombe, S. Izadi, O. Hilliges, D. Molyneaux, and A. W. Fitzgibbon. KinectFusion: Real-time dense surface mapping and tracking. In IEEE International Symposium on Mixed and Augmented Reality, 2011.

[4] Q. Zhou, J. Park, and V. Koltun. Open3D: A modern library for 3D data processing. arXiv:1801.09847, 2018.

[5] H. Zhao, K. Su, C. Li, B. Zhang, L. Yang, N. Lei, X. Wang, S. J. Gortler, and X. Gu. Mesh parametrization driven by unit normal flow. Computer Graphics Forum, 39(1):34–49, 2020.

[6] H. Hirschmu ?ller. Accurate and efficient stereo processing by semi-global matching and mutual information. In IEEE Computer Society Conference on Computer Vision and Pattern Recognition, vol. 2, pp. 807–814, 2005.

[7] R. Maier, K. Kim, D. Cremers, J. Kautz, and M. Nie?ner. Intrinsic3D: High-quality 3D reconstruction by joint appearance and geometry optimization with spatially-varying lighting. In IEEE International Conference on Computer Vision, 2017.

[8] S. Rusinkiewicz, O. Hall-Holt, and M. Levoy. Real-time 3D model acquisition. ACM Transactions on Graphics, 21(3):438–446, 2002.

[9] D. Tzionas and J. Gall. 3D object reconstruction from hand-object interactions. In IEEE International Conference on Computer Vision, pp. 729–737, 2015.

[10] T. Weise, B. Leibe, and L. Van Gool. Accurate and robust registration for in-hand modeling. In IEEE Conference on Computer Vision and Pattern Recognition, pp. 1–8, 2008.

[11] J. Xu, W. Xu, Y. Yang, Z. Deng, and H. Bao. Online global non-rigid registration for 3D object reconstruction using consumer-level depth cameras. 37(7):1–12, 2018.

[12] P. Ondru ?sˇka, P. Kohli, and S. Izadi. MobileFusion: Real-time volumetric surface reconstruction and dense tracking on mobile phones. IEEE Trans- actions on Visualization and Computer Graphics, 21(11):1251–1258, 2015.

[13] V. Pradeep, C. Rhemann, S. Izadi, C. Zach, M. Bleyer, and S. Bathiche. MonoFusion: Real-time 3D reconstruction of small scenes with a single web camera. In IEEE International Symposium on Mixed and Augmented Reality, 2013.

[14] P. Tanskanen, K. Kolev, L. Meier, F. Camposeco, O. Saurer, and M. Polle- feys. Live metric 3D reconstruction on mobile phones. In IEEE Interna- tional Conference on Computer Vision, pp. 65–72, 2013.

[15] K. Kolev, P. Tanskanen, P. Speciale, and M. Pollefeys. Turning mobile phones into 3D scanners. In IEEE Conference on Computer Vision and Pattern Recognition, 2014.

[16] M. Kazhdan. Poisson surface reconstruction. In Eurographics Symposium on Geometry Processing, 2006.

[17] T. Qin, P. Li, and S. Shen. Vins-mono: A robust and versatile monocular visual-inertial state estimator.

返回

返回

人工智能基礎設施

人工智能基礎設施 企業服務智能化

企業服務智能化 城市管理智能化

城市管理智能化 汽車出行智能化

汽車出行智能化 個人生活智能化

個人生活智能化