- 核心技術

- 以原創技術體系為根基,SenseCore商湯AI大裝置為核心基座,布局多領域、多方向前沿研究,

快速打通AI在各個垂直場景中的應用,向行業賦能。

CVPR 2023 Award Candidate | 真實高精三維物體數據集OmniObject3D

背景介紹

面向真實 3D 物體的感知、理解、重建與生成是計算機視覺領域一直倍受關注的問題,也在近年來取得了飛速的進展。然而,由于社區中長期缺乏大規模的實采 3D 物體數據庫,大部分技術方法仍依賴于 ShapeNet[1] 等仿真數據集。再者,仿真數據與真實數據之間的外觀和分布差距巨大,這大大限制了它們在現實生活中的應用。

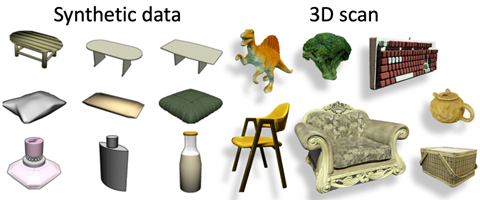

為了解決這一困難,近年來也有一些優秀的工作如 CO3D[2] 等從視頻/多視角圖片中尋求突破點,并利用 SfM 的方式重建 3D 點云,然而這種方式得到的點云往往難以提供完整、干凈、精準的 3D 表面和紋理。因此,社區迫切需要一個大規模且高質量的真實世界 3D 物體掃描數據集,這將有助于推進許多3D視覺任務和下游應用。

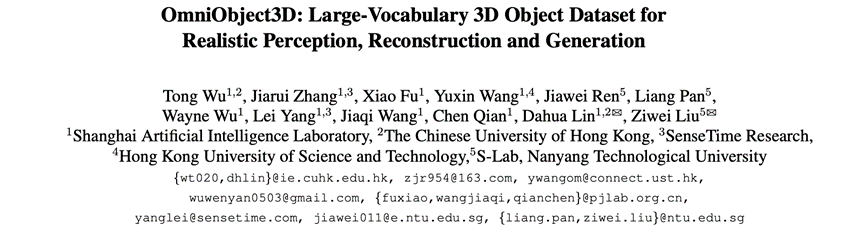

仿真數據與真實掃描數據的對比:仿真數據的紋理和幾何往往比較簡單且失真。

多視角圖片重建點云與真實掃描數據的對比。重建點云往往含有噪聲,且無法恢復精細的表面與紋理,在沒有拍攝到的位置存在大面積空洞。

數據集特點

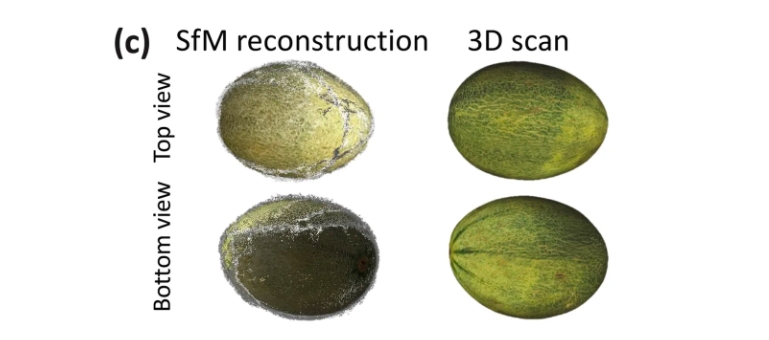

OmniObject3D 為每一個物體提供了四種模態信息,包括:帶紋理的高精模型、點云、多視角渲染圖像、實景拍攝的環繞視頻。對于每個拍攝的視頻,我們平均抽取了 200 幀,并提供前景掩碼和 SfM 重建的相機位姿和稀疏點云。

模態示例

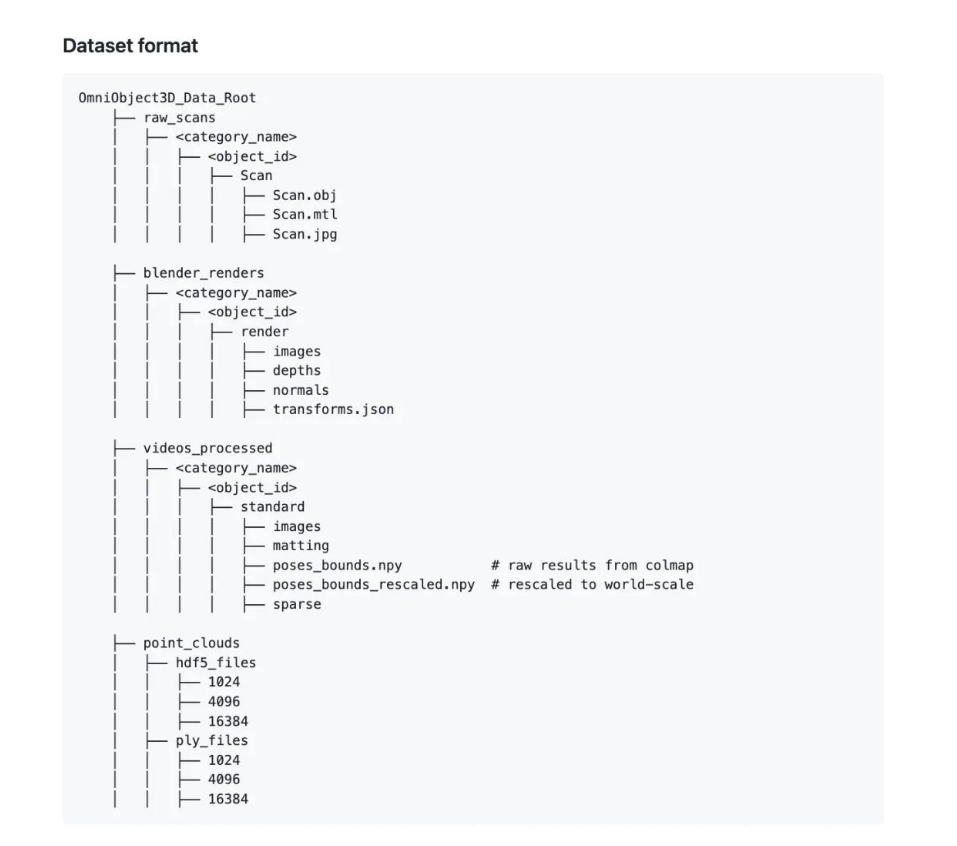

文件層級

數據集的整體類別內物體數量呈長尾分布,與 ImageNet[3]、COCO[4]、LVIS[5] 和 ShapeNet[1] 等熱門 2D 及 3D 數據集中的常見類別有高度共享。

每個類別內物體數量分布圖

下游應用

OmniObject3D 為學界帶來了廣泛的探索空間,在本文中,我們選取了四個下游任務進行評估與分析。

任務一:

點云分類魯棒性(Point Cloud Classification Robustness)

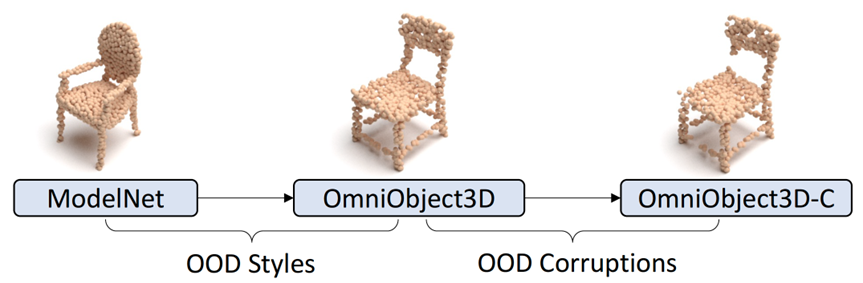

物體點云分類是 3D 感知中最基本的任務之一。在本節中,我們展示了 OmniObject3D 如何通過解耦 out-of-distribution styles & out-of-distribution corruptions 來實現更全面的點云分類的魯棒性分析。

OmniObject3D 提供了一個干凈的真實世界物體點云數據集,使得能夠針對 OOD styles & OOD corruptions 的魯棒性進行細粒度分析。

具體來說,1)CAD 模型與真實掃描模型之間的差異引入了 OOD styles;2)常見點云破壞因子產生了 OOD corruptions。

在之前的研究工作中,含噪的真實物體數據集如 ScanObjectNN[6] 將兩種情況藕合起來,無法實現解耦分析;主動加入破壞因子的仿真數據集如 ModelNet-C[7] 則僅僅反映了第二種情況。OmniObject3D 則具備將兩種情況解耦分析的要素。

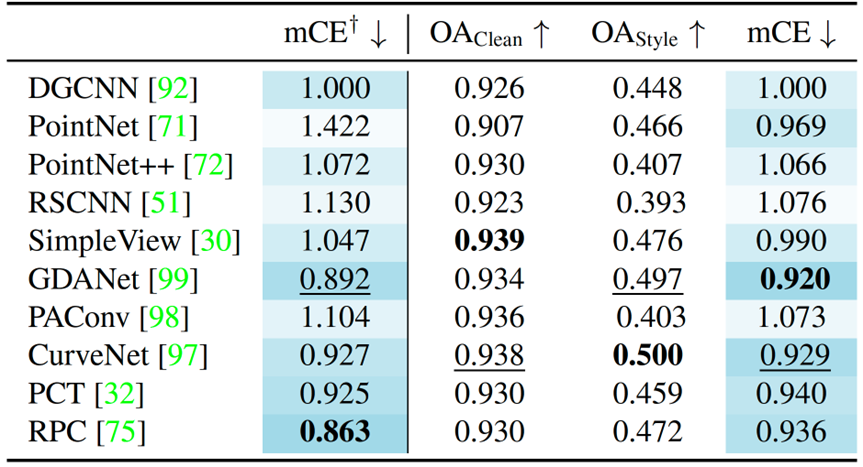

我們對十種最常見的點云分類模型進行了測試,并揭示了其與 ModelNet-C 數據集中結論的異同。在應對這兩個挑戰時,如何實現一個真正魯棒的點云感知模型仍需更加深度的探索。

點云分類魯棒性實驗結果

任務二:

新視角合成(Novel View Synthesis)

自 NeRF[8] 提出以來,新視角合成一直是領域內的一個熱門方向。

我們在 OmniObject3D 上研究了兩種賽道下的新視角合成方法:

1)利用密集視角圖片輸入,對單一場景進行優化訓練;

2)挖掘數據集中不同場景之間的先驗,探索類 NeRF 模型的泛化能力。

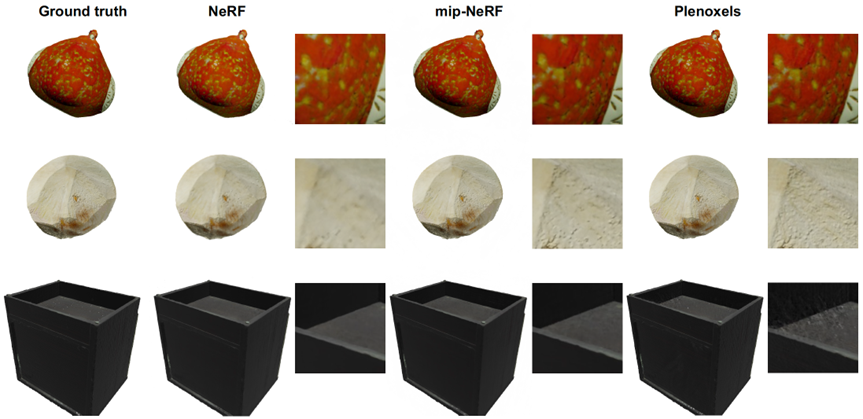

首先,對于單場景優化的模型,我們觀察到基于體素的方法會更加擅長建模高頻紋理信息,而基于隱式模型的方法則相對更能抵抗表面凹陷或弱紋理等容易產生幾何歧義的情況。

數據集中物體多變而復雜的形狀和外觀為這項任務提供了一個全新的評估基準。

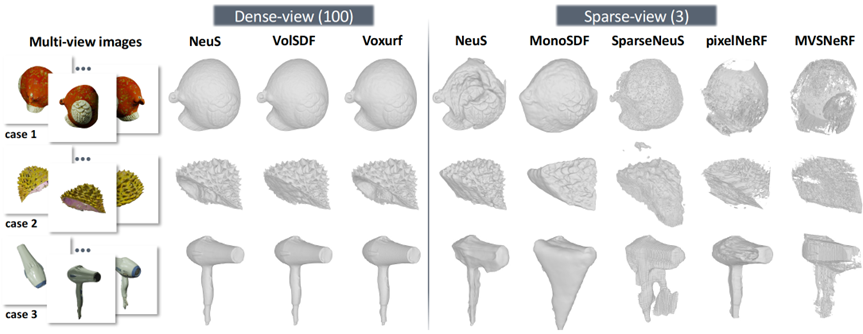

多個常見方法的單場景優化效果示例

相對于擬合的單個場景的模型,跨場景可泛化框架在本數據集上的表現則更令人期待。網絡從很多同類別、甚至跨類別的數據中學習到可以泛化的信息,即可對于一個全新場景的稀疏視角輸入做出新視角預測。

實驗表明,作為一個幾何和紋理信息豐富的數據集,OmniObject3D 有助于促使模型學到對新物體或甚至新類別的泛化能力。

泛化性模型效果示例

任務三:

表面重建(Surface Reconstruction)

除了新視角合成外,如果能恢復物體的顯式表面,將更加有助于下游應用的開發。同時,我們的數據具備精準且完整的三維表面,能夠充分支持表面重建精度的評測需要。

類似的,我們也為表面重建任務設置了兩條賽道:

1)稠密視角采樣下的表面重建;

2)稀疏視角采樣下的表面重建。

稠密視角下表面重建結果展示了數據集內幾何形狀的顯著多樣性。精準的掃描使得我們能夠使用 Chamfer Distance 作為重建精度的度量。將類別劃分為三個“難度”等級,可以觀察到所有方法在不同等級上的結果存在明顯的差距。

與僅包含 15 個場景的標準 DTU[9] 基準相比,我們的數據集在這項任務上提供了更全面的評估結果。

稠密視角表面重建示例

稀疏視圖表面重建是一個更具挑戰性的任務,在所有方法的結果中我們都觀察到了明顯瑕疵,均未達到能夠滿足實際應用的水平。

除了專為稀疏視角表面重建設計的方法外,我們還評估了前面提到的泛化性新視角合成模型的幾何恢復能力——數據集提供的精準 3D Ground Truth 在評測中再次發揮了優勢,然而他們的表現同樣無法令人滿意。

綜上所述,這個問題的探索空間仍然巨大,而 OmniObject3D 為該領域進一步的研究提供了扎實的數據基礎。

稠密和稀疏視角表面重建效果示例

任務四:

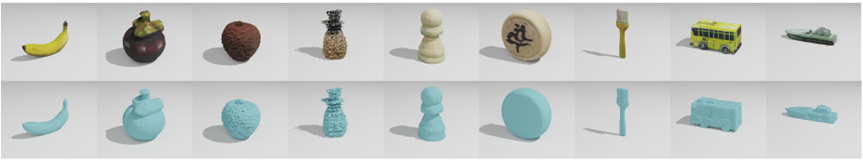

3D 物體生成(3D Object Generation)

除了重建之外,OmniObject3D 還可以用來訓練真實 3D 物體的生成模型。我們采用 GET3D[10] 框架同時生成形狀和紋理,并嘗試使用單個模型從數據集中同時學習多種類別的生成。

帶紋理的3D物體生成

通過在隱空間插值,可以觀察到生成模型跨類別變化的特性。我們在文章中還著重探討了由于訓練數據不平衡導致的生成語義分布失衡特點,詳細請參考論文。

形狀和紋理低維隱碼插值結果

未來工作

關于數據集本身,我們會致力于不斷擴大和更新數據集以滿足更廣泛的研究需求。除了現有的應用,我們還計劃進一步發展其他下游任務,如2D/3D物體檢測和6D姿態估計等。除了感知和重建任務外,在AIGC時代,我們相信OmniObject3D能夠在推動真實感3D生成方面發揮至關重要的作用。

傳送門

Project page

https://omniobject3d.github.io/

Paper

https://arxiv.org/abs/2301.07525

Github

https://github.com/omniobject3d/OmniObject3D/tree/main

Dataset Download

https://opendatalab.com/OpenXD-OmniObject3D-New/download

References:

[1] Angel X Chang, Thomas Funkhouser, Leonidas Guibas, Pat Hanrahan, Qixing Huang, Zimo Li, Silvio Savarese, Manolis Savva, Shuran Song, Hao Su, et al. Shapenet: An information-rich 3d model repository. arXiv.org, 1512.03012, 2015.

[2] Jeremy Reizenstein, Roman Shapovalov, Philipp Henzler, Luca Sbordone, Patrick Labatut, and David Novotny. Common objects in 3d: Large-scale learning and evaluation of real-life 3d category reconstruction. In Proceedings of the IEEE/CVF International Conference on Computer Vision (ICCV), pages 10901–10911, 2021.

[3] Jia Deng, Wei Dong, Richard Socher, Li-Jia Li, Kai Li, and Li Fei-Fei. Imagenet: A large-scale hierarchical image database. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), pages 248–255, 2009.

[4] Tsung-Yi Lin, Michael Maire, Serge Belongie, James Hays, Pietro Perona, Deva Ramanan, Piotr Doll′ar, and C Lawrence Zitnick. Microsoft coco: Common objects in context. In Proceedings of the European Conference on Computer Vision (ECCV), pages 740–755, 2014.

[5] Agrim Gupta, Piotr Dollar, and Ross Girshick. LVIS: A dataset for large vocabulary instance segmentation. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), pages 5356–5364, 2019.

[6] Mikaela Angelina Uy, Quang-Hieu Pham, Binh-Son Hua, Thanh Nguyen, and Sai-Kit Yeung. Revisiting point cloud classification: A new benchmark dataset and classification model on real-world data. In Proceedings of the IEEE/CVF International Conference on Computer Vision (ICCV), pages 1588–1597, 2019.

[7] Jiawei Ren, Liang Pan, and Ziwei Liu. Benchmarking and analyzing point cloud classification under corruptions. In Proceedings of the International Conference on Machine learning (ICML), 2022.

[8] Ben Mildenhall, Pratul P Srinivasan, Matthew Tancik, Jonathan T Barron, Ravi Ramamoorthi, and Ren Ng. Nerf: Representing scenes as neural radiance fields for view synthesis. In Proceedings of the European Conference on Computer Vision (ECCV), pages 405–421, 2020.

[9] Henrik Aan?s, Rasmus Ramsb?l Jensen, George Vogiatzis, Engin Tola, and Anders Bjorholm Dahl. Large-scale data for multiple-view stereopsis. International Journal of Computer Vision (IJCV), 120(2):153–168, 2016.

[10] Jun Gao, Tianchang Shen, Zian Wang, Wenzheng Chen, Kangxue Yin, Daiqing Li, Or Litany, Zan Gojcic, and Sanja Fidler. Get3d: A generative model of high quality 3d textured shapes learned from images. In Advances in Neural Information Processing Systems (NIPS), 2022.

返回

返回