- 核心技術

- 以原創技術體系為根基,SenseCore商湯AI大裝置為核心基座,布局多領域、多方向前沿研究,

快速打通AI在各個垂直場景中的應用,向行業賦能。

CVPR 2023 Highlight | Consistent-Teacher:半監督目標檢測超強SOTA

半監督目標檢測的現狀總結

目標檢測是計算機視覺領域的核心問題之一,其重要性不可忽視。然而,要實現準確的目標檢測,需要大量標記的數據,這也是該領域的一個關鍵問題。換句話說,數據標注是目標檢測算法的基礎,缺乏足夠的標記數據將會極大地限制算法的性能和應用范圍。因此,解決數據標注問題是實現準確、高效目標檢測的必要條件。

半監督學習(SSL)是一種利用少量有標簽數據和大量無標簽數據進行訓練以提高模型性能的機器學習方法。在圖像分類、目標檢測等領域,SSL已經被廣泛應用。在目標檢測領域,半監督目標檢測(SSOD)能夠有效利用大量無標注數據進行訓練,具有重要的應用價值。

SSOD的基本模式是Teacher-Student[4,5,6,7]模式。該方法首先利用少量已標注數據對初始模型進行訓練,同時使用教師模型對大量未標注數據進行推斷,并將推斷結果作為偽標簽加入訓練集。期望學生模型能夠準確檢測這些偽標簽,并對增強后的輸入樣本做出一致的預測。

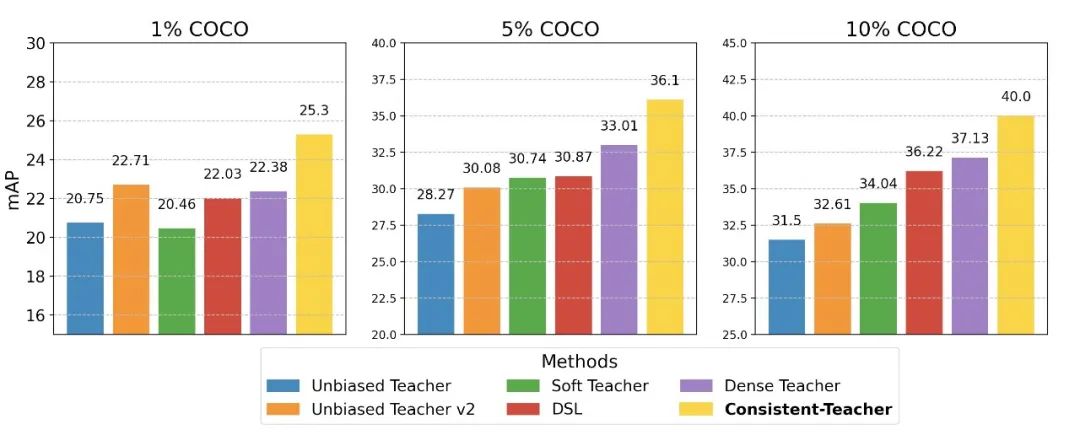

我們首先介紹這篇論文的基線模型Mean-Teacher,方便讀者對這篇論文有更好的理解。

如圖所示,Mean-Teacher[1]是一種半監督目標檢測框架。它利用有標簽數據和無標簽數據進行訓練,其中Teacher模型生成偽標簽,并給Student模型作為監督信號。Teacher模型的參數由是Student模型參數的指數滑動平均(Exponential Moving Average)得到。相對應,Student模型在進行過增強的未標注樣本上進行訓練,利用Teacher模型推斷得到的偽標簽進行監督。通過這種方式,Mean-teacher實現多視角一致的自監督訓練。

在Mean-Teacher的基礎上,現有半監督目標檢測方法通過各種方法提高偽標簽的準確性,但由于缺乏足夠的標注數據,訓練過程中常常出現偽標簽邊界框質量較差的問題,這會導致模型的不穩定性和性能的下降。

本文對偽標簽質量較差的原因進行系統性的分析,發現關鍵問題在于偽標簽的不穩定性與不一致性,從而給予Student模型不穩定以及不一致的偽監督信號。

偽標簽的不穩定性:SSOD的阿喀琉斯之踵

在半監督目標檢測中,生成的偽標簽存在不穩定(Inconsistency)的問題,這不僅影響偽標簽的準確性,也會導致模型訓練的不穩定和性能下降。

主流的半監督目標檢測器生成偽標簽時是基于當前時刻的Teacher模型的預測。與全監督訓練時的靜態標簽(在訓練過程中不會變化)不同,一個無標簽圖像中一個物體的偽標簽可能在訓練過程中某個時間點出現,不斷變化,直至最后穩定或消失。在使用這種極不穩定的偽標簽監督下進行訓練會導致一系列問題,如模型性能下降、難以達到理想效果等。我們列舉了三種不穩定性產生的原因如下:

分配不一致

當前主流的兩階段(Two-stage)或者單階段(Single-stage)目標檢測網絡都使用基于IoU閾值的靜態anchor分配方法,這種方法對于偽標簽框中的噪聲非常敏感。即使偽標簽框中只有微小的噪聲,偽標簽的不穩定性也會導致anchor分配的不同。

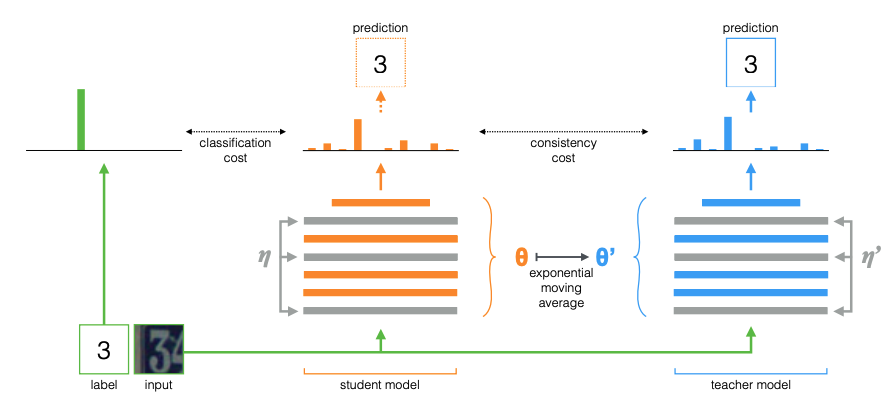

本文通過下圖說明在Mean-Teacher框架下RetinaNet[2]檢測器中,偽標簽不穩定性會導致的問題。綠色和紅色的邊界框是北極熊的實際邊界框和偽邊界框,紅點是偽標簽的錨定框。熱圖顯示了教師模型預測的密集置信度得分。

在Mean-Teacher中,由于Teacher生成偽標簽的不穩定性,在利用偽標簽對Student進行偽監督訓練時,Student會不時地將anchor assign到旁邊的木板上。由于這種不一致的標簽,Student模型最終會過擬合噪聲并導致附近的木板被檢測到并錯誤地分類為北極熊。

本文同時展示了一個anchor box 在訓練過程中動態變化的動圖。如下圖(a)為Mean-Teacher,使用基于IOU閾值的靜態anchor分配方法,隨著訓練進行,由于Teacher生成偽標簽的不穩定性,在利用偽標簽對Student進行偽監督訓練時,Student會不時的將anchor assign到旁邊的木板上。而本文提出的Consistent-Teacher,如下圖(b)則可以穩定持續的定位到正確的前景物體并分配正確的分配anchor。

(a) Mean-Teacher

(b) Consistent-Teacher

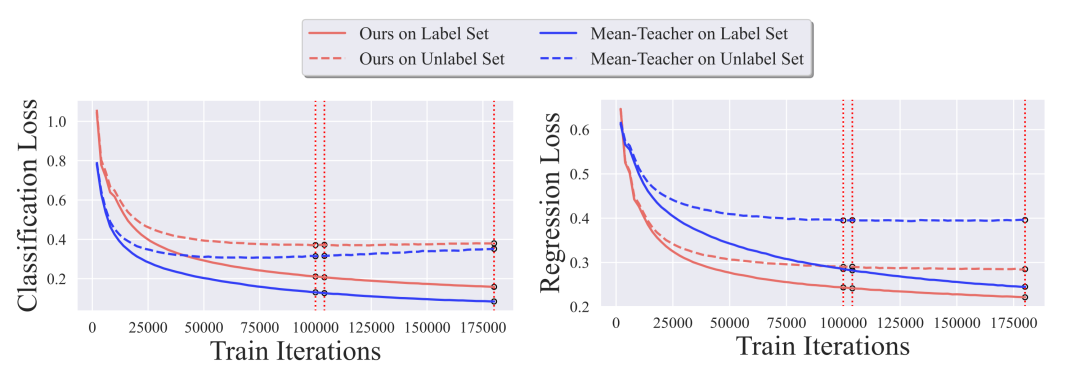

這種對噪聲的過擬合同樣可以在分類損失圖中看到,不一致的偽目標會導致分類分支過擬合,而回歸損失則難以收斂(如下圖)。

任務不一致

在主流的半監督目標檢測方法中,分類與回歸任務的不一致也是導致不穩定性的一個重要原因。

為了篩選高質量的偽標簽,通常會使用分類置信度作為指標,并設置閾值來篩除低置信度的偽標簽框。然而,一個偽標簽框的分類置信度好壞并不一定能反映其定位準確度的高低。

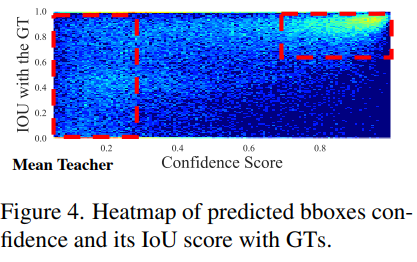

因此,利用分類置信度進行偽標簽篩選的方法會進一步加劇偽標簽在訓練過程中的不穩定性。如下圖(a)所示,Mean-Teacher中存在大量分類置信度高但是回歸不準確(與GT的IOU較低)的定位框。

(a) 任務不一致

(b) 時序不一致

時序不一致

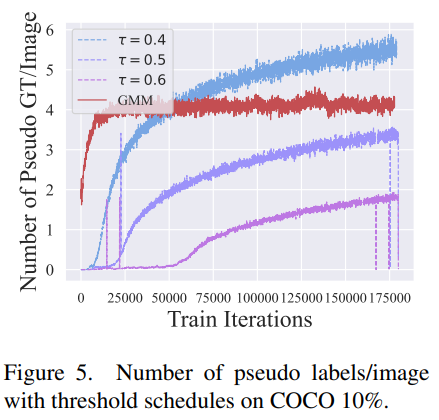

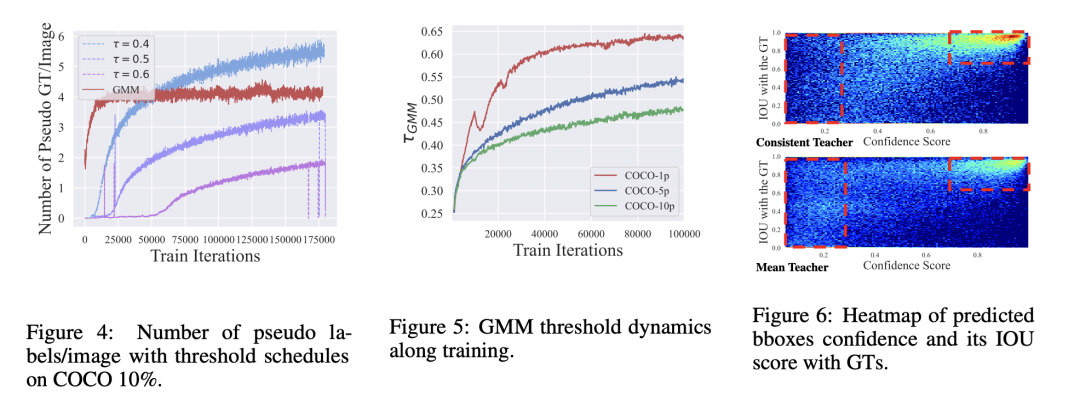

固定閾值篩選偽標簽的方法同樣會導致不一致性。在半監督目標檢測中,為了篩選高質量的偽標簽進行訓練,常常采用一個固定的閾值對分類的置信度進行篩選。然而,這種方法會導致在訓練不同階段的不一致性。

在訓練初期,由于模型對預測結果不夠自信,固定的閾值會導致過少的偽標簽框被篩選,而隨著模型的不斷訓練,每張圖的偽標簽框數量會逐漸增多,直到訓練后期過多。

這種偽標簽框數量的不一致同樣會導致Student網絡訓練的不一致。如上圖(b),不同threshold的Mean-Teacher均會出現“偽標簽框數量隨著訓練逐漸增多”的不一致現象。

Consistent Teacher

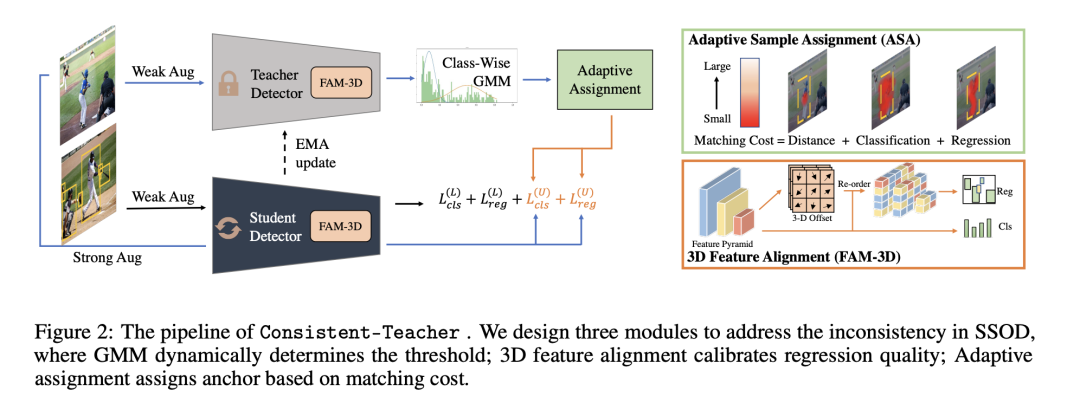

在分析現有半監督目標檢測偽標簽的偏移問題與不穩定性后,本文提出了一種新的半監督目標檢測方法Consistent-Teacher,整體如下圖。

Consistent-Teacher設計了三種模塊來解決上述問題,包括自適應的標簽分配(ASA),3D特征對齊(FAM-3D)和基于高斯混合模型的自適應閾值(GMM-based Threshold)。

Consistent-Teacher包含一個Teacher模型和一個Student模型,其中教師模型的參數是學生模型參數的指數滑動平均(EMA)。

在訓練的每一個iteration,學生模型一方面在有標簽數據上進行有監督訓練;另一方面,教師模型對無標簽數據進行標注,得到偽標簽框,并在對無標簽數據進行了強數據增強后,訓練學生模型。

在這個教師-學生模型的基礎上,本文提出三種模塊來解決上述偽標簽不一致問題。

自適應的標簽分配(ASA)

上文提到靜態anchor分配由于使用IoU閾值分割來分配anchor,略微變化就會導致分配的不同。本文則提出采用自適應的標簽分配 (ASA)。

與靜態anchor分配不同,ASA為每一對anchor-真實值邊界框計算一個匹配損失,然后選擇匹配損失最小的若干對anchor-真實值邊界框作為最終的anchor分配。

3D特征對齊 (FAM-3D)

其次,為了解決上文提到的分類與回歸任務之間存在的不一致問題,本文提出3D特征對齊模塊 (FAM-3D),通過使分類特征自適應地檢索到最佳回歸特征,以執行回歸任務。以此,FAM-3D成功地將分類和回歸特征進行了對齊。

具體而言,FAM-3D在檢測頭中額外增加一個分支,用于預測最優回歸特征位置的偏移量。FAM-3D中的“3D”意味著這個位置偏移量不僅在x和y維度上預測回歸特征的偏移量,同時還預測特征金字塔中進行跨層的偏移量預測。

我們使用計算出偏移量對分類特征進行重排,即可得到與分類特征對齊的最優回歸特征。這個偏移量是通過端到端優化回歸特征位置頭獲得的,而不需要手工標注的監督。

最后模型利用分類特征進行分類,并利用對齊的回歸特征回歸檢測框。

基于高斯混合模型的自適應閾值(GMM-based Threshold)

最后,為了解決硬閾值選擇偽標簽帶來的不一致問題,本文提出使用動態的閾值。它隨著訓練過程中的模型能力變化,調整偽標簽的閾值。

為了動態的調整偽標簽框篩選的閾值,Consistent-Teacher將偽標簽框篩選的過程看作是一個二分類過程,即正樣本類為篩選得到的高質量偽標簽框,負樣本類為要篩除的低質量標簽框。

本文采用高斯混合模型(GMM)對這個二分類進行建模。將正樣本類別和負樣本類別分別看作兩個高斯分布,通過Expectation-Maximum(EM)算法迭代求解高斯混合模型的最優參數,通過高斯混合模型得到分類閾值(區分正樣本和負樣本)。

在訓練中,Consistent-Teacher維持一個class-wise的隊列存儲用于建模GMM的的樣本,并在訓練過程中不斷通過GMM獲得動態更新的閾值進行自適應的篩選樣本。

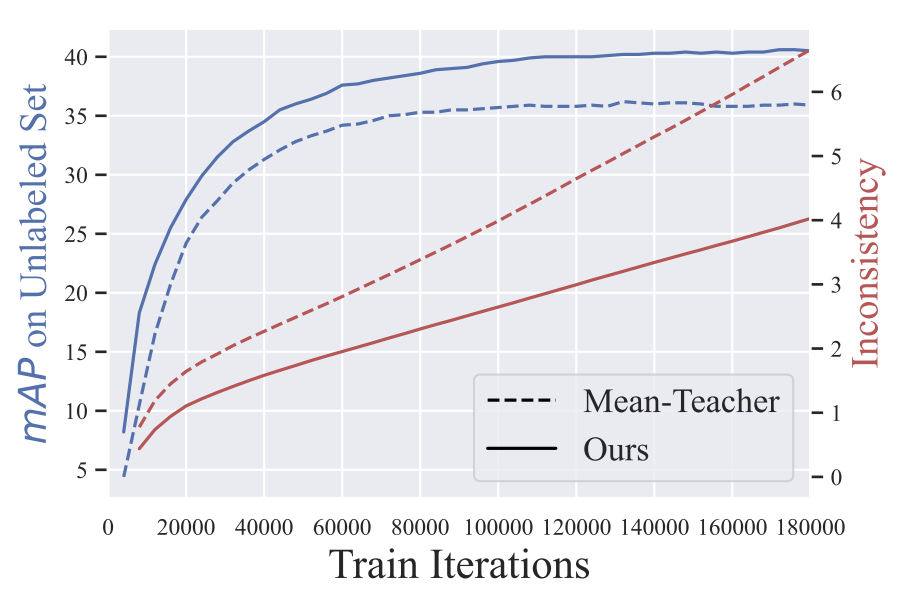

驗證SSOD的不一致性

首先本文畫出了偽標簽的準確性,以及偽標簽一致性隨著訓練不斷進行的變化圖。本文通過偽標簽與真實標簽的mAP來衡量偽標簽的準確性,并通過兩個連續的checkpoint對同一個樣本預測的一致性作為偽標簽的一致性衡量標準。

如下圖,Mean-Teacher的偽標簽不一致性遠高于 Consistent-Teacher ;隨著訓練進行不斷增加,Mean-Teacher的偽標簽的mAP也遠低于Consistent-Teacher。

下左圖和中間的圖顯示,隨著訓練的進行,Mean-Teacher的偽標簽框數量逐漸增多,會導致訓練的不一致性。而本文提出的Consistent-Teacher通過GMM動態的調整并緩慢提高閾值,可以維持不同訓練階段中,偽標簽框數量相對穩定。

在上右圖中,Mean-Teacher預測了很多分類置信讀高但是定位不準確的偽標簽框(左邊紅色框)。而本文提出的Consistent-Teacher預測的大多數是分類置信讀高且定位準確的偽標簽框,這說明本文提出的方法可以很好的對齊分類與回歸的特征并且預測更為準確的偽標簽框。

實驗結果

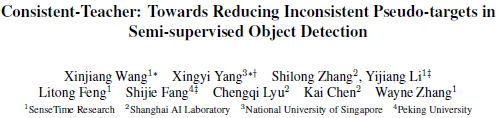

與SOTA的比較

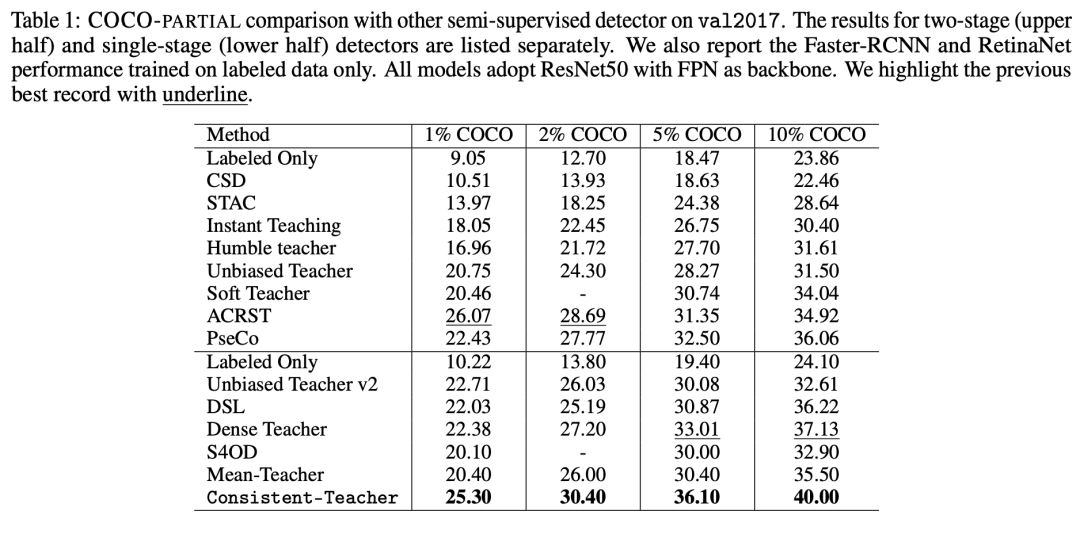

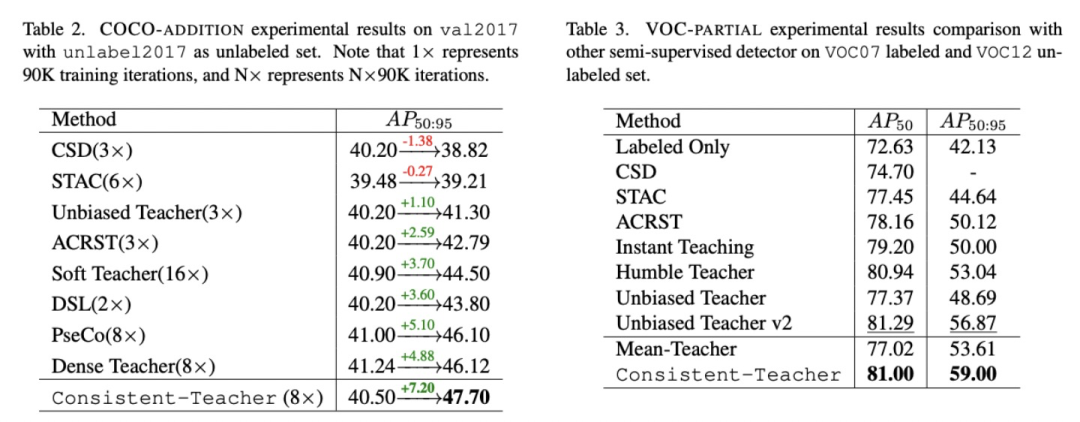

本文在MS-COCO 2017以及PASCAL VOC數據集上進行實驗。

在MS-COCO 2017不同比例的有標簽的數據上,Consistent-Teacher均獲得了遠超SOTA的結果。如下圖可見,Consistent-Teacher在1%、2%、5%以及10%的比例(有標注數據的比例)上分別獲得了25.30、30.40、36.10以及40.00的mAP,這個結果穩定地比之前的SOTA Dense Teacher[3]高出3個mAP。

在COCO-Addition(利用全部的MS-COCO 2017作為有標注數據,并使用額外的COCO未標注數據)上本文同樣獲得了驚人的效果。如下圖Table2,Consistent-Teacher獲得了47.20的超強性能,比SOTA高1個mAP。在VOC的實驗上本文提出的Consistent-Teacher同樣獲得了SOTA的結果。

以上實驗很好地說明,通過解決不一致問題,本文提出的Consistent-Teacher可以有效的提升半監督檢測模型的性能。

消融實驗

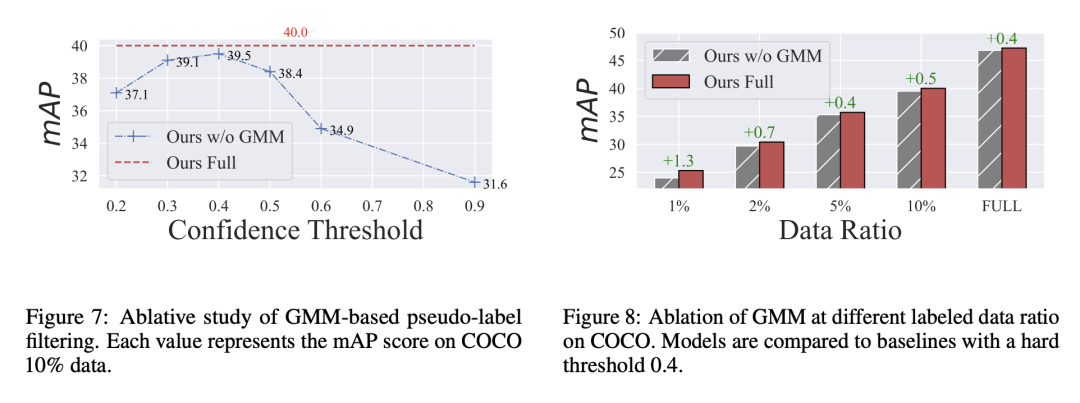

本文進一步進行消融實驗說明本文提出的三個模塊的有效性。

上圖Table 5中可見,FAM-2D可以帶來0.6的提升,而FAM-3D可以進一步帶來0.4個點的提升。

在Figure 7和8中,通過在不同比例的有標簽數據上進行訓練,及對比不同固定閾值的模型,GMM可以帶來穩定的0.5個點的提升。

傳送門

論文地址

https://arxiv.org/abs/2209.01589

Code地址

https://github.com/Adamdad/ConsistentTeacher

項目主頁

https://adamdad.github.io/consistentteacher/

References:

[1] Tarvainen A, Valpola H. Mean teachers are better role models: Weight-averaged consistency targets improve semi-supervised deep learning results[J]. Advances in neural information processing systems, 2017, 30.

[2] Lin T Y, Goyal P, Girshick R, et al. Focal loss for dense object detection[C]//Proceedings of the IEEE international conference on computer vision. 2017: 2980-2988.

[3] Zhou H, Ge Z, Liu S, et al. Dense teacher: Dense pseudo-labels for semi-supervised object detection[C]//Computer Vision–ECCV 2022: 17th European Conference, Tel Aviv, Israel, October 23–27, 2022, Proceedings, Part IX. Cham: Springer Nature Switzerland, 2022: 35-50.

[4] Xu M, Zhang Z, Hu H, et al. End-to-end semi-supervised object detection with soft teacher[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. 2021: 3060-3069.

[5] Jeong J, Lee S, Kim J, et al. Consistency-based semi-supervised learning for object detection[J]. Advances in neural information processing systems, 2019, 32.

[6] Sohn K, Zhang Z, Li C L, et al. A simple semi-supervised learning framework for object detection[J]. arXiv preprint arXiv:2005.04757, 2020.

[7] Liu Y C, Ma C Y, He Z, et al. Unbiased teacher for semi-supervised object detection[J]. arXiv preprint arXiv:2102.09480, 2021.

返回

返回