- 核心技術

- 以原創技術體系為根基,SenseCore商湯AI大裝置為核心基座,布局多領域、多方向前沿研究,

快速打通AI在各個垂直場景中的應用,向行業賦能。

ECCV 2022 Oral | 無需標注!將CLIP直接用于分割

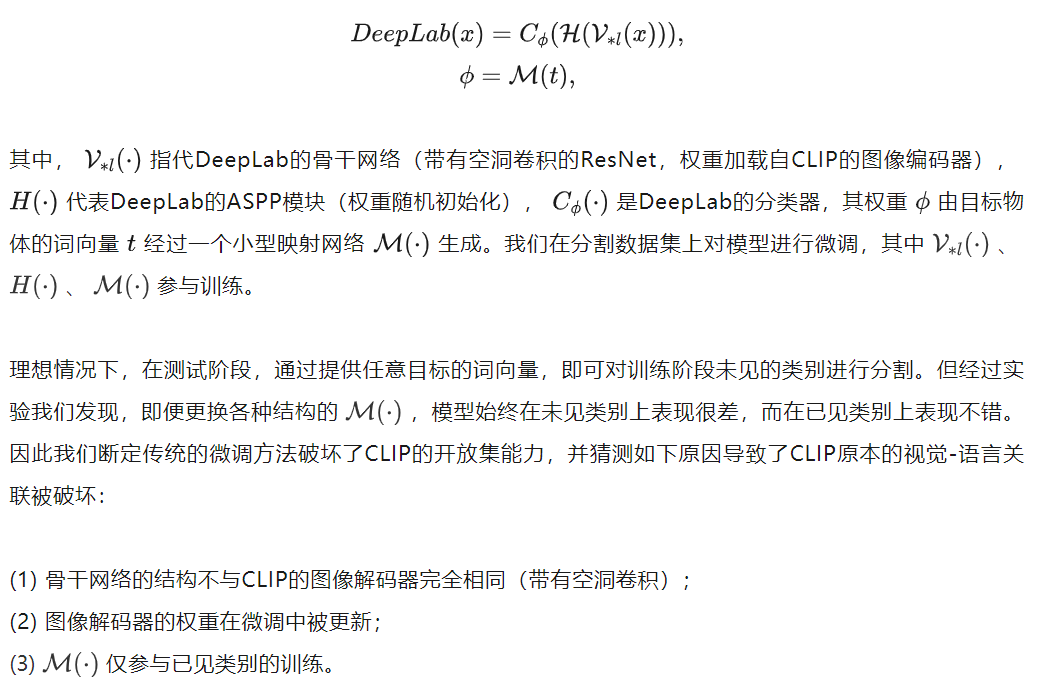

Part 1 傳統的微調方法破壞了CLIP的開放集能力

正如導讀中所提到的,我們發現CLIP在密集預測任務上存在巨大潛力:同時識別多個目標、理解目標間關系、目標不局限于固定詞匯集。因此,我們選定語義分割作為目標任務,對CLIP展開探索。

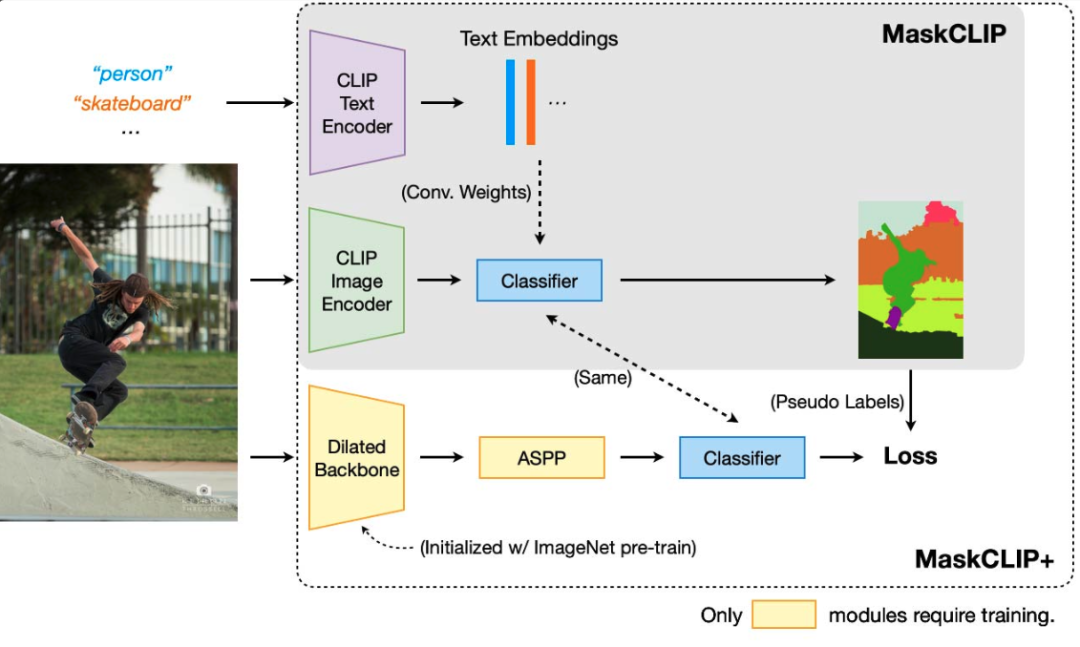

一個自然而簡單的想法就是,將CLIP的圖像編碼器的權重加載到骨干網絡,同時將目標物體的單詞輸入到CLIP的文字編碼器中得到詞向量,并用這些詞向量生成分類器。以DeepLab為例:

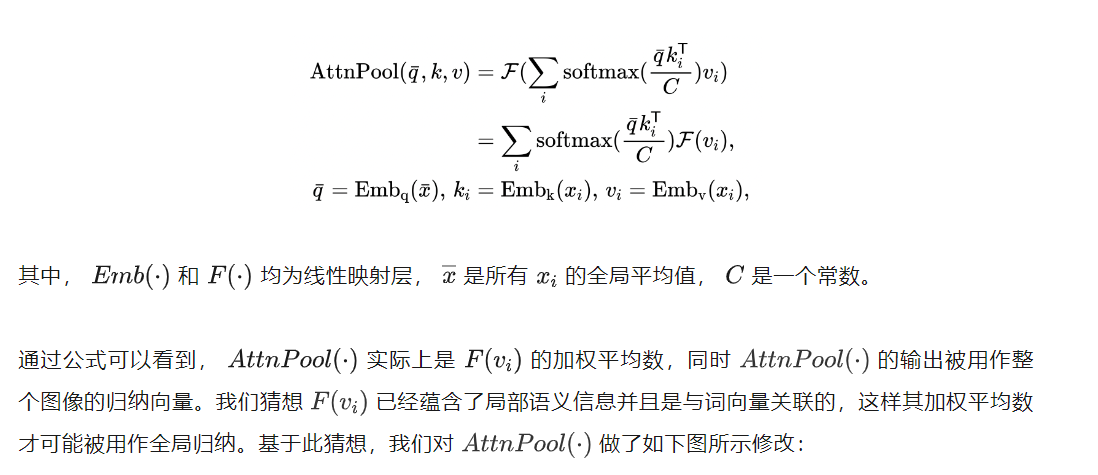

Part 2 無需訓練的MaskCLIP

有了前車之鑒,我們轉而避免引入新的參數并盡量保持CLIP原有的特征空間不變。讓我們重新仔細檢視一下CLIP的圖像編碼器,特別是它獨特的全局注意力池化層(類似于Transformer的注意力層):

Part 3 利用MaskCLIP的預測 作為偽標簽訓練分割模型

雖然MaskCLIP避免了對CLIP進行大幅修改從而保證了視覺-語言關聯的完整性且不需要任何訓練,但是由于CLIP的圖像編碼器并不是為語義分割設計的(例如ResNet的32倍降采樣),大大限制了MaskCLIP的性能。因此我們進而提出MaskCLIP+,如上圖所示,其核心思想為將MaskCLIP的預測用作偽標簽,訓練更適合分割任務的模型(例如DeepLab)。可以預期的是,MaskCLIP+的性能在訓練過程中會超過MaskCLIP,這時再使用MaskCLIP提供監督性能將不會繼續提升。因此,一旦觀察到這種現象,我們在后續的訓練中將使用MaskCLIP+為自己提供偽標簽,即自學習。

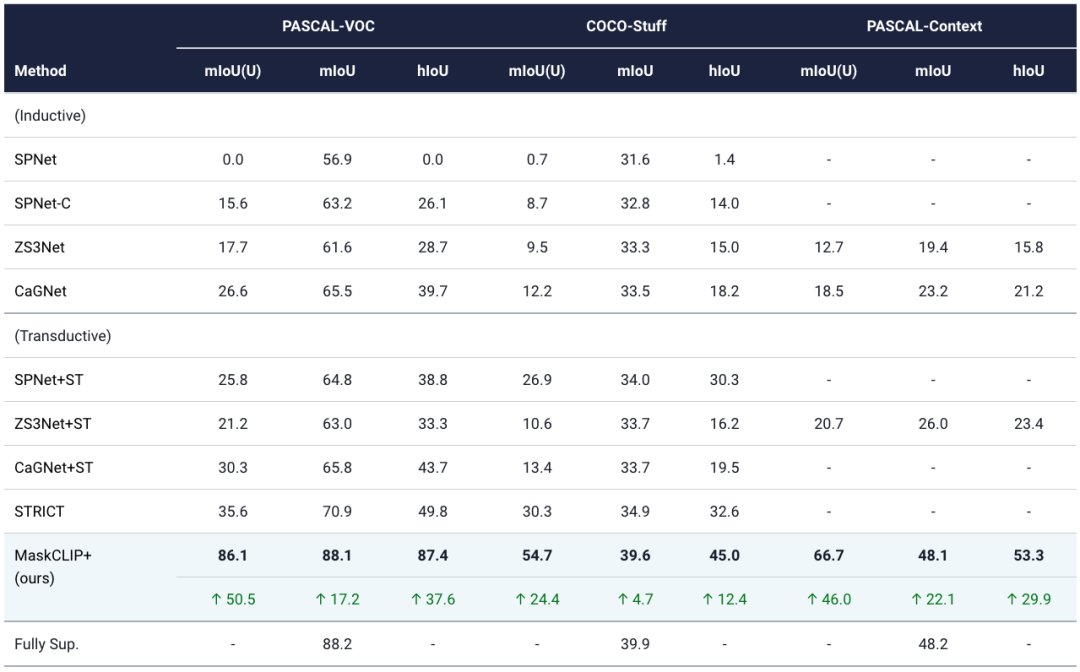

MaskCLIP+可以被自然地用到零樣本語義分割任務上:對于提供標簽的類別使用標簽監督,對于無標簽類別,用MaskCLIP提供的偽標簽監督。因此,我們提供了與現有SOTA的對比,并發現MaskCLIP+遠超現有SOTA,甚至幾乎到達全監督模型的水平。

Part 4 實驗結果

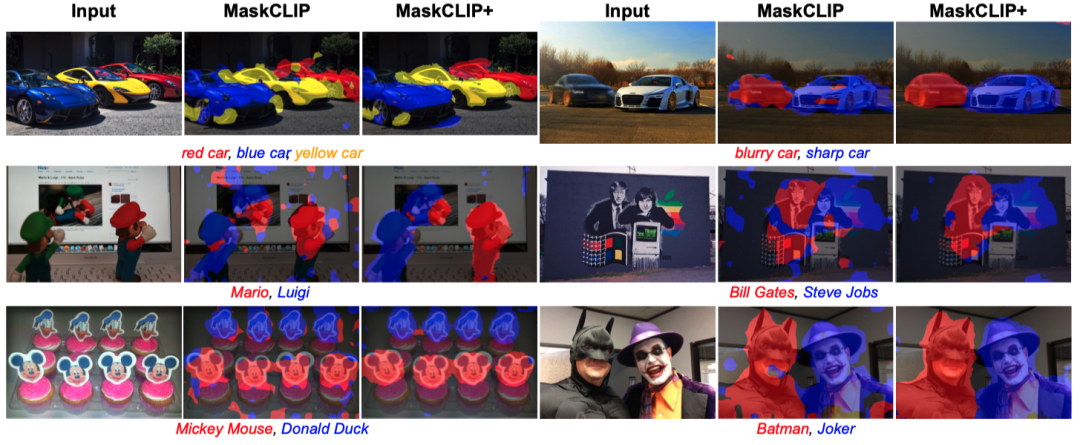

以上測試圖片均來自于網絡。我們在不使用任何標注的情況下,測試了MaskCLIP(+)對于諸如:顏色、模糊度、卡通人物、汽車品牌等目標的分割性能。

我們在這張表格中將MaskCLIP+與現有的零樣本分割SOTA方法在PASCAL VOC、COCO-Stuff、PASCAL Context上進行了對比。ST為Self-Training的縮寫。

相關資料

?項目地址:

https://www.mmlab-ntu.com/project/maskclip

?論文鏈接:

https://arxiv.org/abs/2112.01071

?開源代碼:

https://github.com/chongzhou96/MaskCLIP

返回

返回