- 核心技術

- 以原創技術體系為根基,SenseCore商湯AI大裝置為核心基座,布局多領域、多方向前沿研究,

快速打通AI在各個垂直場景中的應用,向行業賦能。

ICLR 2023 Oral | 探索網絡結構和域泛化能力的關系

01 動機與背景

域泛化是指在一個新的、未知的領域或環境中,一個模型可以在沒有特定的領域或環境知識的情況下進行有效的預測。

域泛化在現實生活中具有很高的應用價值。例如,在醫療診斷中,由于醫療數據難以獲取,模型必須在不同的醫院、城市或國家之間進行泛化,以便有效地進行診斷;在自動駕駛汽車領域,模型必須能夠在各種天氣、路況和道路類型等不同環境下泛化,以實現可靠的自動駕駛。

因此,域泛化是一個重要的研究方向,可以使機器學習模型在更廣泛的實際應用場景中實現更好的性能。

目前,域泛化方法主要可以分為以下幾類:

基于數據增強的方法:該方法通過對訓練數據進行不同的增強操作,如旋轉、平移、縮放等,增加訓練數據的多樣性,以提高模型的泛化能力 基于特征對齊的方法:該方法通過對源域和目標域的特征進行對齊,減小不同域之間的分布差異,以提高模型的泛化能力 基于元學習的方法:該方法通過在訓練過程中學習如何快速適應新的領域,以提高模型的泛化能力 基于集成學習的方法:該方法通過組合多個不同的模型或訓練過程,提高模型的泛化能力

以上所提到的方法各有優劣,其中主要的缺陷包括:

基于數據增強的方法可能會導致過擬合,因為增強操作可能會使模型過度關注一些特定的特征 基于特征對齊的方法需要對源域和目標域的數據進行對齊,但在實際應用中,源域和目標域之間的分布差異可能非常大,導致對齊效果不佳 基于元學習的方法需要大量的元訓練數據,并且可能會導致過擬合,因為元學習的目標是在訓練過程中快速適應新的領域,而不是在整個訓練集上獲得最佳性能 基于集成學習的方法需要組合多個模型或訓練過程,這可能會導致計算成本較高,并且可能需要更多的訓練數據來訓練多個模型

在認識到現在的預適應方法所存在的問題后,我們認為有必要從一個新的角度去思考如何更好地解決這個問題。

最近出現的Vision Transformers在視覺領域的各個任務中逐漸代替了CNN,成為被廣泛采用的網絡結構。因此,我們認為網絡結構和泛化性之間可能存在著密不可分的聯系。

在機器學習中,歸納偏置是指在模型選擇和學習算法中使用的先驗知識和假設,它們可以幫助模型從數據中學習有用的模式,而不僅是記住特定的訓練實例。一個好的歸納偏置可以幫助模型更快地收斂,更準確地泛化到新數據,以及更好地抵抗過擬合。

不同的網絡結構可以提供不同的歸納偏置、不同的能力來表示數據的特征。例如,卷積神經網絡(CNN)在圖像領域的應用中表現出色,是因為CNN結構天生適合處理圖像中的局部性和平移不變性。類似地,循環神經網絡(RNN)適合處理序列數據,因為它們具有自然的時間歸納偏置。

目前已經有一些相關工作提出了理論工具[1,2],用于分析神經網絡結構在解決不同問題時的能力強弱。然而,目前這些分析仍然存在于In-distribution learning problem 中,而我們的問題則更關注于Out-of-distribution learning problem。因此,我們對[1]中提出的algorithmic alignment在DG問題上進行了延伸分析。

02 方法介紹

承接上述分析,我們推測『一個好的網絡結構可能更容易在數據中學習到更適用于域泛化的特征』。接下來我們借助Algorithmic Alignment工具,從這個推測出發,在理論上一步步進行分析。

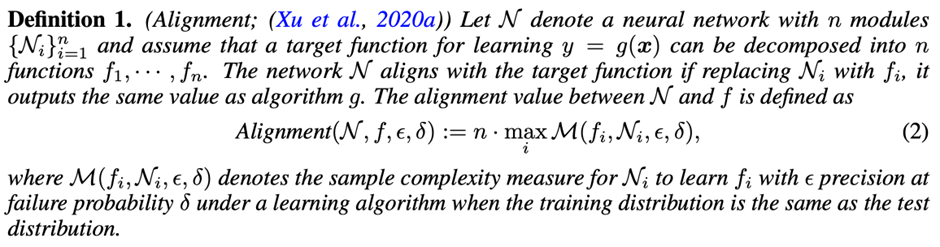

首先我們簡單介紹Algorithmic Alignment,它通過衡量神經網絡結構與目標函數之間的相似性表征獨立同分布(IID)推理任務的易處理程度(Easiness)。

Algorithmic Alignment被正式定義為以下內容。

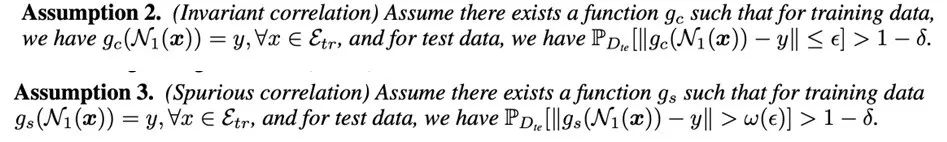

接下來,我們在DG中定義了一些關鍵概念。目標函數是訓練集和測試集之間的不變關系。為了簡單起見,我們假設標簽是無噪聲的。

借助以上的定義,我們可以將算法對齊從獨立同分布泛化(IID generalization)擴展到域泛化(DG)問題上。

Theorem 1 表明,與不變關系對齊的網絡更能夠抵抗分布的變化。我們可以用實驗檢驗,不同類型的網絡的泛化能力強弱。

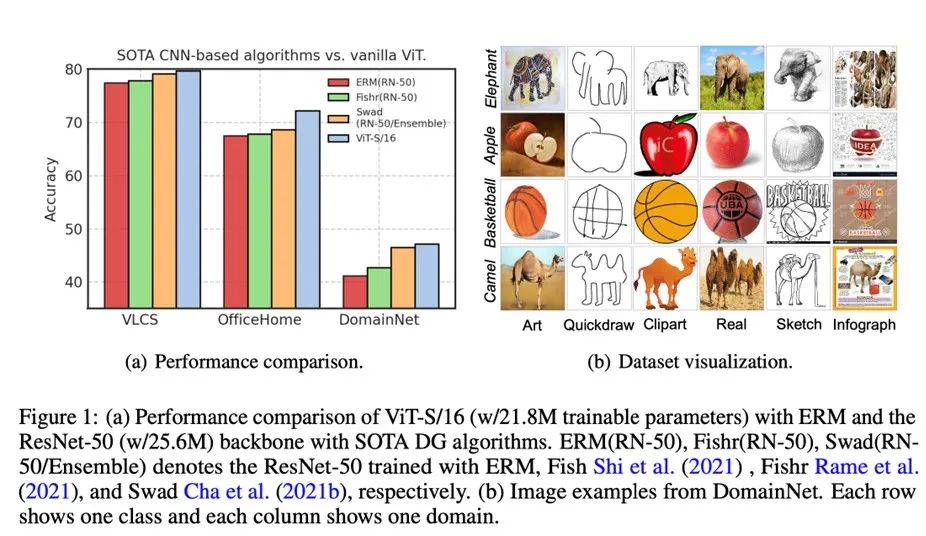

我們在DomainBed上首先測試使用ERM訓練的ViT的性能,結果如圖1(a)所示。令人驚訝的是,在使用了更少參數的情況下,使用ERM訓練的ViT在幾個數據集上已經優于使用SOTA DG算法的ResNet-50。這表明在DG中,選擇骨干網絡結構可能比損失函數更為重要。

我們可以發現,如果神經網絡結構與不變關系(invariant correlation)對齊,ERM足以實現良好的性能。在OfficeHome或DomainNet的某些領域中,形狀屬性與標簽之間存在不變關系,如圖1(b)所示。

相反,屬性紋理和標簽之間存在虛假相關性(spurious correlation)。根據[3]的分析,多頭注意力(MHA)是具有形狀偏置的低通濾波器,而卷積是具有紋理偏置的高通濾波器。因此,僅使用ERM訓練的 ViT就可以勝過使用SOTA DG算法訓練的CNN。

進一步地,我們也很好奇如何提高ViT的泛化能力?Theorem 1建議我們應該利用不變關系的特性。

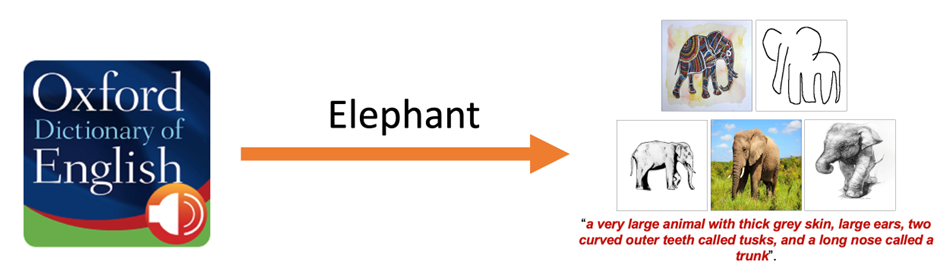

在圖像識別中,一個物體通常由不同部分組成(例如,我們可以用視覺屬性來組合性的描述一個物體[4])。在真實世界的圖像數據中,標簽依賴于多個屬性。對于DG而言,捕捉多樣的視覺屬性特別重要。例如,牛津詞典中對大象的定義是“一種擁有厚厚的灰色皮膚、大耳朵、兩個稱為象牙的彎曲外齒和一個稱為象鼻的長鼻子的大型動物”。

那么,應該如何捕捉這些視覺特征呢?這些視覺特征又是如何決定一個物體的類別的呢?

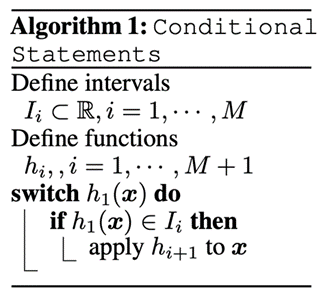

條件語句(即編程中的 IF/ELSE),如算法1所示,在DG問題里,可以被試做根據視覺屬性的組合,在不同域中判斷一個物體的類別的工具。

假設我們在DomainNet上訓練網絡以識別大象,如圖1(b)的第一行所示。對于不同領域的大象,形狀和紋理差異顯著,而視覺屬性(大耳朵、彎曲的牙齒、長鼻子)在所有領域中都是不變的。借助條件語句,對大象的識別可以表述為“如果一只動物有大耳朵、兩個彎曲的外齒和一個長鼻子,那么它就是一只大象”。然后子任務是識別這些視覺屬性,這也需要條件語句。

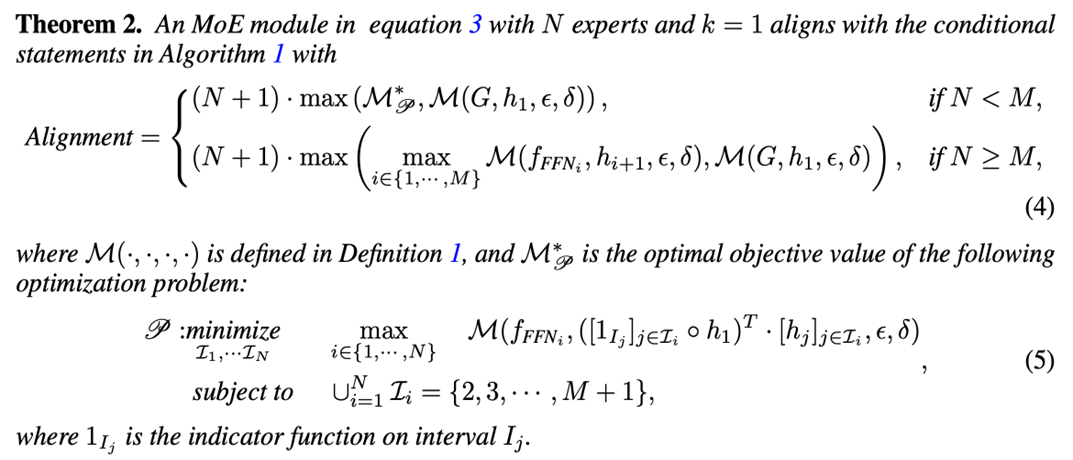

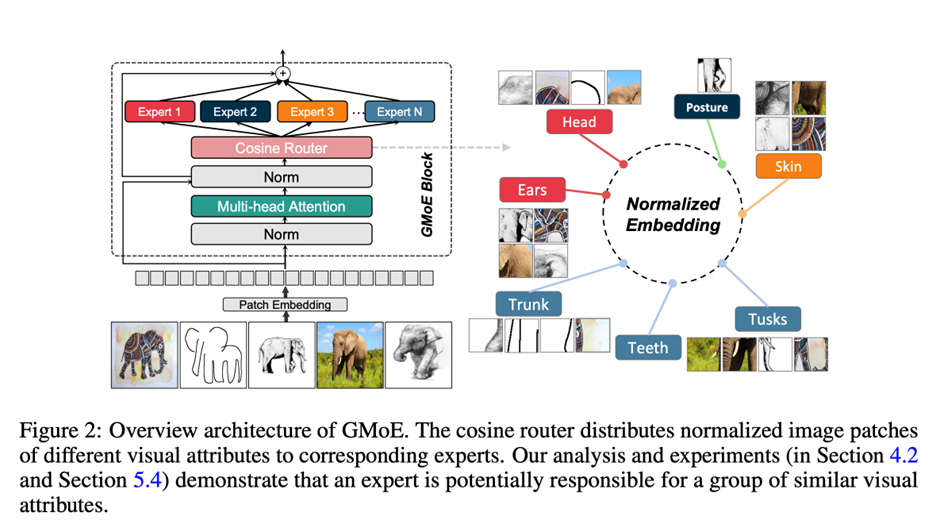

通過Theorem 2,我們證明了一個基于ViT結構的多Experts的Mixture-of-Experts網絡結構,可以很好地在Algorithmic Alignment框架下對齊 IF-ELSE 語句。通過執行IF-ELSE語句,能夠很好地捕捉到一個物體的不同區域的特征(如大象的大耳朵、彎曲的牙齒、長鼻子)。我們也基于前人在 MoE 方向的探索[5,6],提出了我們的Generalizable Mixture-of-Experts (GMoE)。其結構如下:

03 實驗結果

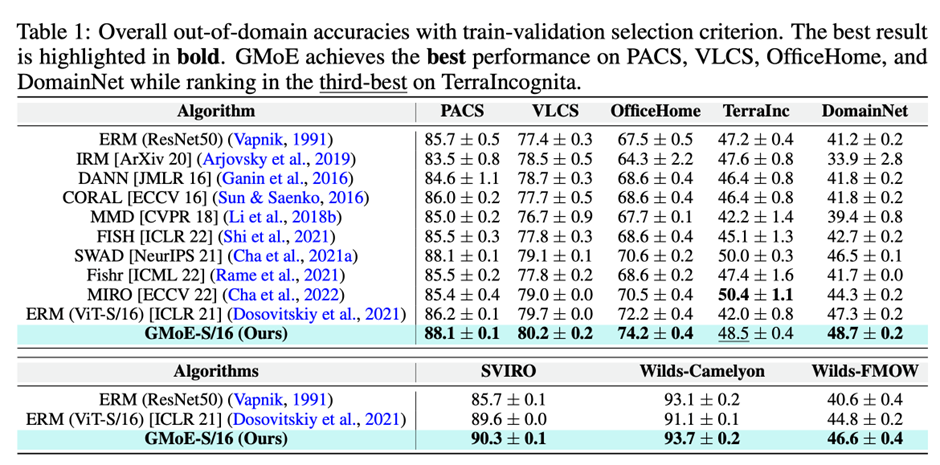

我們在Table 1中提供了train-validation selection的結果,其中包括baselines、最新的SOTA DG方法以及使用ERM訓練的GMoE。

結果表明,GMoE-S/16即使在沒有DG算法的情況下,已經在幾乎所有數據集上表現優于以前基于ResNet-50-S/16的DG方法。

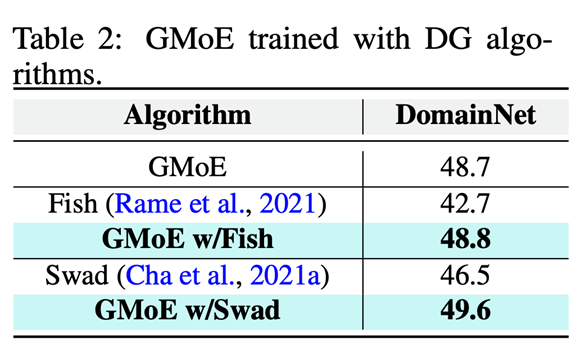

GMoE的泛化能力來自于其內部骨干網絡結構,這與現有的DG算法是正交的。這意味著SOTA DG算法可以應用于改進GMoE的性能。

為了驗證這個想法,我們應用了兩個SOTA DG算法改進GMoE,其中一個是修改損失函數的方法(FISH),另一個是采用模型集成的方法(SWAD)。Table 2的結果表明,采用GMoE,相比于ResNet-50,顯著提高了這些已有DG方法的性能。

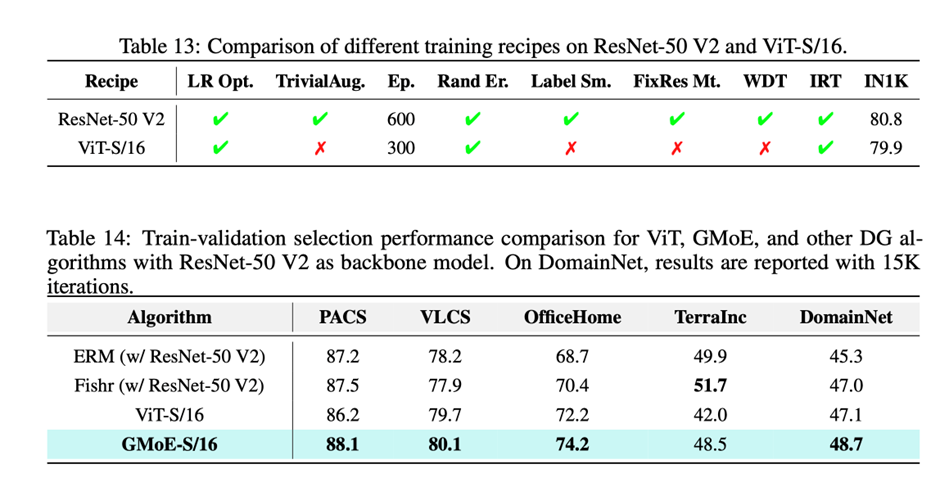

我們同樣在限定了基礎模型結構的IID性能(ViT-S/16和ResNet-50 V2)基礎上,比較這兩個模型的DG性能。以下是對比結果,可以看到 ViT-S/16在略輸ResNet-50 V2的情況下,仍然在DG任務上取得了更好的性能。

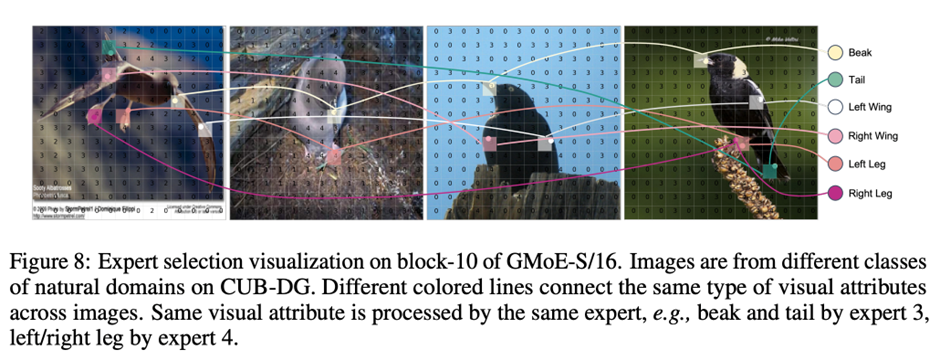

以下是GMoE的Expert Selection可視化結果。圖像來自于CUB-DG中自然領域的不同類別。圖中不同顏色的線連接不同圖像上的同一類別鳥類的視覺屬性(Visual Attributes)。同一視覺屬性由同一Expert處理,例如嘴和尾巴由Expert 3處理,左/右腿由Expert 4處理。

相關資料

Paper

https://openreview.net/forum?id=RecZ9nB9Q4

Github

https://github.com/Luodian/Generalizable-Mixture-of-Experts

Video

https://www.bilibili.com/video/BV1jV4y1C7h8/?spm_id_from=333.999.0.0

References:

[1] Xu, Keyulu, et al. "What can neural networks reason about?." ICLR 2020 (Spotlight)

[2] Xu, Keyulu, et al. "How neural networks extrapolate: From feedforward to graph neural networks." ICLR 2021 (Oral)

[3] Namuk Park and Songkuk Kim. How do vision transformers work? ICLR 2022 (Spotlight)

[4] Object detectors emerge in deep scene cnns. ICLR 2015

[5] Riquelme, Carlos, et al. "Scaling vision with sparse mixture of experts." NeurIPS 2021

[6] Chi, Zewen, et al. "On the representation collapse of sparse mixture of experts." NeurIPS 2022

返回

返回