- 核心技術

- 以原創技術體系為根基,SenseCore商湯AI大裝置為核心基座,布局多領域、多方向前沿研究,

快速打通AI在各個垂直場景中的應用,向行業賦能。

NeurIPS 2023 Spotlight | 面向通用決策場景的MCTS基準框架:LightZero

論文鏈接:https://arxiv.org/abs/2310.08348

代碼地址:https://github.com/opendilab/LightZero

概述

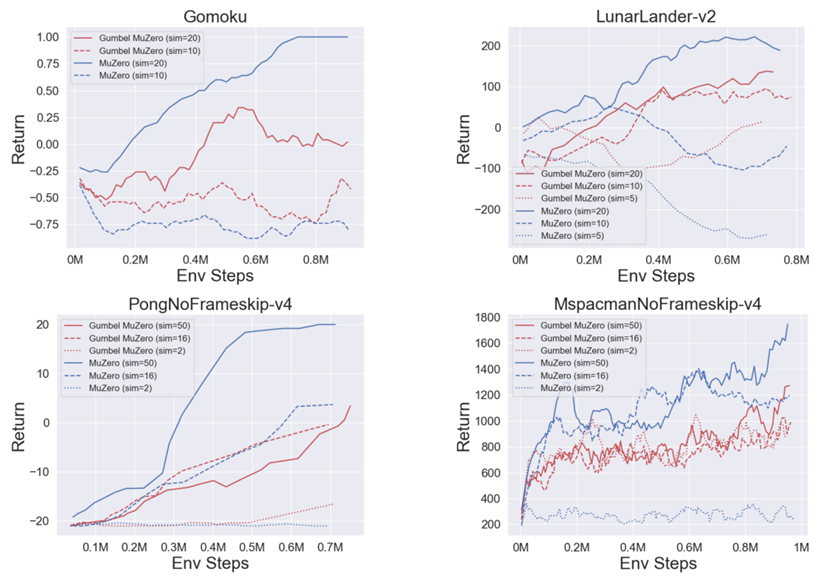

本文將介紹名為LightZero的通用算法Benchmark,它集成了MCTS/MuZero算法的各個衍生分支,涵蓋了9種算法和對超過20種決策環境的實踐評估。LightZero深入分析了MCTS方法的發展歷史和RL環境的多樣性,解讀了開發通用決策算法面臨的六大挑戰性維度。

為了解決由算法與系統架構的高度耦合性引發的各類問題,LightZero設計了一個模塊化的訓練流程,以便靈活地定制和優化各種MCTS系列算法組件。具體地,LightZero將這類方法的訓練方案劃分為四個子模塊:數據收集器(Data collector)、數據整理器(Data arranger)、智能體學習器(Agent learner) 和智能體評估器(Agent evaluator),致力于幫助開發者專注于環境和算法的研究。

另外,基于在框架設計和基準測試中發現的經驗,LightZero進一步探討了將model-based RL的相關最新方法與MCTS方法結合的優勢。例如引入基于self-consistency的自監督訓練方法可以在部分環境上能顯著加速算法收斂性,但不當的使用也會顯著影響另一部分環境的訓練穩定性。最終,詳盡的基準測試和實驗表明,LightZero中整合并構建的最佳算法變體具有極高的數據利用效率和廣泛的應用范圍。

該論文的主要貢獻如下:

1. 推出了LightZero,這是首個系統性評估MCTS/MuZero系列算法的通用Benchmark框架。

2. 詳述了設計通用決策算法時需要面臨的關鍵挑戰,為解決這些問題,LightZero對MCTS算法和系統設計進行了解耦,設計了模塊化的訓練流程,其良好的可擴展性有助于更便捷地設計和集成強大的通用決策智能體。

3. 展示了LightZero中構建的MCTS算法變體可作為一種通用序列決策問題解決方案的強大能力和潛在的未來價值。

這一部分,本文首先會概述講解LightZero,然后深入討論設計通用MCTS算法將會面臨的環境挑戰,并提出模塊化的訓練流程設計方案和高度可擴展的MCTS工具鏈。

Benchmark 簡介

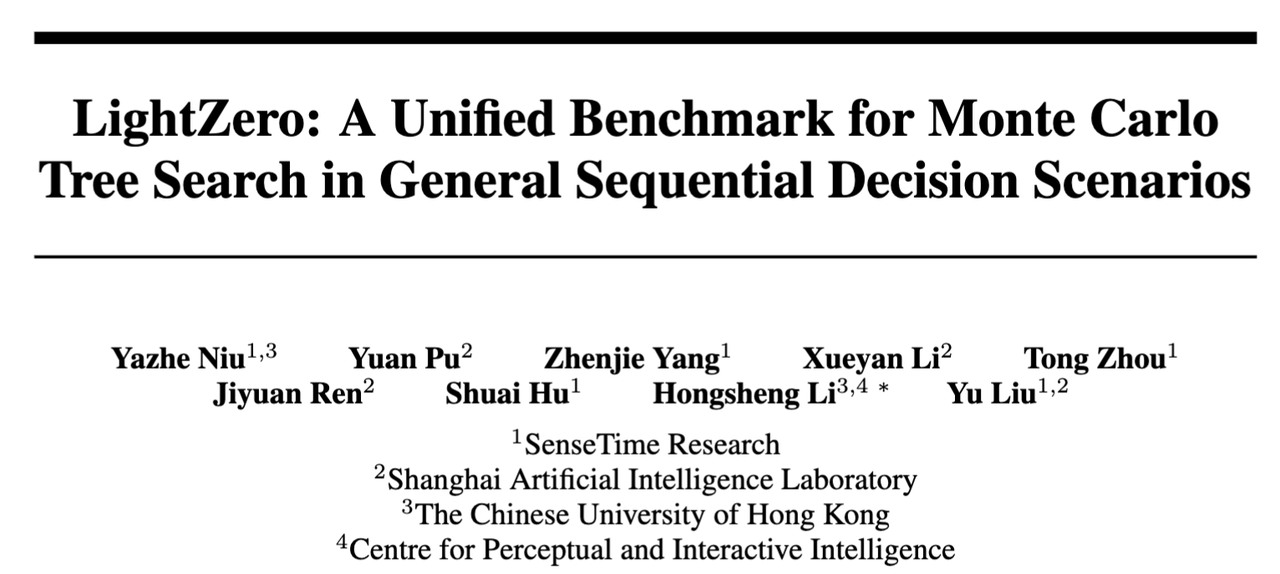

圖1:LightZero 概覽。左側部分描繪了蒙特卡羅樹搜索(MCTS)的發展過程,而右側則展示了各類強化學習(RL)環境。LightZero 融合并拓展了 MCTS/MuZero 子領域的最新研究成果,并將這些成果有效地應用于多種不同的環境中。

如圖1所示,LightZero是首個匯集了MCTS/MuZero領域幾乎全部最新算法進展的Benchmark測試平臺。更準確地說,LightZero匯集了源自AlphaZero/MuZero的9項關鍵算法和超過20種決策環境,為其設計了標準化的訓練和部署接口,以適應多種決策環境的需要。

與原有其他各類定制化算法框架相比,LightZero提供了一種統一的視角和用戶接口。這種統一性使得對比和分析各類技術組合成為可能,為MCTS相關算法和應用的研究提供一個強大且通用的基準平臺。

如何評估一個通用 MCTS 算法:6種環境挑戰

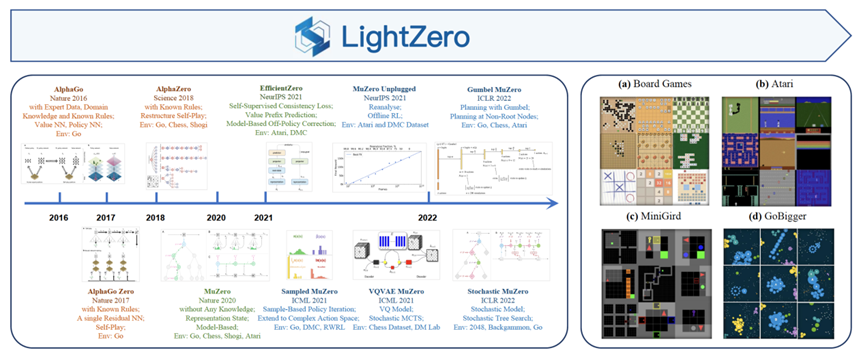

圖2:MCTS+RL方法和model-free RL方法(例如 PPO)在六個環境挑戰及數據效率維度上的定性對比結果。LightZero中將通用決策求解器的關鍵能力進行了分類,包括:多模態觀察空間、復雜動作空間、環境固有隨機性、對先驗知識的依賴程度、仿真成本、探索難度和數據效率。圖中的每條曲線表示一個算法在這六個類別上的評分。評分為1表示該算法在此維度上表現欠佳,只適用于有限場景,而更高的評分則意味著更廣泛的應用范圍和更優的性能。特別地,model-free RL方法不依賴仿真,對先驗知識的依賴度較小,因此在這些領域得分較高。請注意,LightZero在此上下文中指的是在 LightZero 框架內,將各種技術和超參數設置進行最優組合的特殊算法變體。關于定性評分規則的詳細信息,請參見原論文附錄 D。

LightZero對各類RL環境進行了統一的分析,總結出設計通用高效MCTS算法的六個關鍵挑戰(圖2)。具體來說,這六種環境挑戰分別是:

1)多模態觀察空間(Multi-modal observation spaces),需要智能體能夠提取并有效融合不同形式的信息如低維向量、視覺圖像和復雜結構化觀察空間等。

2)復雜動作空間(Complex action space),需要智能體能在生成多樣化決策信號上表現出色,包括離散動作選擇、連續控制和混合結構的動作空間等。

3)依賴先驗知識(Reliance on prior knowledge),這是AlphaZero等方法的一個主要缺點。這些方法本質上需要能夠訪問完美的模擬器和環境的具體規則。相反,MuZero及派生方法通過學習環境模型來替代模擬器和相關先驗,解決了這一限制。

4)環境固有隨機性(Inherent stochasticity)在基于樹搜索的規劃方法中提出了根本性挑戰。環境動力學的不確定性和部分可觀測的狀態空間都可能導致規劃軌跡的錯位,產生大量無用或沖突的搜索結果。

5)模擬成本(Simulation cost)是MCTS-style方法的時間消耗的主要來源。同時,如果算法在模擬過程中未能訪問所有必要的動作,算法的性能會大幅下降。

6)探索困難(Hard exploration)是一個經常被忽視的關鍵挑戰。雖然搜索樹可以通過減少探索范圍來提高效率,但MCTS-style的方法在有大量非終止軌跡(即沒有有效的獎勵信號的軌跡)的環境中容易遇到困難,如迷宮等。

如何簡化一個通用 MCTS 算法:模塊化訓練流程

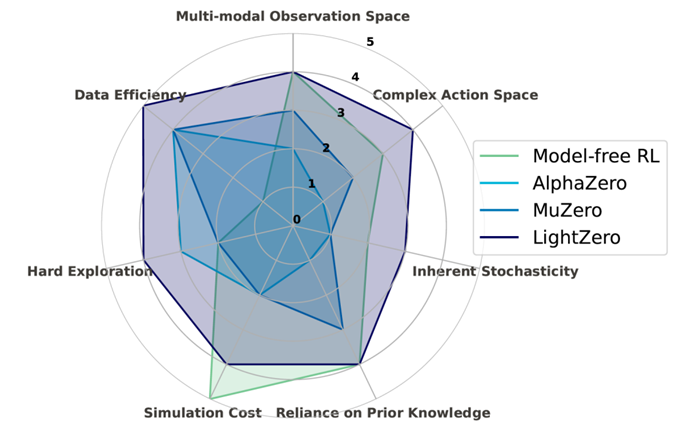

圖3:LightZero訓練流程中的四個核心子模塊。上下文交換器(Context Exchanger)負責在各個子模塊之間傳輸配置、模型和軌跡。

MCTS系列方法雖然表現優秀,但其實現復雜性也相當高,這大大限制了其應用場景。與DQN/PPO等model-free RL算法不同,MCTS方法在每次智能體-環境交互中都需要使用搜索樹進行多步模擬。此外,為了提升訓練數據質量,MuZero Unplugged引入了數據重分析機制,通過使用新模型重新計算舊數據,以獲取改進的訓練目標。然而,這兩種技術都需要多次調用模擬器或神經網絡,增加了分布式訓練和通信拓撲等方面的復雜性。因此,對算法進行集成以簡化整個框架是必要的。

LightZero中設計的訓練流程(如圖3所示)包括四個核心子模塊。

首先,LightZero同時支持online RL和offline RL訓練。兩者的主要區別在于是采用在線交互數據收集器還是直接利用離線數據集。

其次,LightZero對相關訓練流程進行了重構,將其分解為四個核心子模塊,遵循高內聚、低耦合(high cohesion and low coupling)的設計原則。

數據收集器(Data collector)負責利用策略網絡和搜索樹進行有效的動作選擇,同時包括各種探索策略,以及數據預處理和打包操作。 數據整理器(Data arranger)在MCTS中扮演著關鍵角色,它能有效地存儲和準備用于訓練的有價值數據。此模塊涉及到數據重分析技術,用以校正off-policy或離線數據。優先級采樣的改良版確保了訓練的小批量數據具有足夠的多樣性和較高的學習潛能。吞吐量限制器負責控制添加和采樣數據的比例,以在固定的通信帶寬內實現最優的數據利用效果。 智能體學習器(Agent learner)負責多個網絡的訓練,可以利用自監督表征學習,基于模型的rollout,基于值分布的強化學習和價值函數歸一化等優化技術進行增強。這些技術有助于策略的提升,進而提高智能體的整體性能。 智能體評估器(Agent evaluator)提供各類針對強化學習的評價指標以監控訓練過程并評估策略行為。同時,這個模塊集成了一些模型推理時常用的技巧,如beam search,以提升測試性能。

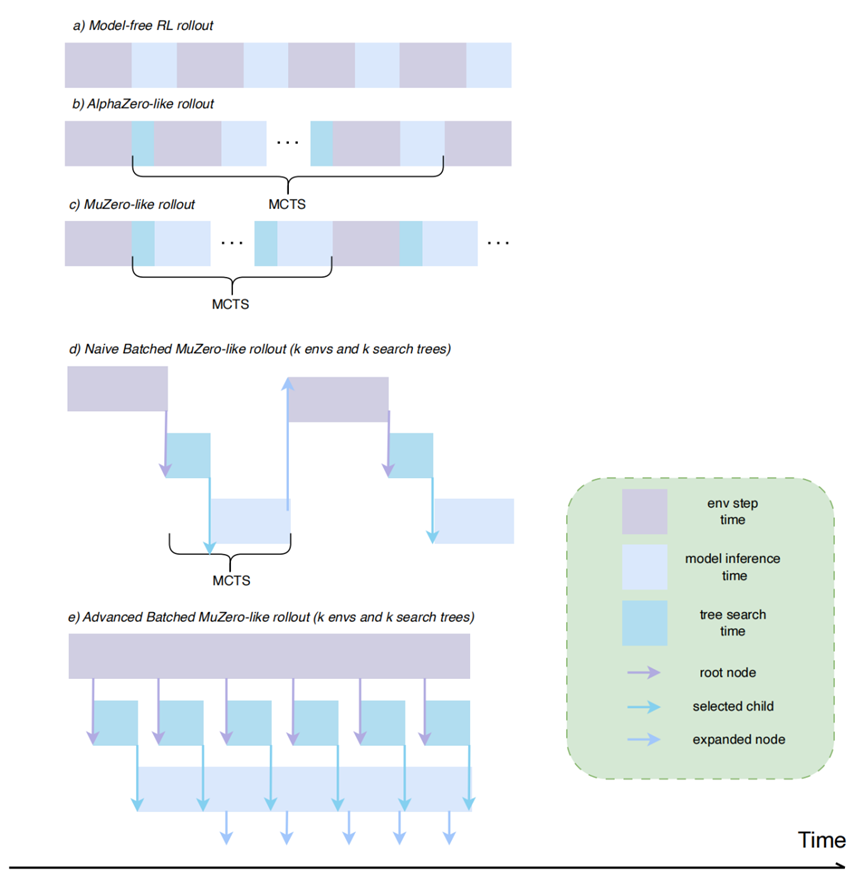

LightZero基于上述設計提供一系列標準接口和工具,讓研究者和工程師能更有效地開發算法或進行系統優化。其中,MCTS的探索策略和世界模型的對齊問題至關重要,將在后續章節詳細探討。對于多向量環境和搜索樹的并行方案也是值得深究的話題,一個簡易的對比示意圖如下所示,具體的數據流和開銷分析請參考原論文附錄 E。

圖4:各種不同決策算法在數據收集時的并行化設計方案對比圖。MCTS 系列算法需要更加深度優化的并行策略。

Benchmark 結果

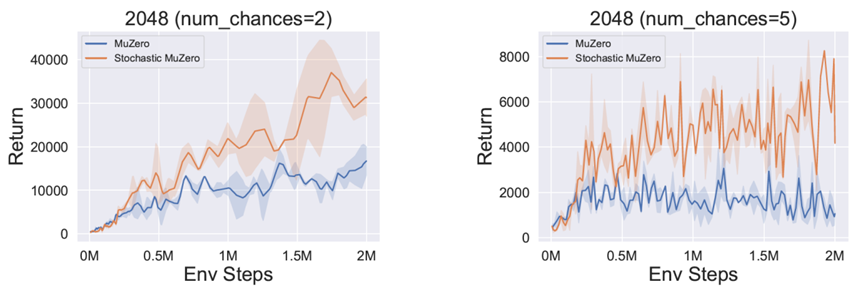

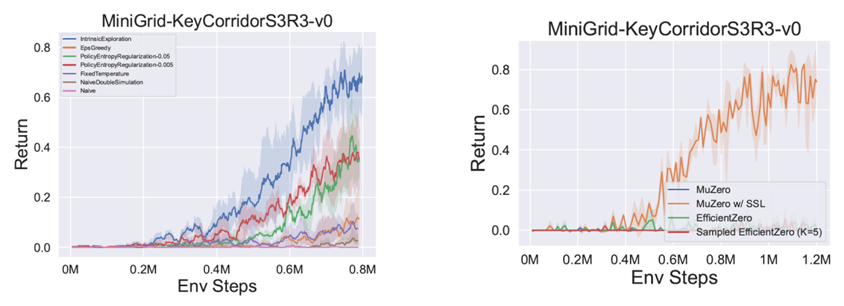

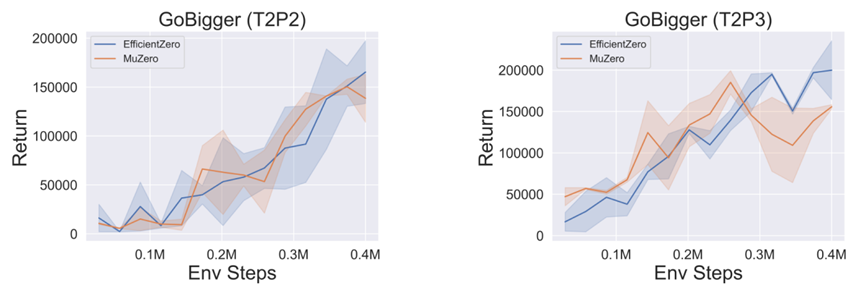

為了測試不同算法之間的性能差異和LightZero中的算法變體作為通用決策求解器的能力,實驗部分在各種強化學習環境中進行了廣泛的對比。一共評估了下面這些算法變體,包括AlphaZero、MuZero、EfficientZero、Sampled MuZero、Stochastic MuZero、Gumbel MuZero和LightZero中綜合改進的算法變體。下面的部分展示了其中一些Benchmark結果作為例子。有關環境和算法的詳細設置,更詳盡全面的 Benchmark結果和相關分析,請參閱論文的附錄 B、C、G。

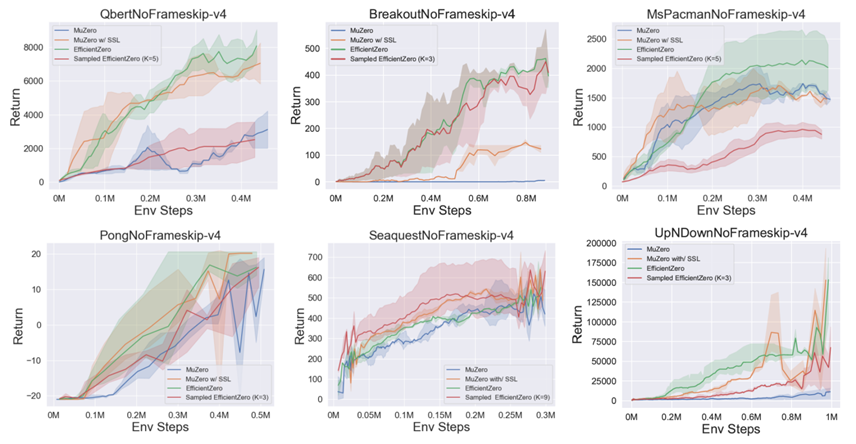

圖5:圖示為在六大代表性Atari 環境下(圖像輸入),LightZero集成的各種算法的性能對比。橫坐標代表環境步驟(Env Steps),縱坐標表示在20個 episode 中的平均收益(Return)。在此上下文中,MuZero w/ SSL代表加入了自監督損失的原始 MuZero 算法。EfficientZero則指通過自監督損失及value_prefix增強的MuZero算法。Sampled EfficientZero則在EfficientZero的基礎上引入了與采樣相關的改進技術。

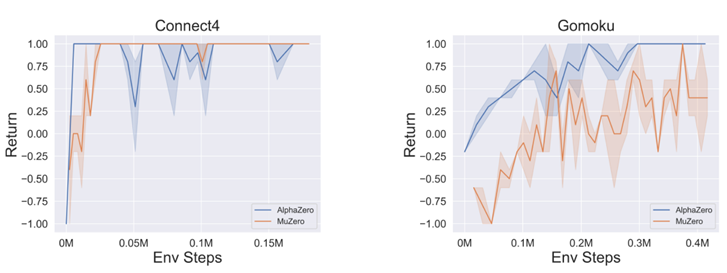

圖6:圖示為AlphaZero與MuZero在Connect4和Gomoku中的性能比較。AlphaZero相比于MuZero表現出顯著的樣本效率優勢,說明在環境模擬器可直接使用時,AlphaZero將有明顯優勢。然而,即便在無模擬器的環境下,MuZero仍可產生相當的結果,這充分體現了其廣泛的適應性。

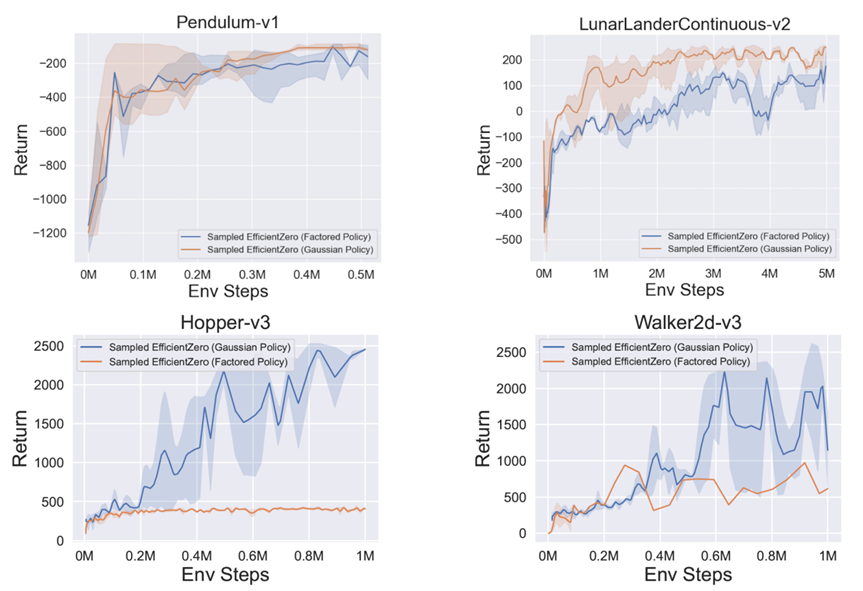

圖7:上部:圖示為Sampled EfficientZero在連續動作空間環境中,采用不同策略建模技術的性能比較。下部:圖示為該算法在MuJoCo連續動作空間環境中,應用各種策略建模方法的性能比較。隨著動作空間尺寸的增加,前者(連續空間離散化版本)表現逐漸下降,而后者表現則相對穩定。

圖8:圖示為在不同模擬成本下,Gumbel MuZero和MuZero的性能比較。在模擬次數有限時,Gumbel MuZero相對于MuZero 表現出顯著的性能優勢,突顯了其在設計低時延MCTS智能體上的潛力。針對Gomoku(棋盤尺寸=6),評估了sim={20, 10};針對LunarLander-v2,評估了sim={20, 10, 5};針對Atari Games,評估了sim={50, 16, 2}。

圖9:圖示為在不同隨機性等級(num_chances=2 和 5)的2048環境中,Stochastic MuZero和MuZero的性能比較。在環境的狀態轉移存在顯著隨機性的環境中,Stochastic MuZero略超MuZero。然而,隨著隨機性等級的升高,Stochastic MuZero的性能也開始受限。

圖10:左圖:圖示為在MiniGrid-KeyCorridorS3R3-v0環境中,不同探索策略的性能比較(收集階段的回報)。利用好奇心機制探索狀態空間的IntrinsicExploration策略表現出較高的樣本效率。右圖:圖示為同樣環境中,LightZero實施的算法的性能比較。在特性為高維向量觀察及稀疏獎勵的環境中,自監督學習損失有助于模型對齊,但預測value_prefix 可能帶來挑戰,對學習造成阻礙。

圖11:圖示為在多智能體對抗和協作環境GoBigger的T2P2和T2P3場景中,MuZero和EfficientZero(均在獨立學習模式下進行訓練)的性能比較。兩種算法在與內置機器人對戰時均能穩定收斂,其樣本效率表現出顯著優勢,相對于其他非 MCTS方法提升了約六倍。

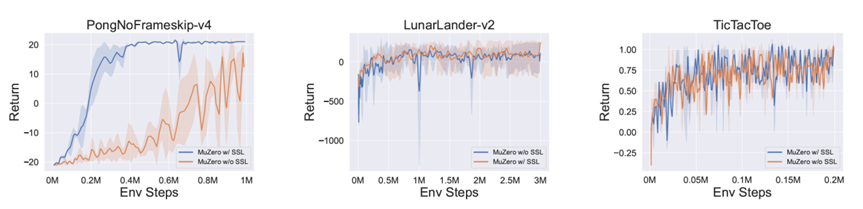

圖12:自監督一致性損失在不同環境中的影響,涉及到各種類型的觀測。從左到右,性能比較涉及到標準圖像輸入、緊湊向量輸入和棋盤圖像輸入,考慮了有和沒有一致性損失的情況。實驗顯示,一致性損失對于標準圖像輸入來說是至關重要的。

關鍵結論和思考

通過對LightZero的統一設計和Benchmark結果的研究,得出了一些關于各種算法優缺點的關鍵結論,這些結論有助于全面理解這些算法的性能和潛在應用。

01:在棋盤游戲環境中,AlphaZero的樣本效率顯著優于MuZero。這表明如果環境模擬器可用,直接使用AlphaZero是最佳推薦方案。然而,即使在沒有模擬器的情況下,在經歷足夠的訓練步數之后MuZero也可以取得滿意的結果。

02:自監督學習損失(SSL)在大多數涉及圖像輸入的Atari環境中顯著提升了性能。如圖5所示,配備SSL的MuZero在 MsPacman環境中與原始的MuZero表現相對等,但在其他五個環境中則超越了MuZero。這一結果突顯了SSL在提高世界模型對齊能力和加速圖像輸入環境學習過程中的重要作用。

03:選擇預測value_prefix而不是reward并不能始終保證性能的提升。例如,在圖5中,EfficientZero僅在MsPacman和Breakout環境中超過了配備SSL的MuZero,而在其他環境中的表現與其相當。更具體地說,如圖12所示,在稀疏獎勵環境中,EfficientZero的性能顯著低于配備SSL的MuZero。因此,在決定是否預測 value_prefix時,應充分考慮環境的獎勵函數特性。

04:在大多數Atari環境和具有復雜結構化觀察空間的環境中(如GoBigger),配備SSL的MuZero和 EfficientZero的表現相當。這一觀察結果表明,具有復雜結構觀察的環境可以從表征學習和對比學習技術中受益,從而提高樣本效率和魯棒性。

05:在離散動作空間中,Sampled EfficientZero的表現與動作空間維度密切相關。例如,Sampled EfficientZero在Breakout(動作空間維度為4)中的表現與EfficientZero相當,但在MsPacman(維度為9)中的表現則有所下降。

06:配備高斯策略表示的Sampled EfficientZero 在連續動作空間中表現出更好的可擴展性。高斯版本在傳統連續控制和MuJoCo環境中表現優異,而離散化版本則僅適用于較低維的連續動作空間。

07:當模擬次數有限時,Gumbel MuZero明顯優于MuZero,這揭示了其在設計低時間成本的蒙特卡洛樹搜索(MCTS)智能體方面的潛力。

08:在具有隨機狀態轉換或部分可觀察狀態的環境中(如沒有疊幀的Atari),Stochastic MuZero可以實現比MuZero更優秀的性能。

09:有關MCTS系列算法提出的改進技術,如 EfficientZero中的自監督損失,Sampled MuZero中的采樣技術,Gumbel MuZero中利用MCTS搜索信息的計算改進,以及Stochastic MuZero中的環境隨機性建模,這些方法都可以看作是相互正交的,之間的干擾非常小。LightZero正在持續探索如何將這些技巧高效且插件化地集成在一起,以設計出通用的決策算法。

10: 如圖12所示,對于標準圖像輸入,一致性損失顯得至關重要。如果無視一致性損失,模型性能會顯著下滑,這揭示了學習針對高維輸入的動態模型的挑戰性。然而,對于LunarLander這樣的向量輸入環境,一致性損失只提供了輕微的優勢,這暗示在緊湊的向量觀測上實施dynamic model學習相對較為簡單。在特定的二維輸入環境,如井字游戲(TicTacToe),一致性損失依然較大,凸顯出在潛在狀態輸出間實現一致性的難度。此外,如果在一致性損失中使用不適當的超參數,可能會導致訓練無法收斂。綜合來看,LightZero中的實驗表明,一致性損失的有效性高度依賴于特定的觀察屬性。對于棋盤游戲,未來的研究方向應考慮探索適當的損失函數,以確保訓練過程中的對齊性。

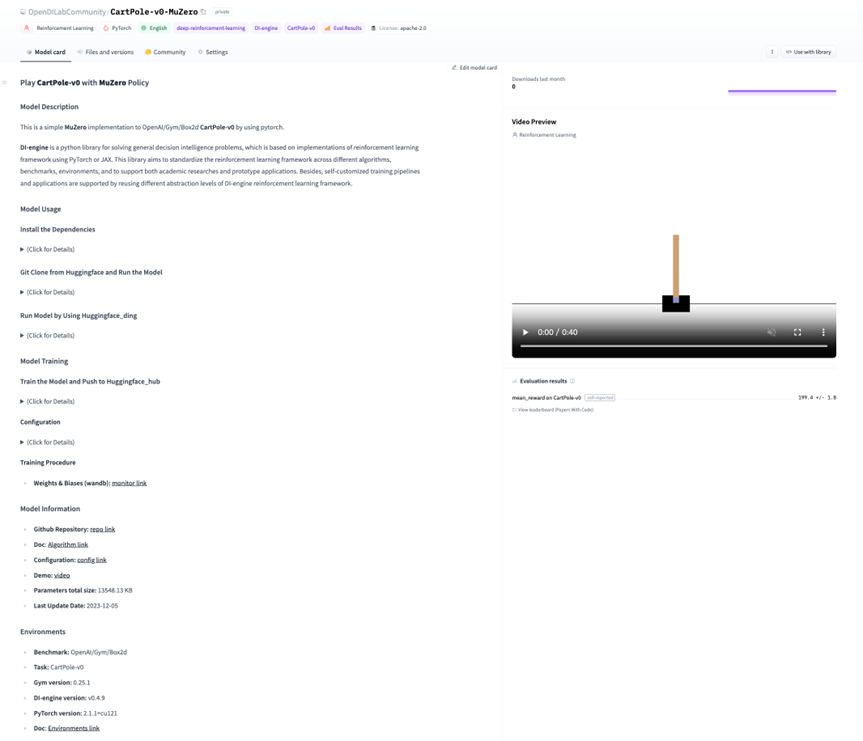

Hugging Face Model Zoo for LightZero

另外,為了進一步拓展決策智能算法和模型的應用范圍,LightZero項目也已經在Hugging Face Model Zoo 中設立了專門的模型空間:Hugging Face Model Zoo for LightZero。這個專門為LightZero打造的模型庫集合,旨在為研究者和開發者提供一個共享、交流研究成果,并進行快速接入和實驗的模型平臺,其中包含了最前沿MCTS系列算法模型,并針對特定應用場景進行優化。致力于讓研究者能在一個標準化的環境下快速復現、測試最新的基于MCTS的決策智能算法,并進行深度的比較和評估。

Hugging Face Model Zoo for LightZero空間:

https://huggingface.co/OpenDILabCommunity

特色功能和資源

預訓練模型:提供一系列預訓練好的LightZero模型,覆蓋了從基礎到高級的各種算法變體,可以直接被快速下載和部署。

配置管理:每個模型都提供了詳細的配置文件,包括了環境設置、網絡架構和訓練參數等,確保了實驗的可重復性。

訓練和評估工具:集成了便捷的訓練和評估接口,研究者可以輕松地在自己的數據集上訓練模型,或在標準測試集上評估模型的性能。

文檔和教程:提供了豐富的文檔資源和教程,幫助用戶理解和使用這些模型,無論是新手還是有經驗的研究者都能快速上手。

社區支持:通過與Hugging Face社區的緊密合作,用戶可以獲取到最新的相關資訊,參與社區討論,或直接向模型庫貢獻自己的模型。

Model Card 與使用示例

圖13:Hugging Face Model Zoo for LightZero 中一個典型示例CartPole-v0-MuZero 的Model Card界面。包含了模型描述、模型使用、模型信息、環境、評估渲染視頻等5大部分。

圖13:Hugging Face Model Zoo for LightZero 中一個典型示例CartPole-v0-MuZero 的Model Card界面。包含了模型描述、模型使用、模型信息、環境、評估渲染視頻等5大部分。

總結與未來工作

LightZero是一個模塊化整合了各種MCTS相關強化學習方法的統一算法基準框架。LightZero系統性地剖析并應對了將MCTS作為通用且高效決策求解器部署過程中的挑戰和機遇。通過模塊化的系統設計、詳盡全面的基準測試,揭示了LightZero作為一個可擴展、高效的決策問題工具對于研究社區的巨大潛力。

盡管LightZero展示了其變體算法在各類基準測試環境中的出色性能,但某些局限性仍需被關注。首先,盡管這種模塊化的設計顯著增強了MCTS系列算法的通用性和擴展性,但對于某些特定的決策環境仍需要部分定制化的調整。其次,由于MCTS算法的內在限制,在處理某些復雜(尤其是隨機性強)的環境時可能遇到挑戰。最后,MCTS的高技術門檻可能會給初次接觸相關技術的人帶來困擾。未來的改進將會關注提高 LightZero框架接口的易用性,豐富相關的文檔和例子,并構建一個的活躍用戶生態社區。

盡管存在上述挑戰,但對于未來MCTS系列算法技術的發展,仍充滿無限可能,這里列出了一些未來的擴展方向:

擴大應用領域:期望更多的研究者和開發者將LightZero應用于更廣泛的實踐領域,包括但不限于自然語言處理,自動駕駛,以及復雜系統的控制和優化。

算法優化:歡迎社區貢獻新的探索和優化策略,以進一步提升MCTS系列算法的運行效率以減小墻鐘時間開銷。

與其他前沿技術的整合:MCTS系列算法和其他機器學習前沿方向的仍然結合十分重要。其中最值得關注的兩個領域是:MCTS與大型語言模型(LLM)的結合,如何學習更強大的世界模型來使用MCTS進行規劃。

返回

返回