CVPR 2020 | HFE: 多層級的特征構建方式解讀

導讀:在CVPR 2020上,商湯城市計算團隊提出了一個針對屬性分類的多層次特征的構建方式,即利用身份(ID)信息輔助構建多層次的特征,該工作為特征構建方式提供了新的思路。相比于已有的屬性分類方法,HFE在特征表示和性能指標上均有顯著優勢。

動機

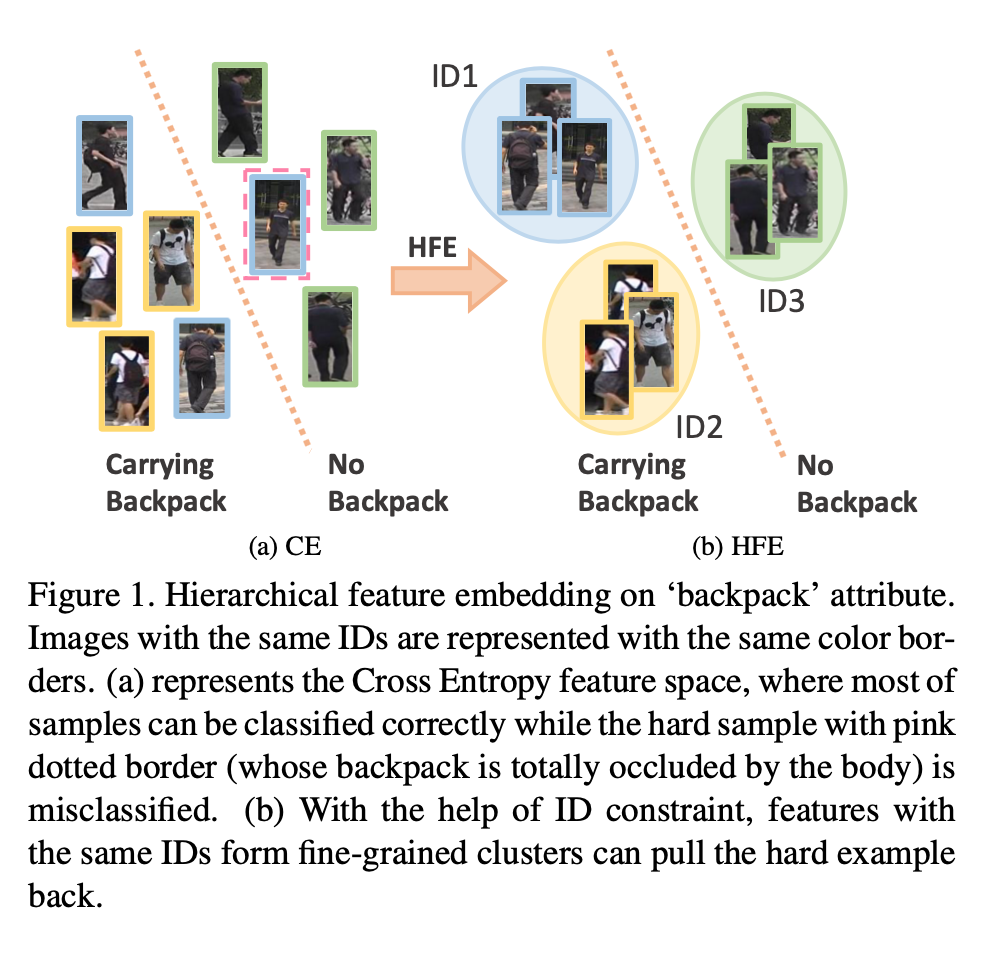

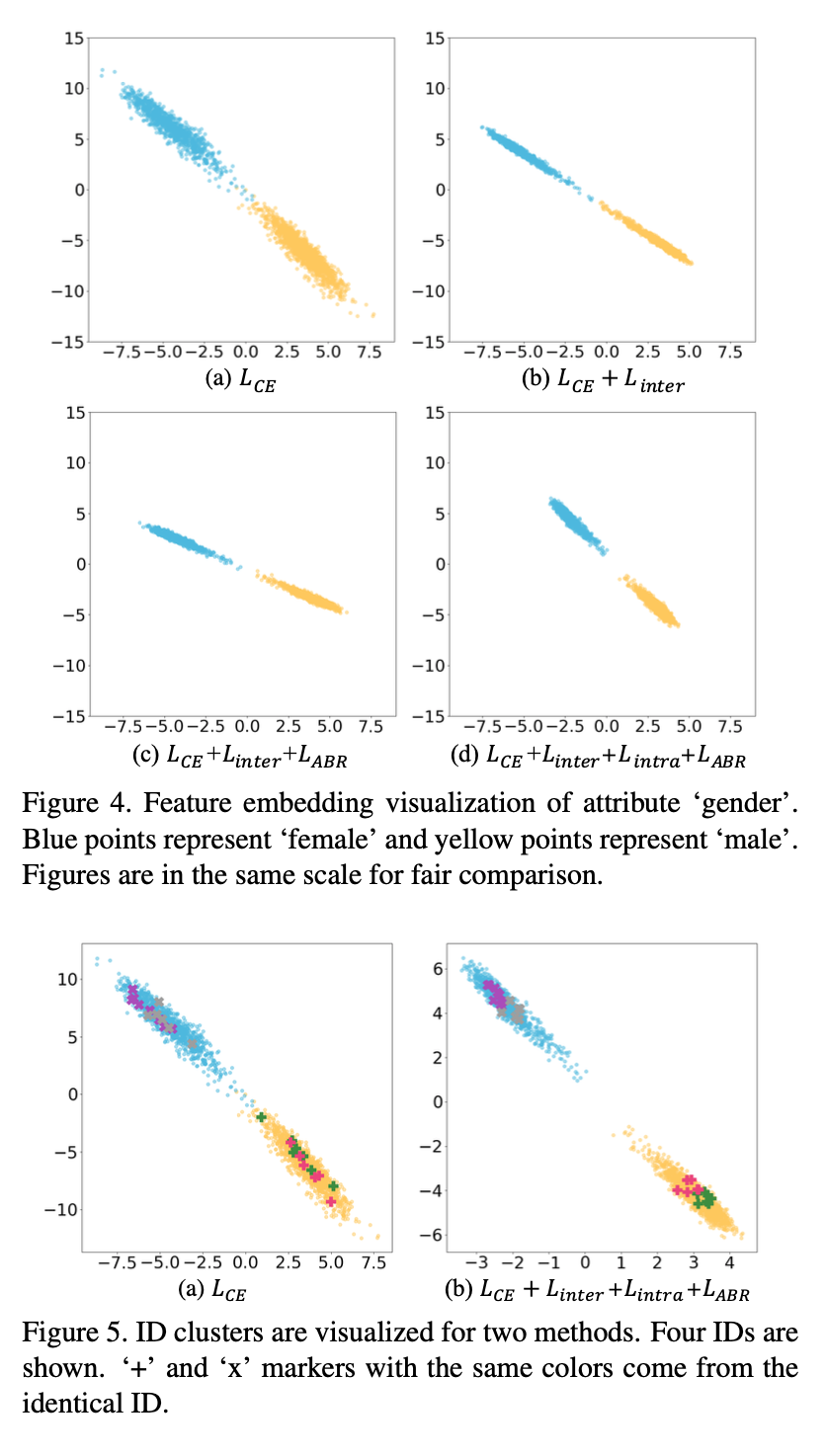

直接使用Cross Entropy Loss訓練的卷積神經網絡分類,只是把同一類的特征聚攏到一起,對于類內沒有約束。我們在帶有ID信息的屬性數據集上進行實驗,只使用屬性標簽進行分類時,發現類內分布非常雜亂,同一個ID的圖片會分散在類內的各個位置。這說明只使用屬性標簽訓練的分類網絡,無法正確的將 ID 相同的圖片在特征空間上映射到足夠近的距離,因此其特征表達不夠穩定,容易受到場景變化等因素的干擾,在輸入發生變化時,特征會發生比較大的偏移,增加了分類錯誤的可能性。我們的方法在此處做出改進,使用ID和屬性標簽作為兩個層級的監督,在特征空間里構建多層級的邏輯結構,以提高模型的表征能力。

該工作的研究動機在于:

1. 利用身份信息來限制同一個人的不同場景、不同角度、不同姿態的樣本特征聚集地更緊密,使特征對于場景、角度、姿態等的變化更魯棒。

2. 通過身份的限制,屬于同一個ID的簡單樣本可以把本來難學的困難樣本在特征空間上拉近,從而使困難樣本更容易學習。

3. 利用身份的信息來構造層次性的屬性特征空間,避免把兩種特征簡單地嵌入到同一特征空間,而是統一到屬性的特征空間,使構造的特征空間更合理。

如下圖所示:

方法設計

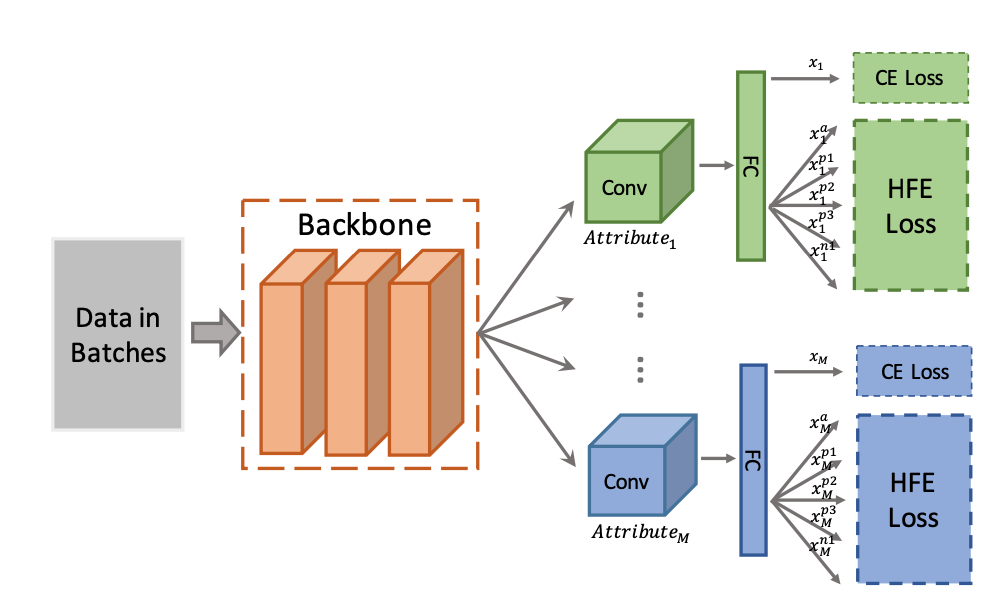

我們提的方法整體框架如下圖,主要由一個骨干網絡,加多個屬性分支組成。共享的骨干網絡用來學習所有屬性的共同特征,而每個單獨的屬性分支用來學習各個屬性各自的特征。

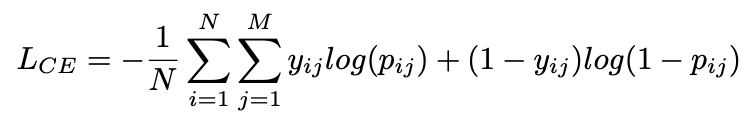

對于損失函數,首先我們沿用傳統的方法,采用交叉熵(Cross Entropy, CE)損失函數進行屬性分類。

這里N代表圖片樣本個數,M代表屬性個數,![]() 代表第i個樣本的第j個屬性的標簽,

代表第i個樣本的第j個屬性的標簽,![]() 代表對第i個樣本第j個屬性的預測概率。

代表對第i個樣本第j個屬性的預測概率。

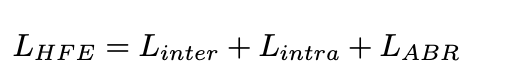

在CE基礎上結合我們設計的多層次特征損失函數,總的損失函數可以寫成如下所示。這里w表示權重。

![]()

一. 多層次特征損失函數

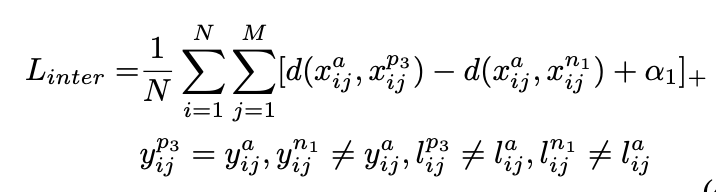

多層次特征損失函數主要由兩個三元組組成,一個是傳統的類間三元組如下。

其中![]() 表示樣本i的j屬性的特征,稱為錨樣本。

表示樣本i的j屬性的特征,稱為錨樣本。![]() 表示和錨樣本

表示和錨樣本![]() 同屬一個屬性類別但離錨樣本最遠的正樣本的特征。

同屬一個屬性類別但離錨樣本最遠的正樣本的特征。![]() 表示和錨樣本

表示和錨樣本![]() 不屬于同一個屬性類別但離錨樣本最近的負樣本的特征。

不屬于同一個屬性類別但離錨樣本最近的負樣本的特征。![]() 表示類間差額,

表示類間差額,![]() 表示樣本i的身份,而d()表示兩個樣本的距離。

表示樣本i的身份,而d()表示兩個樣本的距離。

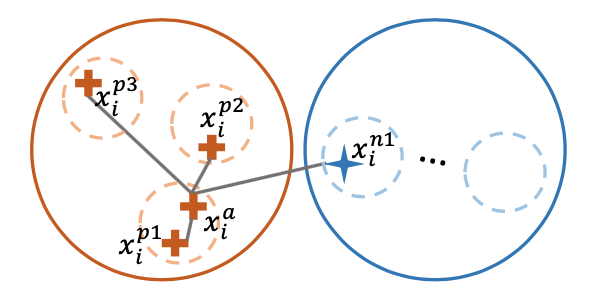

為了形成細粒度的多層次的特征空間,我們利用身份信息構建類內三元組,如下。

這里![]() 表示和錨樣本

表示和錨樣本![]() 同屬于一個屬性類別也同屬于一個身份的離錨樣本最遠的正樣本的特征。

同屬于一個屬性類別也同屬于一個身份的離錨樣本最遠的正樣本的特征。![]() 表示和錨樣本

表示和錨樣本![]() 同屬一個屬性類別但不屬于同一個身份的離錨樣本最近的正樣本的特征。

同屬一個屬性類別但不屬于同一個身份的離錨樣本最近的正樣本的特征。![]() 表示類內差額。

表示類內差額。

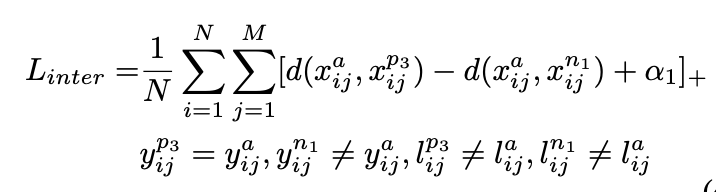

結合上述的兩個loss,我們可以同時維護類間和類內的特征空間。如下圖所示,通過五元組的限制,我們可以維護一個多層級的相對距離,從而達到構建層次化的特征空間的目的。

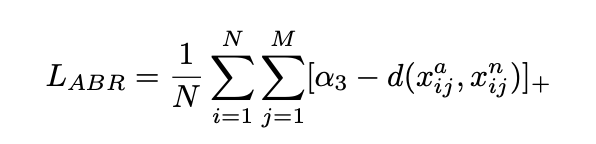

二. 絕對邊界正則項

上述的損失函數雖然能同時維護類間特征和類內特征,但是只考慮了相對距離。從絕對距離角度上看,并不能保證在整個訓練集中,錨樣本和正樣本的距離都小于錨樣本和負樣本的距離。為此,我們設計了絕對邊界正則項(Absolute Boundary Regularization,ABR)如下:

因此我們的多層次特征損失函數由上述三項組成。

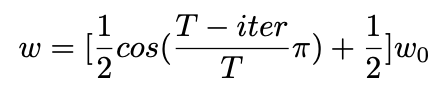

三. 動態權重

在訓練初始的時候得到的特征空間并不可靠,由于五元組的選擇依賴于特征空間,如果一開始就用較大的權重,可能會帶來噪音。所以我們為上述損失函數設計了一個動態權重,通過權重動態增大,使特征空間慢慢地從原始的狀態轉向層次化的狀態。

這里T表示整個訓練的迭代次數,而iter表示當前的迭代次數。w0是一個預先設置好的常數。

實驗結果

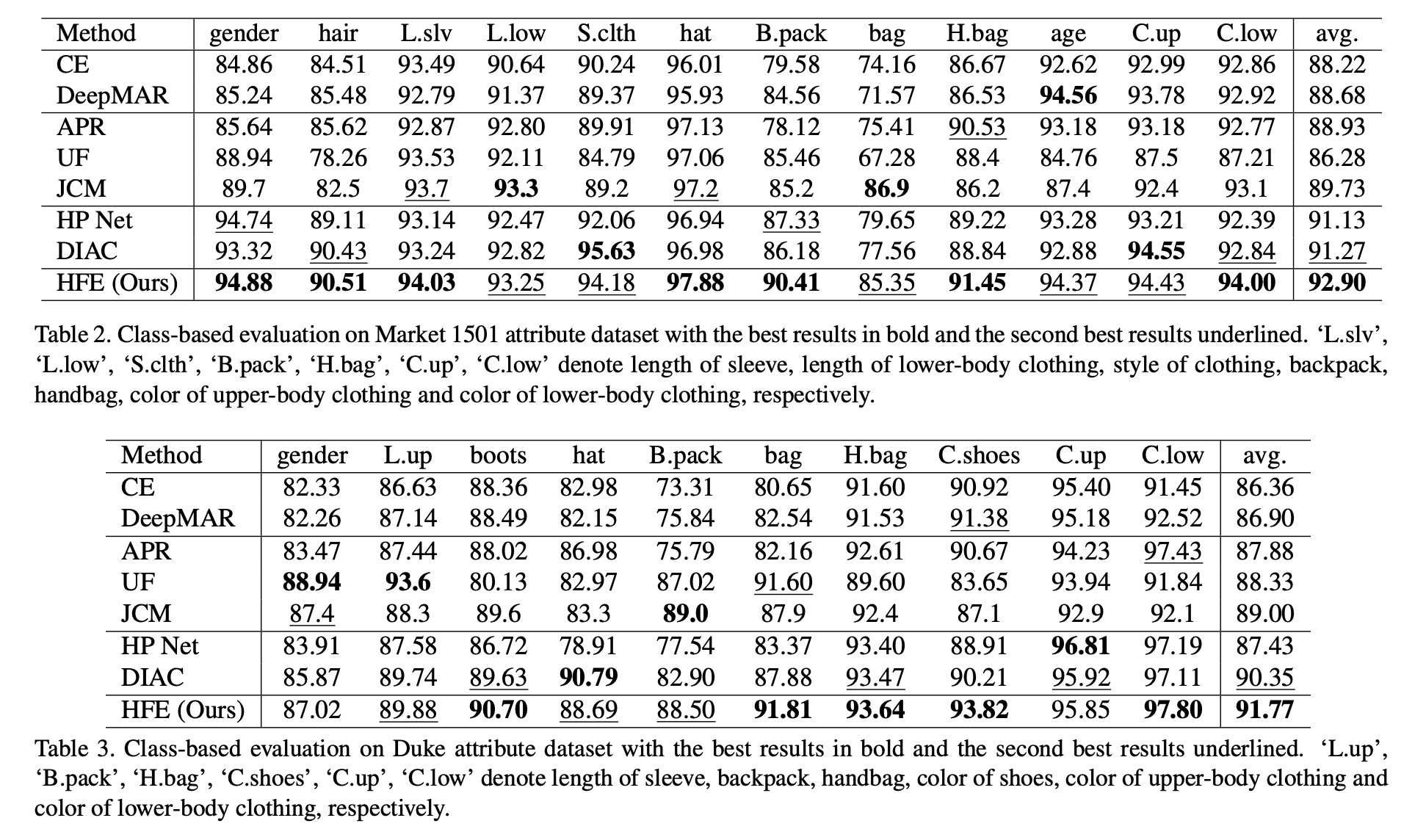

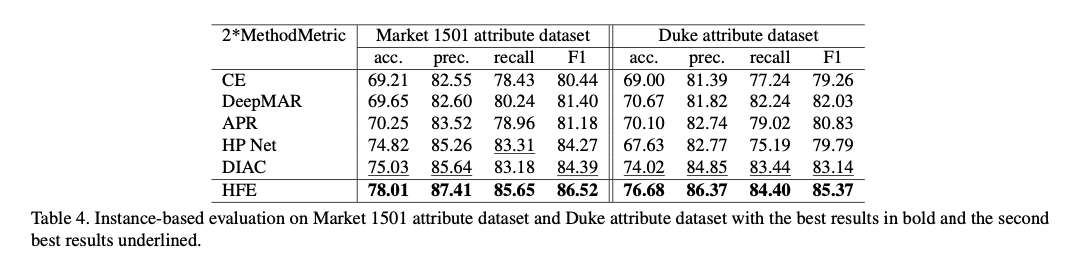

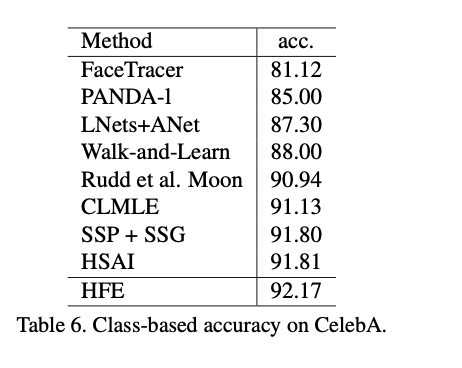

本文使用了兩個行人屬性數據集:Market 1501[1]和Duke[2],和一個人臉屬性數據集:CelebA[3],進行了實驗。在三個數據集上的實驗結果表明,HFE比現有的最先進的方法更具競爭力,如下表所示:

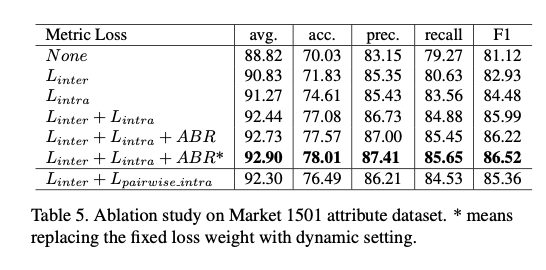

為了進一步分析各個組件的效果,我們在market 1501上做了詳盡的對比實驗,如下表所示,可以看到每個部分都是有各自的提升效果的。

為了直觀地觀察特征空間的變化,我們對一個屬性在不同loss下的特征空間進行了可視化,如下圖所示。可以看到,每增加一個組件,類內的特征都更緊密,而類間的特征距離更遠,界限更清晰。而且HFE確實可以形成更細粒度的類內特征空間,同時讓類內更緊湊,類間更清晰,滿足我們的預期。

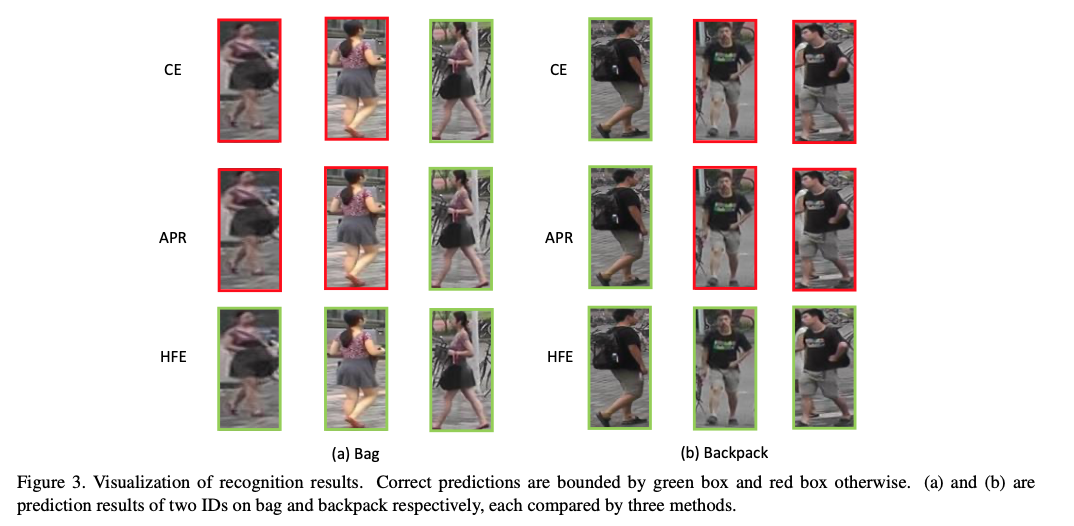

下圖為屬性可視效果對比,可以看出,對于屬性比較清晰可見時,三個方法都能判斷正確;而當遮擋發生或圖像模糊時,CE和APR[4]出現錯誤預測的概率較高,HFE卻還是能預測正確。

傳送門

論文地址:

https://arxiv.org/abs/2005.11576

歡迎感興趣的朋友閱讀和交流。

References

[1] Liang Zheng, Liyue Shen, Lu Tian, Shengjin Wang, Jing- dong Wang, and Qi Tian. Scalable person re-identification: A benchmark. In Proceedings of the IEEE international con- ference on computer vision, pages 1116–1124, 2015.

[2] ZhedongZheng,LiangZheng,andYiYang.Unlabeledsam- ples generated by gan improve the person re-identification baseline in vitro. In Proceedings of the IEEE International Conference on Computer Vision, pages 3754–3762, 2017.

[3] Ziwei Liu, Ping Luo, Xiaogang Wang, and Xiaoou Tang. Deep learning face attributes in the wild. In Proceedings of the IEEE international conference on computer vision, pages 3730–3738, 2015.

[4] Yutian Lin, Liang Zheng, Zhedong Zheng, Yu Wu, Zhi- lan Hu, Chenggang Yan, and Yi Yang. Improving person re-identification by attribute and identity learning. Pattern Recognition, 2019.

返回

返回

人工智能基礎設施

人工智能基礎設施 企業服務智能化

企業服務智能化 城市管理智能化

城市管理智能化 汽車出行智能化

汽車出行智能化 個人生活智能化

個人生活智能化