AAAI 2021 | 商湯提出BSN++: 時序動作提名生成網絡

在 AAAI 2021 上,商湯科技城市計算研發團隊提出了基于互補邊界回歸和尺度平衡交互建模的時序動作提名生成網絡(BSN++),針對現有方法存在大量邊界噪聲、缺乏提名之間的關系建模以及動作持續長度不平衡等問題進行了改進,能夠高效地給大量密集分布的候選提名生成高精度的邊界預測和可靠的置信度分數。實驗結果表明,BSN++ 在兩個著名的公開數據集上均有顯著的性能和效率提升。基于該方法,我們在 CVPR19 - ActivityNet Challenge 的時序動作檢測任務榜單上排名第一。

Part 1 任務定義和挑戰

時序動作提名任務旨在從一段未修剪的長視頻中生成包含動作發生區間(從起始到結束)的候選片段。通常認為高質量的時序動作提名應當具備兩個關鍵特性:

(1)生成的動作提名能夠在時序上完整地覆蓋動作發生的區域,并且保證有足夠高的召回和時序重疊

(2)提名的質量應當被準確地評估,從而提供一個可靠的置信度分數用于后續的檢索排序。

為了滿足這兩個條件同時實現高質量的動作提名生成,現有的時序動作提名生成方法大多遵循兩個范式。第一種是“自頂向下”的方式,候選提名大多基于滑動窗口或者是預先定義好尺度和比例且均勻分布的錨點框來進行邊界回歸,然后采用一個二分類器來評估提名的置信度分數。然而,這種方式生成的提名即使經過了多階段的邊界修正,也很難得到十分準確的邊界。在這種情況下,以BSN[1](邊界敏感網絡)為首的基于邊界概率預測的方法開創了“自底向上”范式的先河,在近年來吸引了許多學者的關注。其將輸入視頻以一種細粒度的方式進行邊界概率評估,并通過組合高概率的候選起止點生成任意長度的候選動作提名,既實現了邊界的準確性也突破了錨點框對于長度的限制。然而,盡管BSN在性能和效率上相比于前人的方法都取得了顯著的領先,我們發現它仍然存在一些弊端:

(1) 在進行邊界預測時只依賴局部的上下文信息,忽視了對整段視頻長時序的依賴,造成了很多邊界噪聲,從而精度較低。

(2) 提名的評估過程相對獨立,缺乏對相似提名之間的關系建模,存在嚴重的偏差。

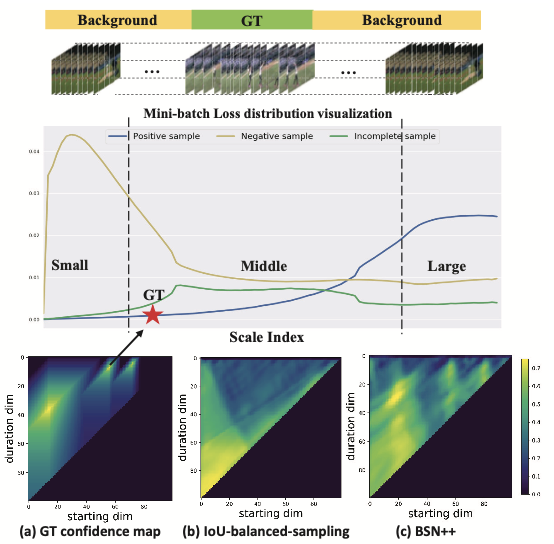

(3) 相同/不同動作之間都存在嚴重的正負樣本/持續長度的不平衡現象,長尾效應嚴重,典型數據分布如下圖所示。

(4) 效率低下。BSN通過多階段的方式分別完成邊界預測、提名生成和提名評估等過程,性能上相互制約,且效率上缺乏聯合優化,不利于實際應用的線上部署。

Part 2 方法介紹

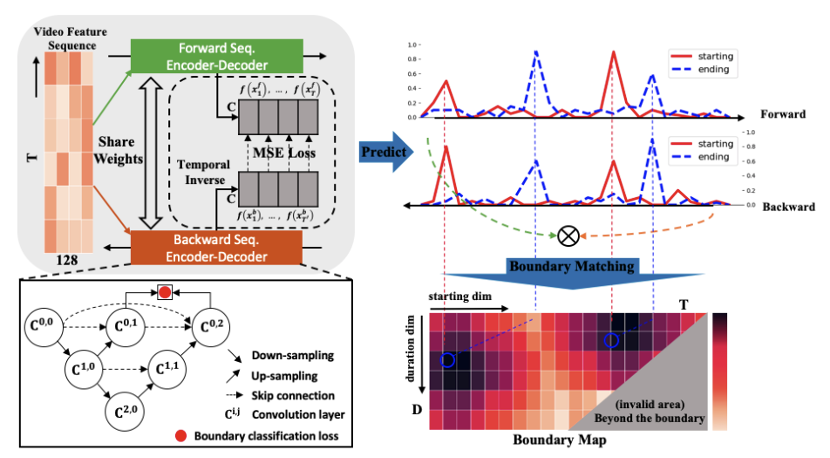

針對上述問題,我們提出了一個全新的時序動作提名生成框架(BSN++)。與BSN的多階段過程不同,BSN++實現了在一個統一框架內完成提名圖(proposal map)的生成。為了得到該提名圖,BSN++分別生成了一張邊界圖和置信度圖用來表示大量密集分布提名的邊界信息和置信度分數。如下圖所示,BSN++主要包含三個主要的模塊:基礎模塊、互補邊界生成器和提名關系建模模塊。

1. 基礎模塊

基礎模塊(Base Module)旨在處理經過雙流網絡提取好的視頻特征序列,用于進行時序關系的初步建模。同時該模塊的輸出分別作為后續兩個分支的輸入。具體來說,該模塊主要由兩層帶有 ReLU 激活函數的 1D 卷積組成,卷積核大小為 3,數量為 256,且步長為 1。由于輸入視頻的長度不一,我們將輸入視頻截斷為一系列固定長度的滑動窗口。

2. 互補邊界生成器

互補邊界生成器(Complementary Boundary Generator)主要源于受到 U-Net[3] 結構應用在醫學圖像分割上的啟發,我們認為對于時序邊界生成這種密集預測(dense prediction)的任務同樣可以通過一維的編碼-解碼器結構進行高層級全局時序信息和低層級局部時序信息的建模。如下圖所示,左下部分中的每個圓圈分別代表一個帶有 512 個卷積核且核大小為3的一維時序卷積層,并分別接著一個批歸一化層(BN)和 ReLU 激活函數。為了減小過擬合的現象,我們只添加了兩層下采樣層來增大時序的感受野,并接著采用同樣數量的上采樣層來恢復到原始的時序分辨率。此外,為了加快網絡的收斂速度,額外在中間層施加了監督信號(deep supervision)(該操作對于后續的模型剪枝同樣有幫助)。同時,通過跳層連接來縮小編碼器和解碼器之間的語義鴻溝。值得一提的是,我們發現起始邊界分類器和結束邊界分類器之間存在天然的互補性。即當視頻經過反向輸入到網絡時,起始邊界分類器(從背景到前景)可以看作是一個偽結束邊界分類器(從前景到背景)。因此,很自然地想到利用雙向的模型預測結果進行融合:

![]()

為了在訓練過程中增強模型對于邊界的魯棒性,我們實現了并行的編解碼優化過程,并在兩側的中間層輸出額外施加了一致性約束,實驗發現該策略可以顯著提升最終的邊界預測精度,抑制了邊界噪聲的出現。最終,將獲得的兩個邊界概率序列構建成一張邊界圖(boundary map)![]() ,用于表征所有密集分布提名的邊界信息,其中T和D分別代表特征序列的長度和提名的最大持續時間:

,用于表征所有密集分布提名的邊界信息,其中T和D分別代表特征序列的長度和提名的最大持續時間:

![]()

3. 提名關系建模模塊

提名關系建模模塊(proposal relation block)的目的是為了高效地評估密集分布候選提名的置信度分數。BMN[2] 提出了邊界匹配(boundary-matching)機制來實現一次性為所有候選提名進行置信度評估。然而,盡管 BMN 在生成的提名特征圖![]() 上采用了 3x3 的 2D 卷積進行局部的提名關系建模,但這顯然不足以挖掘相似動作提名之間的關系(尤其是真值 IoU 相同但動作種類/持續長度不同的動作提名),使得提名的評估過程仍然相對獨立。只是為 BSN 的提名評估模塊提供了更高效的訓練方式,并沒有從本質上解決提名評估問題。針對該問題,BSN++ 設計了一個提名關系建模模塊來分別從提名位置層面(位置感知注意力模塊)和通道表征層面(通道感知注意力模塊)進行了兩個不同維度的交互信息建模,具體過程如下圖所示。最終,三個子分支分別進行監督訓練和測試結果融合,從而達到最佳的置信度圖

上采用了 3x3 的 2D 卷積進行局部的提名關系建模,但這顯然不足以挖掘相似動作提名之間的關系(尤其是真值 IoU 相同但動作種類/持續長度不同的動作提名),使得提名的評估過程仍然相對獨立。只是為 BSN 的提名評估模塊提供了更高效的訓練方式,并沒有從本質上解決提名評估問題。針對該問題,BSN++ 設計了一個提名關系建模模塊來分別從提名位置層面(位置感知注意力模塊)和通道表征層面(通道感知注意力模塊)進行了兩個不同維度的交互信息建模,具體過程如下圖所示。最終,三個子分支分別進行監督訓練和測試結果融合,從而達到最佳的置信度圖![]() 預測質量(其中,置信度圖中像素點 (i,j) 代表一個起始點為,持續時間為的候選提名對應的置信度分數)。

預測質量(其中,置信度圖中像素點 (i,j) 代表一個起始點為,持續時間為的候選提名對應的置信度分數)。

4. 兩階段重采樣

長尾數據集中的數據不平衡問題可以嚴重影響到模型的訓練精度和泛化性能。本文回顧了數據集中的正負樣本分布以及動作持續長度的分布情況,并針對性的設計了用于提名置信度預測的重采樣策略,旨在提升在長尾數據集中的模型訓練表現。具體來說,BSN++設計了兩階段的采樣策略,不僅針對訓練過程中提名的正負樣本數量進行平衡,同時考慮了對正樣本提名中提名的時序長度進行二次平衡。

基于 IoU 平衡的采樣策略。如文章開頭的數據分布示意圖可以觀察到,正負樣本的批損失分布存在較大的差異,這種現象無疑會導致嚴重的訓練模型偏差。先前的工作通常設計了一個正負樣本的采樣器來平衡不同 IoU 區間的樣本。然而,我們發現正負樣本的持續時間同樣不遵循常規的均勻分布。因此,有必要考慮繼續對動作提名的長度進一步平衡。

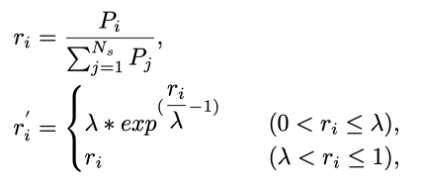

尺度平衡重采樣。為了緩解長尾尺度的問題,我們在IoU平衡采樣的基礎上提出了一個正負樣本尺度重采樣策略。具體來說,假設 ![]() 為正樣本提名中持續長度為

為正樣本提名中持續長度為 ![]() 的數量,而

的數量,而 ![]() 則為其占總提名數量的比例:

則為其占總提名數量的比例:

其中,![]() 為預先定義的歸一化尺度范圍(例如,[0-0.3, 0.3-0.7, 0.7-1.0])。通過一個正樣本比例采樣函數,得到采樣比例

為預先定義的歸一化尺度范圍(例如,[0-0.3, 0.3-0.7, 0.7-1.0])。通過一個正樣本比例采樣函數,得到采樣比例 ![]() ,且當

,且當![]() 小于 λ(根據經驗設為 0.15)時,該采樣比例將大于原始采樣比例。因此,我們將更新后的歸一化采樣比例作為某個特定提名長度區間

小于 λ(根據經驗設為 0.15)時,該采樣比例將大于原始采樣比例。因此,我們將更新后的歸一化采樣比例作為某個特定提名長度區間![]() 的采樣概率,并以此為基準構建批數據進行模型訓練。至于負樣本,采用相同的采樣過程。

的采樣概率,并以此為基準構建批數據進行模型訓練。至于負樣本,采用相同的采樣過程。

Part 3 實驗結果

1. 時序動作提名生成

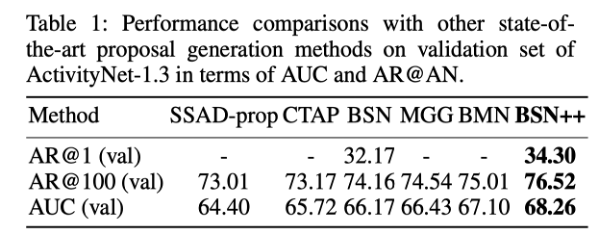

我們首先在 ActivityNet-1.3 上評估了 BSN++ 生成的時序動作提名質量,如下表所示。BSN++ 相比于之前的方法取得了更高的 AUC 指標,尤其在 AR@1 和 AR@100 指標上(Top-1/Top-100候選提名下的平均召回)相比于 BSN 提升最為明顯。可見,BSN++ 在保證高召回的前提下也提升了候選提名的整體檢索質量。

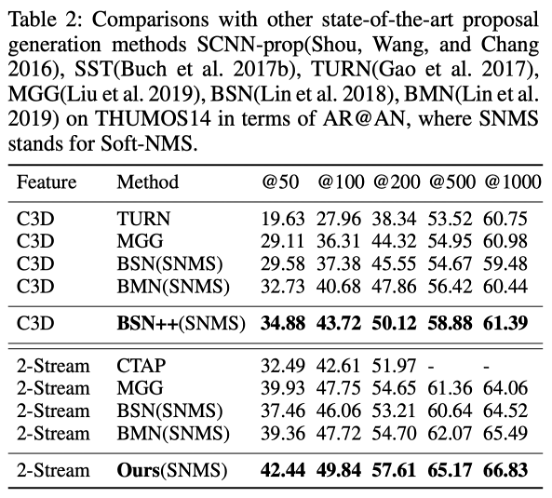

接著在 THUMOS14 上對比評估了 BSN++ 在不同輸入特征下的動作提名質量,如下表所示。可見,BSN++ 對于不同的數據集和不同的特征提取器都具有很好的魯棒性。

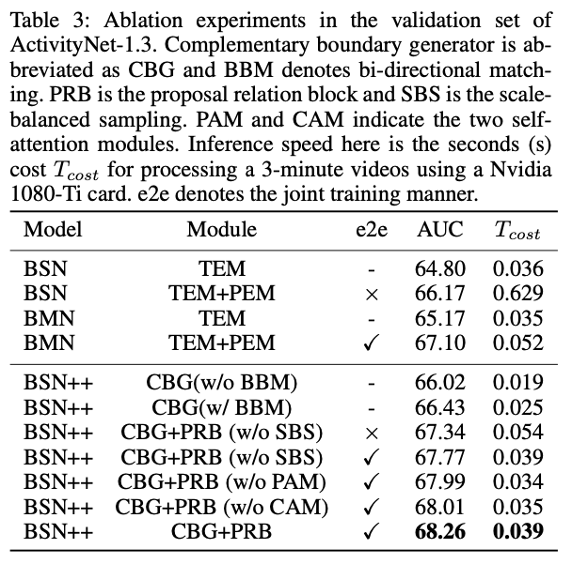

同時,在下表中還對 BSN++ 的各個模塊進行了詳細的剖析實驗,充分驗證各個模塊的有效性和互補性。并且從評估結果中我們可以總結出以下幾點結論:

(1) 編碼-解碼器結構同樣可以對一維時序信息進行“局部到全局”的充分建模,從而相比于之前只依賴于局部信息的方法有更準確的邊界預測結果;

(2) 雙向匹配機制進一步驗證了未來信息對于邊界調整決策的重要性;

(3) 與先前方法獨立評估提名不同,BSN++ 采用的提名關系建模模塊可以提供更全面的特征用于區分和評估動作提名;

(4) 尺度平衡的重采樣策略可以使得模型達到均衡優化的目的;

(5) 通過將各個模塊集成到一個端到端的框架,BSN++ 可以獲得有競爭力的結果提升;

(6) 同時,BSN++ 保證了總體的效率優勢。

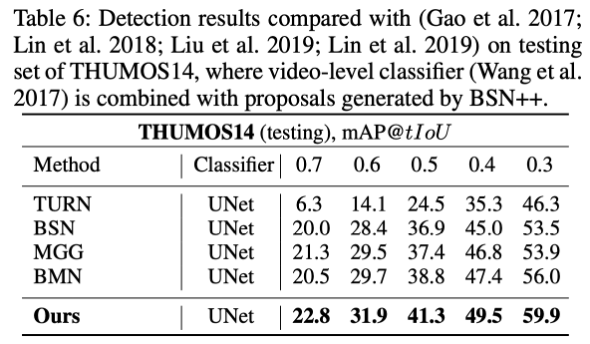

2. 時序動作檢測

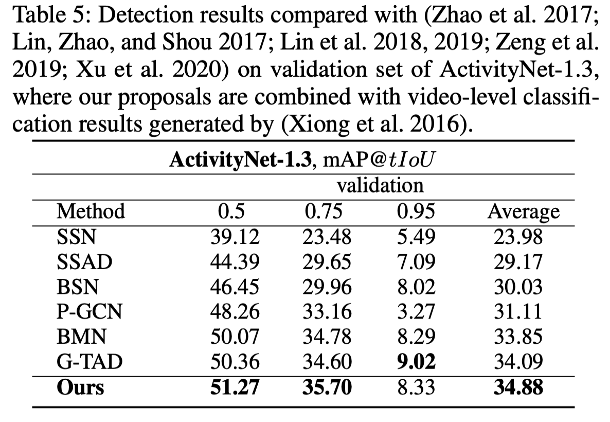

與兩階段圖像目標檢測相似,我們認為時序動作提名的質量會直接影響到時序動作檢測的性能。因此,我們將BSN++ 生成的時序動作提名結果直接賦予現有視頻分類器的分類標簽,即可得到最終的時序動作檢測結果,并用于評估模型的檢測精度(mAP)。我們分別在 ActivityNet-1.3 和 THUMOS14 數據集上進行了實驗,結果分別如下表所示。可見,BSN++ 在檢測精度上顯著提升了現有算法的水平。

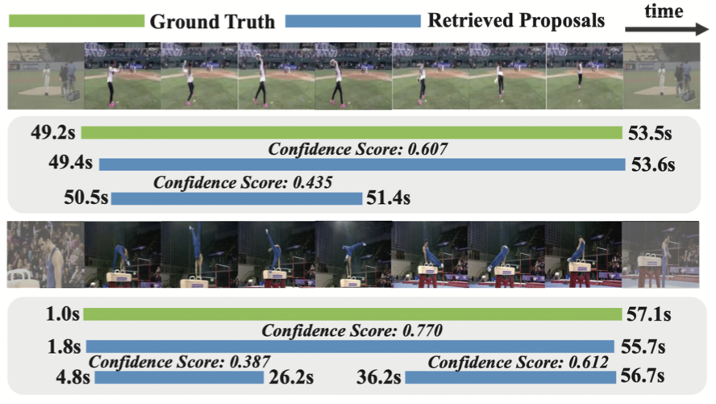

最后,我們分別在兩個數據集上隨機挑選了兩個視頻樣例及其模型預測結果進行可視化,如下圖所示。其中第一行為 THUMOS14 中的視頻,第二行為 ActivityNet-1.3 數據集中的視頻。

Part 4 結語

本文的主要貢獻在于針對現有 BSN 系列的方法存在的幾點問題進行了針對性的解決,并提出了進階版本 BSN++。通過互補邊界匹配融合的方法實現高精度的邊界預測。同時,著重解決了現有方法忽略的密集分布提名關系建模和尺度不平衡等問題,顯著提升了對于密集分布候選提名的置信度評估質量。實驗結果表明,BSN++ 在主流數據集上的算法性能和效率上均取得了一致的提升。

論文鏈接

https://arxiv.org/pdf/2009.07641v4.pdf

References

[1] Lin, T.; Zhao, X.; Su, H. BSN: Boundary sensitive network for temporal action proposal generation. In European Conference on Computer Vision (ECCV), 2018.

[2] Lin, T.; Liu, X.; Li, X.; Ding, E.; and Wen, S. BMN: Boundary-Matching Network for Temporal Action Proposal Generation. In International Conference on Computer Vision (ICCV), 2019.

[3] Zhou, Z.; Siddiquee, M. M. R.; Tajbakhsh, N.; and Liang, J. UNet++: A Nested U-Net Architecture for Medical Image Segmentation. MICCAI.

返回

返回

人工智能基礎設施

人工智能基礎設施 企業服務智能化

企業服務智能化 城市管理智能化

城市管理智能化 汽車出行智能化

汽車出行智能化 個人生活智能化

個人生活智能化