AAAI 2021 | 視頻超分中的可變形對齊解讀

在 AAAI 2021,南洋理工大學 S-Lab、香港中文大學-商湯科技聯合實驗室和中科院深圳先進技術研究院等對視頻超分辨率中的可變形對齊作出分析。可變形卷積最初是為適應對象的幾何變化而提出的,最近在視頻任務中對齊多幀時表現出出色的性能,越來越多地用于視頻超分辨率。盡管具有出色的性能,但大家對其對齊的基本機制卻沒有深入的研究。在這項研究中,本文揭示可變形對齊和光流對齊的共同點,并證明它們的偏移多樣性是帶來效果差異的關鍵點。根據探究結果,本文進一步提出了 offset-fidelity loss,該損失可以通過光流來指導偏移的學習。實驗表明,offset-fidelity loss 成功地避免了偏移量的過大,并減輕了可變形對齊訓練不穩定的問題。

論文名稱: Understanding Deformable Alignment in Video Super-Resolution

Part 1 問題和挑戰

在視頻超分中,如何有效地利用相鄰幀的信息是一個關鍵的問題。通常會采用對齊的方式來融合相鄰幀的信息。在早期的工作中[1],通常使用光流把相鄰幀的信息對齊到中間幀,再利用對齊后的圖片作為輸入,重建中間幀。近年的方法[2,3] 引入了可變形卷積作為對齊,從而更高效地利用了相鄰幀的信息。

盡管可變形對齊有一定的效果,我們對它卻理解甚少。這導致我們無法對可變形對齊進行更深入的研究。另外,在可變卷積參數的訓練中會出現不穩定情況,導致無法學習有效的偏移量,進而影響最終結果。

Part 2 可變形對齊與光流對齊之間的關系

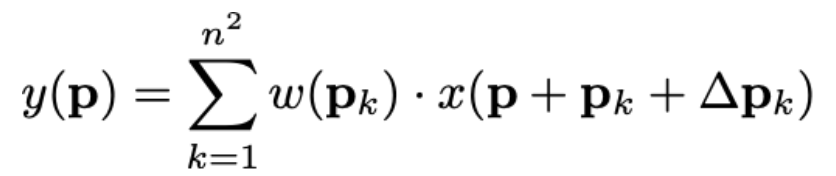

讓我們從變形卷積的表述開始:

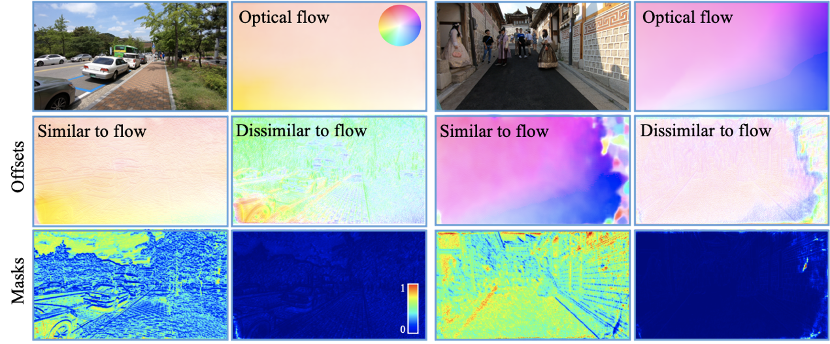

從這里看來, 變形卷積跟光流沒有直接聯系,但是對變形卷積分解,可以得出以下關系:

1) 利用![]() 作空間扭曲:

作空間扭曲:

![]()

2) 對于 ![]() 進行卷積:

進行卷積:

從上面的分解可以理解到,可變形對齊與光流對齊類似,也采用了空間扭曲。等效地,我們可以說可變形對齊和光流的區別就是偏移量(offsets)的多少。現在來看一個特例:把 n 設為 1。我們可以看到,可變形對齊就是先對特征進行扭曲,然后進行卷積。

Part 3 偏移量的可視化

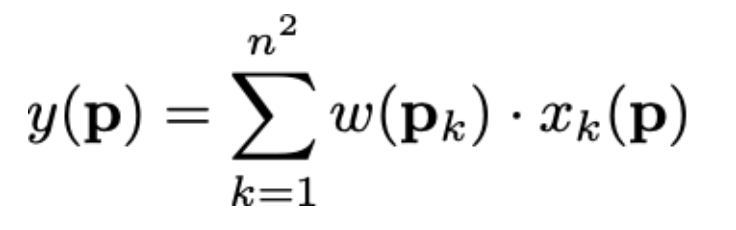

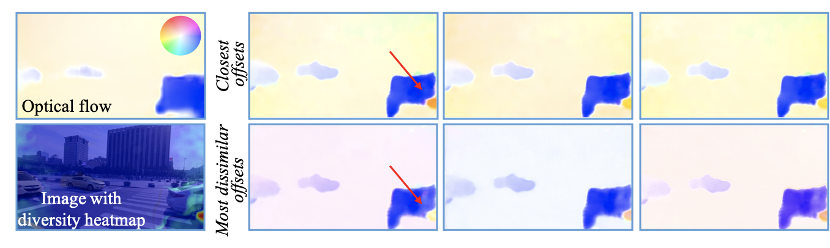

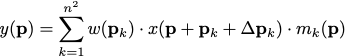

基于上面的分解,我們關心在 n=1 這個特例中,可變形對齊學習到的偏移量跟光流是不是很接近?現在我們就來比較一下。我們使用 EDVR-M 作為 baseline,并把 n 設為 1。然后我們使用 PWC-Net 的光流作為比較,可視化的結果如下:

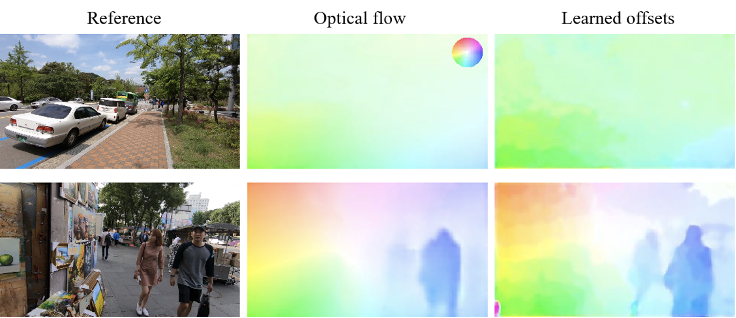

我們看到,EDVR-M 的偏移量確實跟光流非常接近。我們進一步進行定量實驗,它們的 L1 距離,發現 80%以上的距離小于 1:

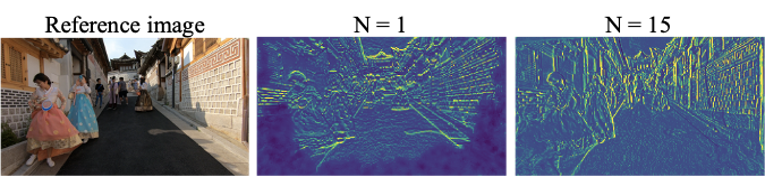

接著的問題很自然就是:那 n > 1 的時候的偏移量是怎樣?我們上面的分解使我們可以對偏移量作出跟更深入的分析:我們可以把 n2 換成任意的整數 N,這樣我們消除了可變形卷積的約束(即偏移數必須等于卷積核的平方)。現在,我們來看看 N=15 時的偏移量:

我們發現:

(1) 仍然有很大部分的偏移量跟光流接近;

(2) 有部分偏移量跟光流差異非常大,但它們的分別只在方向(顏色),整體形狀卻是非常接近。這說明物體運動在可變形對齊中仍然是非常重要的。

另外,我們計算偏移量的標準偏差, 發現在物體邊界和圖像邊界(對齊相對困難的地方),偏移量的標準偏差是普遍較大的。這個發現也解釋了為什么可變形對齊優于比光流對齊:不同的偏移量是相互補充的。它們允許網絡聚合來自不同位置的信息。這在光流不好的區域特別有效。

Part 4 可變形對齊的優點

如上面提及,在物體邊界和圖像邊界,也是比較難對齊的地方,可變形對齊的偏移量的多樣性會更大,這對于特微對齊有著很顯著的作用,如下圖所示:

因為旋轉的原因,光流未能找到對應的地方,導致深色(數值等于0)部分的出現。相反地,當 N=15 時,網絡可以從特征的其他地方獲取信息,對齊后的特征也比較連貫。更好地對齊也為超分效果帶來提升:

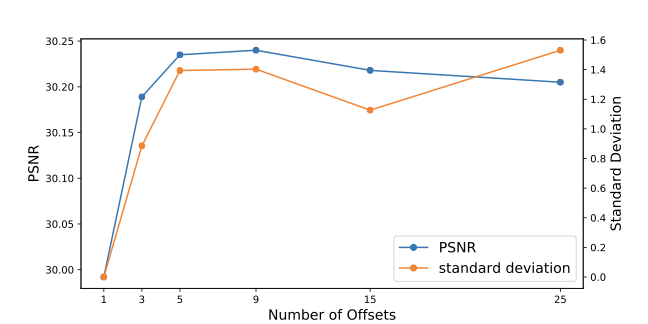

從上圖我們可以看出:

(1) 當把偏移量的數量增加,其多樣性也會增加;

(2) PSNR 和多樣性呈正相關;

(3) 當 N 增加到某個數量時,PSNR 和多樣性都會達到飽和。

從以上實驗我們可以看到,偏移量的多樣性是為可變形對齊帶來效果提升的主要原因,但實際上我們需要選擇一個適合的數量,否則會為網絡帶來不必要的計算量。

Part 5 變形組的貢獻

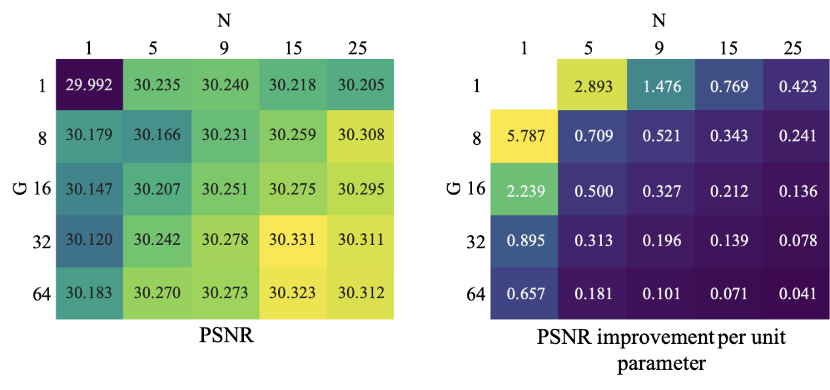

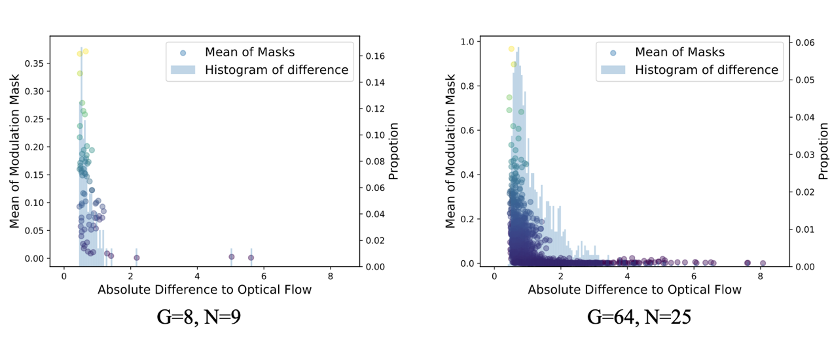

除了增加偏移量的數量,多樣性還可以通過增加變形組的數量來實現。假設有 G 個變形組,channel 數是 C。我們首先會把 feature 分成 G 組,每一組學習 N 個偏移量。這樣一來,就會學習共 GxN 個偏移量。我們發現,上述的分析也適用于 G:

如右上圖顯示,無論通過增加 G 或是 N 來提升多樣性,都會出現飽和的情況。

Part 6 可變形卷積中的Modulation mask

在調制可變形卷積(又稱為DCNv2)[4] 中,學習了額外的 modulation mask 以進一步增強操縱空間支撐區域的能力:

在現有的可變形對齊中,都是使用了 modulation mask。我們接下來看看 modulation mask 的具體作用。

從上圖可以得出,mask 對于每個偏移量學習一個權重,較接近光流的偏移量權重較大,相反則較小。

從上圖的定量實驗也可以看出,跟光流差別較大的,權重會較低。另外,當偏移量的數目增加后,大部份的權重量有著非常小的值,側面解釋了表現飽和的情況。

Part 7 Offset-Fidelity Loss

我們可以看到可變形對齊的優點,但訓練可變形對齊尤其是在大模型中,是極度不穩定的。在此情況下,偏移量會變得非常大,導致網絡無法從相鄰幀得到有效信息,變成一個單幀超分網絡。

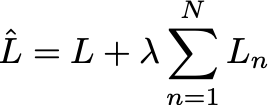

基于我們的分析,光流和偏移量的關系使我們能夠利用光流有效地對偏移量作出約束。最簡單的方法就是利用 L1 或 L2 loss 限制光流和偏移量的距離。但是這個方法無可避免地減少了偏移量的多樣性,而我們的分析證明了這些多樣性是非常重要的。所以,我們做了一個簡單而有效的操作:只對明顯跟光流不同的偏移量作出限制,而和光流接近的不給予限制。這個操作能夠使用單位階躍函數來表示:

![]()

這里的 H 是單位階躍函數,i 和 j 是空間坐標,x 和 y 是偏移量和光流。L 是原來的損失,例如跟 GT 的 L2 損失。

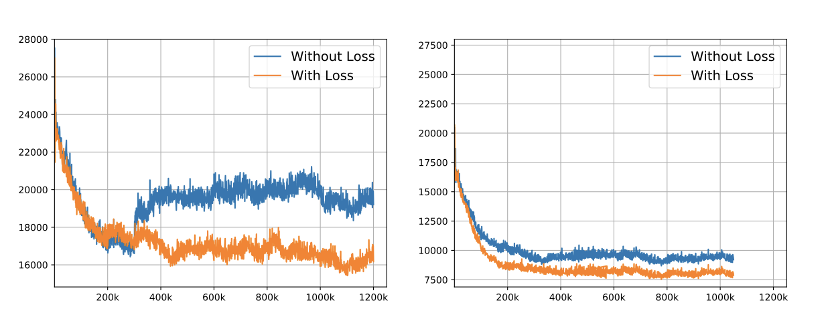

通過這個損失,我們限制偏移量的同時保持多樣性,穩定了可變形對齊的訓練穩定性。下面的定性和定量比較顯示了 offset-fidelity loss 的有效性:

如果沒有 offset-fidelity loss,偏移量變得非常大。相反,我們可以看到,加上 loss,偏移量變得可解釋,而且同時跟光流有著明顯的差別。

從 loss curve 我們可以看到 offset-fidelity loss 能夠有效地穩定訓練,實現較小的損失值。

Part 8 結語

可變形對齊在視頻超分辨率中的成功引起了極大關注。在這項研究中,我們發現了變形對齊和光流對齊之間在概念和行為上的內在聯系。對于光流對齊,我們的工作放寬了可變形卷積對偏移數量的約束。它提供了一種更加靈活的方法來增加光流對齊中的偏移量多樣性,從而改善了輸出質量。至于可變形對齊,我們的研究使我們能夠了解其潛在機制,從而有可能激發新的對齊方法。根據我們的分析,我們提出了 offset-fidelity loss,以減輕訓練過程中的穩定性問題。

另外, 大家也可以關注一下我們 2020 年在圖像和視頻超分的新工作~

GLEAN: https://ckkelvinchan.github.io/projects/GLEAN/

BasicVSR: https://ckkelvinchan.github.io/projects/BasicVSR/

論文鏈接

https://arxiv.org/abs/2009.07265

作者介紹

陳焯杰 (Kelvin C.K. Chan) | 南洋理工大學 S-Lab 和 MMLab 三年級博士生。導師是呂健勤 (Chen Change Loy) 副教授。當前主要研究興趣為圖像和視頻還原,主要包括超分辨率和去模糊等。

個人主頁:

https://ckkelvinchan.github.io/

References

[1] Xue, Tianfan, et al. "Video enhancement with task-oriented flow." International Journal of Computer Vision 127.8 (2019): 1106-1125.

[2] Tian, Yapeng, et al. "Tdan: Temporally-deformable alignment network for video super-resolution." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2020.

[3] Wang, Xintao, et al. "Edvr: Video restoration with enhanced deformable convolutional networks." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops. 2019.

[4] Zhu, Xizhou, et al. "Deformable convnets v2: More deformable, better results." Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2019.

返回

返回

人工智能基礎設施

人工智能基礎設施 企業服務智能化

企業服務智能化 城市管理智能化

城市管理智能化 汽車出行智能化

汽車出行智能化 個人生活智能化

個人生活智能化